#64 Section 19 回帰(8)まとめ

>100 Views

February 09, 26

スライド概要

さて、Pycaretでの回帰はいかがでしたか?

#57 Section 12~#63 Section 18を振り返ってみましょう!

出力された評価結果、分析結果を詳しく説明しましたが、最低限、下記のコードを書けば、機械学習の『回帰』で分析することができます。

新たなデータを作成してそれを予測するコードを加えても全部で19行!

コードを書くのが億劫だと思っている方でも、どんどん出力が出ますので、さまざまな種類の機械学習を体験していきましょう。

次回からは、クラスタリング(Clustering)を体験していきます!

すべてのビジネスパーソンが意思決定プロセスにデータを活用する思考を身につけるため、まずは、データサイエンスの分析を体験していきましょう。SECIモデルの最初の段階、共同化(Socialization)からはじめていきます。 下記のブログで、ここにアップしたスライド、動画を随時、公開中です。 【ブログ】https://tutorial4datascience.blogspot.com/ 【Youtubeチャンネル】https://www.youtube.com/@DataScience_for_everyone 【Kindle】そして、このブログをまとめて書籍にしました! https://amzn.to/4ryVppn https://amzn.to/4pGgFb1

関連スライド

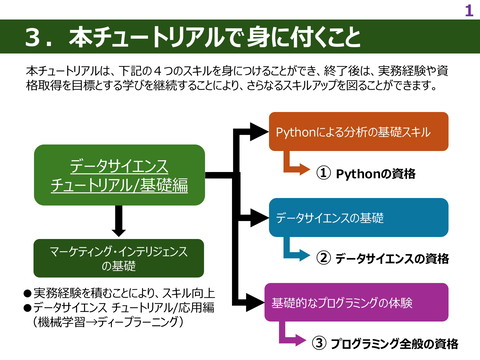

データサイエンス関連資格

データサイエンス関連の資格_後編

各ページのテキスト

4th STEP 機械学習 Section 19 回帰(8) まとめ Setup Compare Models Analyze Model データサイエンス チュートリアル Prediction Save Model 1

4th STEP 機械学習 Section 19 回帰(8)まとめ まとめ 最低限、下記のコードを書けば、機械学習の『回帰』で分析することができます。ただし、結果の評価や比較などは、統計的 な理解が必要になります。 ① ② ③ ⑥ evaluate_model(best) !pip install pycaret[full] import pycaret pycaret.__version__ ※ 一つ一つ別個に 評価指標のグラフを 描くこともできます。 ### load sample dataset from pycaret dataset module from pycaret.datasets import get_data data = get_data('insurance') # import pycaret regression and init setup from pycaret.regression import * s = setup(data, target = 'charges', session_id = 123) ④ best = compare_models() plot_model(best, plot = 'residuals') plot_model(best, plot = 'error') plot_model(best, plot = 'feature') predict on test set ⑦ #holdout_pred = predict_model(best) ⑧ # show predictions df holdout_pred.head() ⑨ # copy data and drop charges new_data = data.copy() new_data.drop('charges', axis=1, inplace=True) new_data.head() # compare baseline models ⑤ #choose catboost to avoid plot errors with some models best = create_model('catboost') データサイエンス チュートリアル 2

4th STEP 機械学習 Section 19 回帰(8)まとめ まとめ ⑩ # predict model on new_data predictions = predict_model(best, data = new_data) predictions.head() ⑪ # save pipeline save_model(best, 'my_first_pipeline') ⑫ このチュートリアルでは、 compare_models関数で求めたbestなモデルでは なく、CatBoostで予測を行っています。 # load pipeline loaded_best_pipeline = load_model('my_first_pipeline') loaded_best_pipeline CatBoostは勾配ブースティングの一種で、ロシアの検索エンジンで有名な Yandex社によって開発され、2017年4月にリリースされました。実際Yandex の検索アルゴリズムにはCatBoostが使用されてるそうです。 名前の通り『Categorical Features (カテゴリカル変数)』が多いデータに強い です。 ここ数年注目を浴びてきた勾配ブーストモデルには XGBoost (2014年3月) や LightGBM (2017年1月) もありますが、CatBoostは最も新しく、場合に よっては、この2つを上回る精度を出すことも可能です。 カテゴリカル変数が多いデータの回帰では、CatBoostが第一選択ということで しょうか。 【出典】 https://qiita.com/shuva/items/50151e5adb13385e4b2c データサイエンス チュートリアル 3