【論文サーベイ】Model Merging in the Parameter Space

718 Views

January 13, 25

スライド概要

Web Developer / Research on generative models and continual learning

関連スライド

各ページのテキスト

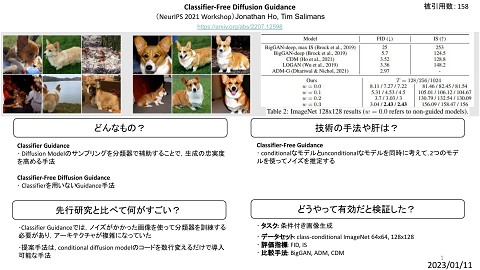

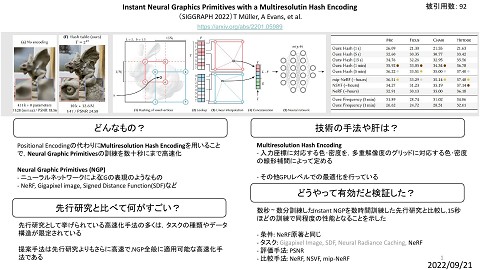

Model Merging in the Parameter Space Merging Models with Fisher-Weighted Averaging M. Matena, C. Raffel [NeurIPS’22] TIES-Merging: Resolving Interference When Merging Models P. Yadav, D. Tam, L. Choshen, C. Raffel, M. Bansal [NeurIPS’23] Language Models are Super Mario: Absorbing Abilities from Homologous Models as a Free Lunch L. Yu, B. Yu, H. Yu, F. Huang, Y. Li [ICML’24] 1

Background Task Vector [ICLR’23] - 事前学習モデル と FineTune モデル のパラメータの差分を Task Vector と定義する - Task Vector の算術によりタスクの学習・忘却が可能 2

Merging Models with Fisher-Weighted Averaging M. Matena, C. Raffel [NeurIPS’22] - Fisher-Merge と呼ばれる手法 - パラメータ パラメータ - で表される 個のモデルをマージして を持つモデルを作ることが目標 パラメータごとの重要度を加味してマージする 3

Isotropic Merging - - - 各モデルの事後分布 精度行列を意味する に Isotropic Gaussian を仮定する 個のモデルのマージを次の最適化問題と考える 解は 平均化マージ になっている 4

Isotropic Merging (Per-model weights) - 各モデルの事後分布 - 重み - 解は に Isotropic Gaussian を仮定する を考慮した最適化問題を考える 重み付きマージ になっている 5

Laplace Approximation の導入 - 平均化マージはモデルの事後分布にIsotropic Gaussian を仮定していた - この仮定は単純すぎて性能劣化につながる - Laplace Approximation を導入 - 対数尤度関数をモード周辺でテイラー展開(2次近似) する 6

補足: 対数尤度関数の Laplace Approximation - モード - 両辺の対数を外すと - 周辺でのテイラー展開を考える を精度行列 (分散・共分散行列の逆行列) とする Gaussian による近似 7

Fisher Matrix - スコア関数 - ニューラルネットワーク の分散を Fisher 情報量 (多変量の場合 Fisher Matrix) という の Fisher Matrix は次で得られる と同じ形 - Fisher 情報量 は 直感的にはパラメータの重要度を表す - Fisher 情報量 が大きい そのパラメータを動かすと がばらつく 8

Fisher Merge - 各モデルの Fisher Matrix を計算し Fisher Matrix を 精度行列 とする事後分布 - - を仮定する 個のモデルを合わせた最適化推定を考える 解は 9

備考 - Fisher 情報行列は だけメモリを消費するので 実際には次の値を使う 10

TIES-Merging: Resolving Interference When Merging Models P. Yadav, D. Tam, L. Choshen, C. Raffel, M. Bansal [NeurIPS’23] - モデルマージした際に生じる パラメータの干渉 を取り除きたい - そのために3つの処理 (Trim, Elect Sign, Disjoint Merge) を導入する 11

タスクベクトルの冗長性 タスクベクトルの中から値が大きい順にTop-20% だけを使っても精度が良い 値が小さいパラメータは重要ではないが,モデルマージに悪影響を及ぼす パラメータの干渉 12

パラメータの干渉 (タスクベクトルの干渉 ) 1. Redundant Parameter による干渉 Model 2 のタスクベクトルでは大きい値だが Model 1では小さい値 2. Sign Conflict による干渉 Model 2 のタスクベクトルでは大きい値だが Model 1では逆向きの大きくない値 平均をとったら値が小さくなってしまう 13

TRIM, ELECT SIGN & MERGE (3) sign vector と同じ符号の パラメータだけを uniform merge (1) redundant parameterを0にする (2) パラメータごとに多数決で符号を決める (-> sign vector) 14

TRIM, ELECT SIGN & MERGE TRIM 値が大きい top k のパラメータを保持し すべてのタスクについて それ以外を0にする ELECT SIGN パラメータごとの符号 (+1, 0, -1) を考え 総和をとったベクトルを作る MERGE パラメータごとに ELECT SIGN と同じ符号の タスクベクトルについてのみ 平均 をとる 15

Language Models are Super Mario: Absorbing Abilities from Homologous Models as a Free Lunch L. Yu, B. Yu, H. Yu, F. Huang, Y. Li [ICML’24] PEFTを使わずに Supervised FineTuning (SFT) を対象としたモデルマージ手法(DARE) TIES-Merging と同様に パラメータの冗長性に着目した手法 16

DROP & RESCALE delta parameters (タスクベクトル) を考える DROP ランダムに の要素を0にする RESCALE 残った要素をスケーリングする 17

SFT における冗長性 タスクベクトルの要素を9割 dropしても精度劣化が起きない パラメータ数が多ければdropする割合を増やしても精度劣化が起きない 18

Rescale の重要性 Rescale は drop の前後でモデルの出力の期待値を変えないために行う Rescale しないと drop に対しての頑健性を失う 19

実験結果 DARE を他の手法と組み合わせて実験 20

結論 - タスクベクトルから必要なパラメータだけを選んでマージすることが重要 21