DL_Keras

>100 Views

November 28, 24

スライド概要

医学生。AIや業務・学習効率化に興味あり。

関連スライド

SP_Librosa

DL_PyTorch

各ページのテキスト

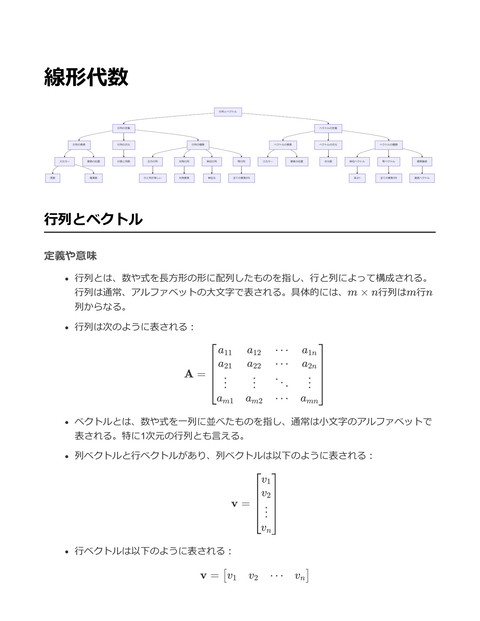

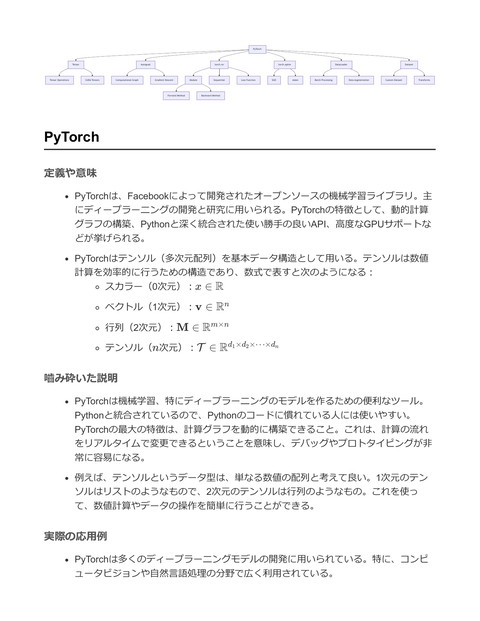

Keras Model compile fit Layer evaluate predict Dense Conv2D Pooling Sequential Dropout BatchNormalization Simple Network Functional API Complex Network Multiple Inputs/Outputs Callback EarlyStopping Optimizer ModelCheckpoint SGD Loss Function Adam CategoricalCrossentropy Metric MeanSquaredError Accuracy Precision Keras 定義や意味 KerasはPythonで書かれた高水準ニューラルネットワークAPIであり、TensorFlow、 Microsoft Cognitive Toolkit、Theano、PlaidMLなどのディープラーニングフレームワ ークの上で動作する。Kerasはモデルの簡素な構築を可能にし、迅速なプロトタイピ ングを支援することを目的としている。 Kerasはシンプルで統一されたAPIを提供し、ユーザーがニューラルネットワークモデ ルを簡単に設計、構築、訓練できるようにする。 Kerasの基本的なビルディングブロックはレイヤー(Layer)であり、これを用いてニ ューラルネットワークを構成する。 嚙み砕いた説明 Kerasは、初心者でも簡単にディープラーニングモデルを作成できるように設計され たツールキット。プログラミング経験が少なくても、簡単に強力なAIモデルを作成で きる。 例えば、モデルを作成する際には「Sequential」モデルを使ってレイヤーを積み重ね ていくだけで、複雑なモデルを簡単に構築できる。 直感的なインターフェースと豊富なドキュメントにより、研究者や開発者が新しいア イデアをすばやく試すことができる。 実際の応用例 Kerasは画像認識、音声認識、自然言語処理など、多くの分野で使用されている。特 にプロトタイプを素早く作成し、アイデアを検証する際に重宝される。 以下はKerasを用いた簡単なニューラルネットワークモデルの構築例:

from keras.models import Sequential from keras.layers import Dense # モデルの初期化 model = Sequential() # 入力層と隠れ層を追加 model.add(Dense(units=64, activation='relu', input_dim=100)) # 出力層を追加 model.add(Dense(units=10, activation='softmax')) # モデルのコンパイル model.compile(loss='categorical_crossentropy', optimizer='sgd', metrics=['accuracy']) # モデルのサマリーを表示 model.summary() このコードは、入力の次元が100のデータに対して、64ユニットの隠れ層と10ユニッ トの出力層を持つシンプルなニューラルネットワークを構築する。 relu は活性化関 数の一つで、 softmax は多クラス分類における出力層で使用される。 model.compile では損失関数やオプティマイザ、評価指標を指定で き、 model.summary() でモデルの構造を確認できる。 モデル (Model) 定義や意味 モデルとは、特定の問題に対する解決策を数学的に表現したものであり、入力データ を元に予測や分類を行うための関数である 一般に、機械学習やディープラーニングにおけるモデルは、入力データ X を出力デ ータ Y にマッピングする関数 f : X → Y として表現される モデルは、トレーニングデータを用いて学習し、パラメータを最適化することで性能 を向上させる ^ , Y ) を最小化する問題として定式化される モデルの最適化問題は、損失関数 L(Y

min L(f (X; θ), Y ) θ ここで、θ はモデルのパラメータである 嚙み砕いた説明 モデルとは、データを入力すると何らかの出力を生成する数学的な関数のこと 例えば、手書き数字の画像を入力すると、その数字が何かを答えてくれるような仕組 み このモデルは、データを通じて学習することで、与えられた問題を解くために調整さ れていく 実際の応用例 モデルは、画像認識、音声認識、自然言語処理、ゲームAIなど、様々な分野で利用さ れている 特にKerasは、簡単にディープラーニングのモデルを構築し、訓練するためのライブ ラリである 以下にKerasを用いて簡単なニューラルネットワークモデルを構築する例を示す from keras.models import Sequential from keras.layers import Dense # モデルの構築 model = Sequential() # 入力層と隠れ層の追加 model.add(Dense(units=64, activation='relu', input_dim=100)) # 出力層の追加 model.add(Dense(units=10, activation='softmax')) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # モデルの概要を表示 model.summary() この例では、100次元の入力を持ち、64ユニットの隠れ層を持つモデルを構築

出力層は10ユニットのソフトマックス活性化関数を使用しており、10クラスの分類を 行う設定 モデルはAdamオプティマイザとカテゴリクロスエントロピー損失を使用してコンパ イルされる Layer 定義や意味 レイヤーは、ニューラルネットワークにおける基本的な構成要素であり、入力データ に対する計算を行う一種の関数 レイヤーは、入力テンソルを受け取り、出力テンソルを生成する。テンソルの形状や 計算内容はレイヤーの種類に依存 レイヤーの種類には、全結合層(Dense Layer)、畳み込み層(Convolutional Layer)、プーリング層(Pooling Layer)などがある 数式的には、レイヤーは関数 f として表現され、入力テンソル x に対して出力テン ソル y を生成する: y = f (x) 嚙み砕いた説明 レイヤーは、ニューラルネットワークの建物のブロックのようなもので、データを受 け取って何らかの変換を行う 例えば、画像を入力とする場合、畳み込み層は画像の特徴を抽出する役割を果たし、 全結合層は最終的な分類を行う レイヤーを積み重ねることで、入力データから複雑なパターンを学習できる 実際の応用例 Kerasを用いたニューラルネットワークの構築において、レイヤーはモデルの基本単 位として使われる 以下にKerasを用いた簡単なモデルの例を示す。ここでは、入力層、隠れ層(全結合 層)、出力層を持つシンプルなニューラルネットワークを定義

from keras.models import Sequential from keras.layers import Dense # モデルの初期化 model = Sequential() # 入力層と1つ目の隠れ層を追加(入力次元は10、ユニット数は64) model.add(Dense(units=64, activation='relu', input_dim=10)) # 2つ目の隠れ層を追加(ユニット数は64) model.add(Dense(units=64, activation='relu')) # 出力層を追加(ユニット数は1、線形活性化関数) model.add(Dense(units=1, activation='linear')) # モデルの概要を表示 model.summary() 上記の例では、 Sequential モデルを用いてレイヤーを順に追加している Dense レイヤーは全結合層であり、ユニット数と活性化関数を指定している model.summary() を呼び出すことで、モデルの構造を確認可能 Sequential 定義や意味 Sequentialは、Kerasで用いられるモデルの一つで、レイヤーを線形に積み重ねていく 形のニューラルネットワークを構築する際に使用する。 各レイヤーは順番に次のレイヤーに出力を渡すため、モデルの構造が直線的である。 Sequentialモデルは、入力層から出力層までの一連のレイヤーを順番に定義し、それ らを積み重ねることでモデルを作成する。 数式で表すと、各層の出力 hi は次の層の入力となり、以下のように表現できる: hi+1 = f (Wi hi + bi ) ここで、f は活性化関数、Wi は重み行列、bi はバイアス項を表す。

嚙み砕いた説明 Sequentialモデルは、レゴブロックを積み上げるように、レイヤーを一つずつ順番に 追加していくイメージ。 例えば、最初に入力層を置き、その次に隠れ層、最後に出力層を順番に配置する。 このモデルはシンプルで使いやすく、特に入力が1次元で、各ステップが順番に処理 される場合に適している。 実際の応用例 Sequentialは、画像分類や自然言語処理のようなタスクで、シンプルなフィードフォ ワードネットワークを構築する際に用いられる。 以下はKerasを用いて、Sequentialモデルを構築する例: from keras.models import Sequential from keras.layers import Dense, Activation # Sequentialモデルのインスタンスを作成 model = Sequential() # 入力層と1つ目の隠れ層を追加 model.add(Dense(units=64, input_dim=100)) model.add(Activation('relu')) # 2つ目の隠れ層を追加 model.add(Dense(units=64)) model.add(Activation('relu')) # 出力層を追加 model.add(Dense(units=10)) model.add(Activation('softmax')) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # コメントアウトで説明 # - model.add(Dense(...)) は新しい層を追加する # - 'relu' と 'softmax' は活性化関数の種類 # - compile メソッドはモデルを訓練する準備をする

このコードスニペットは、入力次元が100のデータに対して、2つの隠れ層と1つの出 力層を持つモデルを構築し、分類タスクに適した設定を行っている。 Functional API 定義や意味 Functional APIは、Kerasにおけるモデル構築のための方法の一つ。Sequential APIと は異なり、より柔軟なモデルの構築が可能になる Functional APIは、任意のグラフ構造を持つニューラルネットワークを構築するため に用いる。すなわち、マルチ入力およびマルチ出力のモデル、共有レイヤーを使用す るモデル、任意の接続パターンを持つモデルを構築できる モデルは、テンソルを入力として受け取り、テンソルを出力する関数として定義され る 嚙み砕いた説明 KerasのFunctional APIは、モデルを関数のように扱うことができる。これは、入力デ ータを受け取り、出力データを返すという単純な関数の概念を基にしている 例えば、Sequential APIでは、モデルは単純にレイヤーを積み重ねることしかできな いが、Functional APIを使うと、レイヤーを自由に組み合わせて、複雑なネットワー クを構築することが可能になる。これは、複数の入力を持つモデルや、複数の出力を 持つモデルを作る際に非常に便利 Functional APIを使うことで、モデルの設計がより柔軟になり、特定の問題に対して 最適なアーキテクチャを選択することが容易になる 実際の応用例 Functional APIは、以下のような場面で応用されている 複数の入力を持つモデル(例:画像とテキストを同時に処理するモデル) 複数の出力を持つモデル(例:物体の検出と分類を同時に行うモデル) 再帰的な接続を持つモデル(例:Residual NetworksやInceptionモデル) レイヤーを共有するモデル(例:Siamese Networks) 以下に、Functional APIを用いて2つの入力を持ち、1つの出力を持つモデルの例を示す。

from keras.layers import Input, Dense, concatenate from keras.models import Model # 2つの入力テンソルを定義 input_a = Input(shape=(64,)) input_b = Input(shape=(64,)) # 入力テンソルに対するレイヤーを定義 x = Dense(32, activation='relu')(input_a) y = Dense(32, activation='relu')(input_b) # 結合レイヤー combined = concatenate([x, y]) # 出力レイヤー z = Dense(1, activation='sigmoid')(combined) # Modelを定義 model = Model(inputs=[input_a, input_b], outputs=z) # モデルのコンパイル model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy']) # モデルの概要を表示 model.summary() このコードでは、64次元の2つの入力を持つニューラルネットワークを構築している 各入力は、32ユニットのDenseレイヤーを通過し、その後結合されて最終的に1ユニ ットの出力を持つDenseレイヤーにより出力される Functional APIを使うことで、複雑なネットワークの設計が可能になり、異なる入力 データを一つのネットワークで処理するための柔軟性が提供される Callback 定義や意味 コールバック(Callback)とは、あるイベントや条件が発生した際に実行される関数 や手続きのことを指す。コールバックは非同期処理や、イベント駆動型プログラミン グで頻繁に使われる。特に、特定の処理を完了した後に呼び出される関数として定義 されることが多い。

プログラムの流れを制御するために、関数へのポインタや参照を他の関数に渡し、そ の関数内で特定のタイミングで実行される仕組み。 嚙み砕いた説明 コールバックは、プログラムが特定のタスクを完了したときや、ある条件が満たされ たときに呼び出される特別な関数のこと。たとえば、ボタンがクリックされたときに 何かの処理を実行したい場合、その処理をコールバックとして登録しておくと、クリ ック時に自動的にその関数が呼び出される。 音楽プレーヤーを考えると、曲が終わったら次の曲を再生するという処理をコールバ ックで指定することで、自動的に次の曲を再生することができる。 実際の応用例 コールバックは、特に機械学習フレームワークであるKerasにおいて、モデルの訓練 中に特定のイベントが発生したときに実行する処理を記述するために使われる。たと えば、エポックの終了時や、一定の精度に到達したときに実行するカスタム処理があ る。 以下はKerasにおけるコールバックの例。訓練の途中でモデルの精度を監視し、改善 が見られた場合にモデルを保存する処理を行う。

import tensorflow as tf from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense from tensorflow.keras.callbacks import ModelCheckpoint # モデルの定義 model = Sequential([ Dense(64, activation='relu', input_shape=(784,)), Dense(10, activation='softmax') ]) model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accura # コールバックの定義 checkpoint_callback = ModelCheckpoint( filepath='best_model.h5', # 保存するモデルのファイルパス save_best_only=True, # ベストモデルのみを保存 monitor='val_accuracy', # モニターする指標 mode='max', # 最大化を目指す verbose=1 # ログ出力を有効化 ) # モデルの訓練 model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val), callbacks=[checkp このコードでは、 ModelCheckpoint コールバックを使用して、検証データに対する精 度が改善された場合に自動的にモデルを保存する処理を行っている。これにより、最 もパフォーマンスの良いモデルが保存される。 Optimizer 定義や意味 オプティマイザー(Optimizer)とは、機械学習モデルの重みを更新するためのアルゴ リズムまたは手法を指す。特にニューラルネットワークのトレーニングにおいて、損 失関数を最小化するために用いられる。 オプティマイザーは、勾配降下法(Gradient Descent)やそのバリエーションを用い て、学習率(learning rate)に基づいて重みを調整する。 数式的には、重みの更新は次のように表現される:

wt+1 = wt − η ⋅ ∇L(wt ) ここで、wt は時刻tの重み、η は学習率、∇L(wt )は重みに関する損失関数の勾配を示 す。 嚙み砕いた説明 オプティマイザーは、モデルが予測をより良くするために学習を助けるアルゴリズム のこと。具体的には、モデルが出す予測と実際の結果の違いを少なくするために、モ デルの「設定(重み)」を少しずつ調整する役割を担う。 例えば、勾配降下法は坂を下るように、損失が小さくなる方向に重みを調整する。学 習率は、一度にどれだけ重みを調整するかを決めるパラメータ。 実際の応用例 オプティマイザーはニューラルネットワークをトレーニングする際に欠かせない要 素。特に深層学習(Deep Learning)では、複雑なモデルが多くのデータを学習する ために様々なオプティマイザーが開発されている。 Kerasでは、いくつかのオプティマイザーが用意されており、簡単に使うことができ る。以下に、Kerasでのオプティマイザーの使用例を示す。 from keras.models import Sequential from keras.layers import Dense from keras.optimizers import Adam # モデルの定義 model = Sequential() model.add(Dense(units=64, activation='relu', input_dim=100)) model.add(Dense(units=10, activation='softmax')) # オプティマイザーをAdamに設定 optimizer = Adam(learning_rate=0.001) # モデルのコンパイル model.compile(optimizer=optimizer, loss='categorical_crossentropy', metrics=['accuracy'] # モデルのトレーニング # X_trainはトレーニングデータ、y_trainはラベル model.fit(X_train, y_train, epochs=10, batch_size=32)

この例では、Kerasを用いてニューラルネットワークを構築し、Adamオプティマイザ ーでモデルをトレーニングしている。Adamは勾配降下法の一種で、モーメンタムと アダプティブラーニングレートを組み合わせた手法。 Loss Function 定義や意味 損失関数 (Loss Function) は、機械学習モデルの予測値と実際の目標値との間の誤差 を定量的に評価するための関数 目的は、モデルが学習を通じてこの誤差を最小化すること 一般的な損失関数には、回帰問題で使用される平均二乗誤差 (Mean Squared Error) や、分類問題で使用されるクロスエントロピー損失 (Cross-Entropy Loss) などがある 例えば、二乗誤差は次のように定義される: L(y, y ^) = n1 ∑i=1 (yi − y^i )2 n ここで、yi は実際の値、y ^i は予測値、n はサンプル数 嚙み砕いた説明 損失関数は、予測がどれだけ間違っているかを数値で示す指標 例えば、予測がほぼ正しい場合、損失値は小さくなり、予測が大きく外れた場合、損 失値は大きくなる ゲームで例えると、ゲームのプレイヤーの行動が目標からどれだけ外れているかを測 るための「誤差計測器」に相当 実際の応用例 損失関数は、ニューラルネットワークのトレーニングにおいて、モデルのパラメータ を更新するための勾配を計算する際に使用される Kerasでは、損失関数を指定してモデルをコンパイルすることができる 例えば、Kerasでの使用例は次の通り:

from keras.models import Sequential from keras.layers import Dense from keras.optimizers import Adam # モデルの構築 model = Sequential() model.add(Dense(units=64, activation='relu', input_dim=100)) model.add(Dense(units=10, activation='softmax')) # モデルのコンパイル # 損失関数としてクロスエントロピーを使用 model.compile(optimizer=Adam(), loss='categorical_crossentropy', metrics=['accuracy']) # データでのトレーニング(例としてダミーデータを使用) # X_train, Y_train は訓練データとラベル # model.fit(X_train, Y_train, epochs=10, batch_size=32) 上記の例では、 categorical_crossentropy 損失関数が使用されており、これは多クラ ス分類問題に適している Metric 定義や意味 Metric(メトリック)は、モデルの性能を評価するために使用される指標のこと。機 械学習やディープラーニングにおいて、予測モデルがどれだけ正確にデータを分類ま たは回帰できるかを測定するために使用される。 数学的には、メトリックは関数として定義され、入力データと予測値に基づいてスカ ラー値を返す。例えば、分類問題では精度(accuracy)、適合率(precision)、再現 率(recall)、F1スコアなどがある。 一般的な分類問題における精度の計算式は以下の通り: Accuracy = Number of Correct Predictions Total Number of Predictions 回帰問題では平均二乗誤差(MSE: Mean Squared Error)などが用いられる: n 1 MSE = ∑(yi − y^i )2 n i=1

ここで、n はサンプル数、yi は実際の値、y ^i は予測値を表す。 嚙み砕いた説明 Metricは、機械学習モデルがうまく働いているかどうかを判断するためのものさし。 例えば、モデルがどれだけ正確に猫と犬を分類できるかを測る「精度」や、予測した 結果に対する「誤差」を測るものがある。 精度は、全体の予測の中でどれだけ正しく予測できたかを示す割合。 平均二乗誤差は、予測値と実際の値の差を二乗して平均を取ったもので、小さいほど 予測が正確。 実際の応用例 機械学習やディープラーニングのモデル訓練において、モデルの性能を評価するため に使用される。 Kerasでは、モデルコンパイル時にメトリックを指定することができ、訓練中に自動 的に計算される。 以下はKerasを用いた例で、モデルのコンパイル時に精度(accuracy)をメトリックとして指 定する方法: from keras.models import Sequential from keras.layers import Dense # モデルの構築 model = Sequential() model.add(Dense(units=64, activation='relu', input_dim=100)) model.add(Dense(units=10, activation='softmax')) # モデルのコンパイル # 損失関数に'categorical_crossentropy'を使用し、メトリックとして'accuracy'を指定 model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # モデルの訓練 # 'x_train'と'y_train'は訓練データとそのラベル model.fit(x_train, y_train, epochs=10, batch_size=32) 上記コードスニペットでは、KerasのSequentialモデルを使用してニューラルネットワ ークを構築し、コンパイル時に metrics=['accuracy'] を指定して精度を計算するよう にしている。これにより、訓練中に各エポックでのモデルの精度が出力される。

コンパイル (Compile) 定義や意味 コンパイルとは、高水準プログラミング言語で書かれたソースコードを、コンピュー タが直接実行可能な低水準の機械語に変換するプロセスを指す。このプロセスはコン パイラと呼ばれるソフトウェアによって実行される。コンパイルの結果生成される機 械語のファイルは、しばしばバイナリファイルや実行可能ファイルと呼ばれる。 一般的なコンパイルの流れは、ソースコードの字句解析、構文解析、中間コード生 成、最適化、そしてコード生成といった段階に分かれる。 嚙み砕いた説明 コンパイルは、プログラマーが書いたコードをコンピュータが理解できる形にするた めの手続き。たとえば、C++やJavaなどのプログラムは人間が読める形式で書かれて いるが、コンピュータは0と1で構成される機械語しか理解できない。そのため、コン パイルを通じてプログラムを変換して実行可能にする必要がある。 コンパイルを行うとき、プログラム全体を一度に変換するため、実行する際には高速 に動作するという利点がある。 実際の応用例 Kerasにおけるモデルのコンパイルプロセスは、ニューラルネットワークモデルがト レーニング可能な状態になるための準備を行う。具体的には、損失関数、オプティマ イザ、および評価指標を設定する。 以下はKerasにおけるモデルのコンパイル例である。

from keras.models import Sequential from keras.layers import Dense from keras.optimizers import Adam # モデルの定義 model = Sequential() model.add(Dense(units=64, activation='relu', input_shape=(10,))) model.add(Dense(units=1, activation='sigmoid')) # モデルのコンパイル # 二値分類のための損失関数はbinary_crossentropy # Adamオプティマイザを使用 # 評価指標としてaccuracyを設定 model.compile(optimizer=Adam(learning_rate=0.001), loss='binary_crossentropy', metrics=['accuracy']) # モデルの概要を表示 model.summary() このコードスニペットでは、Kerasを用いて簡単な二層のニューラルネットワークを 定義し、コンパイルしている。 model.compile() メソッドにより、学習率設定済みの Adamオプティマイザ、損失関数としての binary_crossentropy 、および評価基準とし ての accuracy がモデルに適用される。 fit 定義や意味 fit は、機械学習や深層学習のモデルをデータに適合させるためのプロセスを指す。 具体的には、与えられたトレーニングデータに基づいてモデルのパラメータを最適化 する手順 数式で表すと、モデル f (x; θ) のパラメータ θ を、入力データ X と対応するラベル Y に基づいて最適化することを意味する 最適化は通常、損失関数 L(f (x; θ), y) を最小化することによって行われる n θ = arg min ∑ L(f (xi ; θ), yi ) ∗ θ i=1 ここで、n はデータのサンプル数、xi は入力データ、yi は対応するラベル

嚙み砕いた説明 fit は、モデルを「訓練」する作業と考えることができる。データを使ってモデルに 学習させ、そのデータに対してどれだけうまく予測できるかを確認する 具体的には、例えば画像認識のモデルを考えると、たくさんの犬や猫の画像を見せて モデルに犬と猫の違いを学ばせる作業が fit にあたる 実際の応用例 fit は深層学習フレームワークであるKerasにおいて、モデルをトレーニングするた めに使われるメソッド 以下はKerasを用いた具体例 from keras.models import Sequential from keras.layers import Dense from keras.optimizers import Adam import numpy as np # モデルの定義 model = Sequential([ Dense(64, activation='relu', input_shape=(10,)), Dense(1, activation='sigmoid') ]) # モデルのコンパイル model.compile(optimizer=Adam(), loss='binary_crossentropy', metrics=['accuracy']) # ダミーデータの生成 X_train = np.random.rand(100, 10) y_train = np.random.randint(2, size=100) # モデルのトレーニング model.fit(X_train, y_train, epochs=10, batch_size=32) # コメント: 上記のコードは、10次元の入力データを持つ単純な二層のニューラルネットワークを使用して # ダミーデータでトレーニングを行う例である このコードでは、 model.fit() メソッドを使用して、生成したダミーデータを使って モデルを訓練している epochs はデータセット全体を何回繰り返して学習するかを指定し、 batch_size は一 度に処理するサンプル数を指定する

Evaluate 定義や意味 「評価(Evaluate)」は、機械学習や深層学習のモデルがどれほど効果的に学習した かを測定するプロセス モデルのパフォーマンスを評価するために、通常は訓練データとは異なる検証データ やテストデータを使用 Kerasでは、 model.evaluate() メソッドを使用して、モデルの評価を行う 評価結果として、損失値と他の評価指標(例えば、精度など)が返される 嚙み砕いた説明 モデルがデータをどれだけ「うまく」予測できるかをチェックするための手順 例えば、猫と犬の画像を区別するモデルを作成した場合、評価を行うことでモデルが 新しい画像に対してどれだけ正確に猫や犬を認識できるかを知る 評価は、訓練に使用しなかったデータセットを使って行うため、過学習(オーバーフ ィッティング)を防ぐ役割もある 実際の応用例 機械学習モデルの精度を確認するために、訓練済みモデルに対してテストデータセッ トを用いて評価を行う 以下はKerasを用いたモデルの評価の具体例

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

# サンプルデータの準備

(x_train, y_train), (x_test, y_test) = keras.datasets.mnist.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0

# シンプルなニューラルネットワークのモデルを構築

model = keras.Sequential([

layers.Flatten(input_shape=(28, 28)),

layers.Dense(512, activation='relu'),

layers.Dropout(0.2),

layers.Dense(10, activation='softmax')

])

# モデルのコンパイル

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# モデルの訓練

model.fit(x_train, y_train, epochs=5)

# モデルの評価

loss, accuracy = model.evaluate(x_test, y_test, verbose=2)

# 結果の出力

print(f"Test loss: {loss}")

print(f"Test accuracy: {accuracy}")

このコードスニペットでは、Kerasの model.evaluate() を用いてテストデータセット

に対するモデルの損失と精度を評価

評価結果は、モデルが新しいデータをどれだけ正確に予測できるかを示す指標

提示された概念名: Predict 定義や意味 Predictとは、機械学習や深層学習において訓練済みのモデルを用いて新たなデータの ラベルや値を推定するプロセスのこと モデルは訓練データから学習したパターンを基に、新たな入力データに対して予測を 行う 具体的には、入力ベクトル x に対してモデル f を用いて出力 y を予測することを意 味する。これは y = f (x) と表される 嚙み砕いた説明 Predictは、すでに学習を終えたAIモデルに「このデータを見て、何が起こるか教え て」とお願いするようなもの 例えば、画像を入力すると、それが猫なのか犬なのかを教えてくれることを予測とい う モデルは過去に見た情報(訓練データ)に基づいて、目の前の新しい情報を推測する 実際の応用例 予測は、画像分類、音声認識、自然言語処理、ゲームAIなど、様々な分野で応用され る Kerasを用いたモデルの予測例

from keras.models import load_model import numpy as np # 訓練済みモデルをロード model = load_model('my_model.h5') # 新しいデータを用意(例: 画像データ) new_data = np.array([[0.1, 0.2, 0.3, 0.4]]) # モデルによる予測を実行 predictions = model.predict(new_data) # 予測結果を出力 print(predictions) # 予測結果は、新しいデータに対するモデルの出力 このコードスニペットでは、Kerasを使用して訓練済みのモデルをロードし、新しい データに対して予測を行っている model.predict(new_data) により、新しいデータに対するモデルの出力(予測結果) を取得することができる Dense 定義や意味 Denseは、ニューラルネットワークにおける全結合層(Fully Connected Layer)を指 す。入力ノードと出力ノードがすべて接続されている層 Dense層は、以下の数式で表現される線形変換を行う。ここで、xは入力ベクトル、 W は重み行列、bはバイアスベクトル、f は非線形活性化関数 y = f (W x + b) 上記の式では、y は出力ベクトル 嚙み砕いた説明 Dense層は、ニューラルネットワークの中で各入力がすべての出力に対して影響を与 えるように設計されている層 例えば、画像認識のタスクでは、画像の各ピクセル情報が最終的な分類結果の各クラ スに影響を与えるためにDense層が用いられる

入力データが多次元であっても、Dense層を通じて一元化(フラット化)し、次の層 に渡すことができる 実際の応用例 Dense層は、分類問題や回帰問題の最終出力層としてよく使われる 特に、ニューラルネットワークの最終層として、分類タスクではソフトマックス関数 と共に使われ、回帰タスクでは線形活性化関数と共に使われる 以下に、Kerasを用いたDense層の使用例を示す: from keras.models import Sequential from keras.layers import Dense # モデルの作成 model = Sequential() # 入力層と隠れ層の追加 # 入力次元が784(例:28x28ピクセルの画像がフラット化されたもの) # 出力次元が64の全結合層 model.add(Dense(units=64, activation='relu', input_dim=784)) # 出力層の追加 # 出力次元が10(例:10クラス分類) model.add(Dense(units=10, activation='softmax')) 上記のコードでは、Kerasの Sequential モデルに対し、2つのDense層を追加している 最初の層は入力次元が784で出力次元が64、ReLU活性化関数を使用 次の層は出力次元が10で、Softmax活性化関数を使用しているため、分類問題に適応 Conv2D 定義や意味 Conv2D(2次元畳み込み)は、画像データの特徴を抽出するための基本的な操作であ り、特にディープラーニングにおける畳み込みニューラルネットワーク(CNN)で用 いられる この操作は、フィルタ(またはカーネル)と呼ばれる小さな行列を入力画像に対して スライドさせ、フィルタと入力の局所的な部分の内積を計算することで出力(特徴マ

ップ)を生成 数式で表すと、入力画像をI 、フィルタをK としたとき、出力O は以下のように表現 される O(i, j) = ∑ ∑ I (i + m, j + n) ⋅ K(m, n) m n ここで、iとj は出力の位置インデックス、mとnはフィルタ内の位置インデックスを 示す 嚙み砕いた説明 Conv2Dは、画像の中から特定のパターンや特徴を見つけ出すための手法 フィルタを画像に対して少しずつ移動させながら、画像の各部分とフィルタの重みを 掛け合わせて合計を算出する 例えるなら、画像を一枚の大きなシートとし、フィルタを小さな窓と考える。窓を動 かすことでシート全体をスキャンし、各位置での情報を集める 実際の応用例 Conv2Dは画像認識や分類、物体検出、セグメンテーションなどに広く利用される Kerasを用いると、Conv2Dレイヤーを簡単に構築可能 from keras.models import Sequential from keras.layers import Conv2D # モデルの初期化 model = Sequential() # Conv2Dレイヤーの追加 # フィルタ数: 32, フィルタサイズ: 3x3, 活性化関数: ReLU, 入力形状: 28x28の1チャンネル画像 model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1))) # モデルのサマリー表示 model.summary() 上記のコードでは、28x28ピクセルのグレースケール画像(チャネル数1)に対して、 32個の3x3フィルタを用いたConv2Dレイヤーを追加している ReLU(Rectified Linear Unit)は活性化関数で、非線形性を導入するために使用され る

Pooling 定義や意味 Pooling(プーリング)は、主に畳み込みニューラルネットワーク(Convolutional Neural Network, CNN)において使用される手法で、入力データの空間サイズを縮小 するために用いられる。これにより、計算量の削減や過学習の防止が可能となる。 Poolingにはいくつかの種類があり、一般的なのはMax PoolingとAverage Poolingで ある。Max Poolingはプール領域内の最大値を採用し、Average Poolingは平均値を採 用する。 Pooling操作により、特徴マップのサイズが縮小される。例えば、サイズがN × N の 入力に対して、プールサイズがk × k でストライドがsの場合、出力のサイズは次の ように計算される: ( N −k N −k + 1) × ( + 1) s s 嚙み砕いた説明 プーリングは画像データのような大きな入力データを扱う際に、データの重要な特徴 を保持しつつ、データサイズを小さくする技法。たとえば、画像を小さくしても、重 要な部分が残るようにすること。 Max Poolingの場合、指定された領域の中で最も明るい(最大の)ピクセルを選び、 それのみを次の層に渡す。Average Poolingの場合、領域の中のピクセルの平均値を計 算して渡す。 これにより、データの変化に対するロバスト性が増し、モデルの計算効率が上がる。 実際の応用例 CNNにおいて、特徴抽出層の出力を縮小する際に使用される。これにより、次の層で の計算負荷が軽減される。 Kerasでは MaxPooling2D や AveragePooling2D を用いて簡単に実装可能。 以下はKerasを用いてMax Poolingを実装する例:

from keras.models import Sequential from keras.layers import Conv2D, MaxPooling2D # モデルの初期化 model = Sequential() # 畳み込み層の追加 model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3))) # Max Pooling層の追加 model.add(MaxPooling2D(pool_size=(2, 2))) # モデルのサマリーを表示 model.summary() このコードは、Kerasを用いて64x64ピクセルのRGB画像を入力とするCNNモデルを定義す る。ここで、畳み込み層が特徴を抽出し、その後のMax Pooling層が特徴マップを縮小する。 Dropout 定義や意味 Dropoutとは、ニューラルネットワークにおける過学習(overfitting)を防ぐための正 則化手法の一つ 学習時にランダムに一部のノード(ニューロン)を無効化することで、モデルが特定 のノードに過度に依存するのを防ぐ 各エポックで無効化されるノードは異なるため、異なるサブネットワークが訓練され ることになる Dropout率pを設定し、各ノードは1 − pの確率で保持され、pの確率で無効化される 嚙み砕いた説明 Dropoutは、モデルが学習する際にランダムにいくつかのノードを使わないようにす るテクニック これにより、モデルが特定のデータに対して過剰に適応するのを防ぎ、より一般化さ れた性能を得ることができる 例えば、50%のDropoutを設定すると、学習中にランダムに半分のノードが無効化さ れる

実際の応用例 Dropoutは特にディープラーニングモデル、特に畳み込みニューラルネットワーク (CNN)やリカレントニューラルネットワーク(RNN)で広く用いられる KerasにおけるDropout層の使用例を以下に示す from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense, Dropout # モデルを作成 model = Sequential() # 入力層と隠れ層 model.add(Dense(64, activation='relu', input_shape=(input_dim,))) # Dropout層を追加(Dropout率は0.5) model.add(Dropout(0.5)) # 出力層 model.add(Dense(output_dim, activation='softmax')) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # コメント:Dropout層は過学習を防ぎ、モデルの汎化能力を向上させる 上記のコードスニペットでは、Kerasを用いてニューラルネットワークモデルを構築 し、Dropout層を追加している Dropout層は、訓練時にノードの50%をランダムに無効化することで過学習を防ぐ役 割を果たす Batch Normalization 定義や意味 バッチ正規化(Batch Normalization)は、深層学習モデルにおいて、各ミニバッチの 入力データの分布を調整し、学習を安定化させる手法 ミニバッチごとに、入力データの平均と分散を計算し、データを正規化する 入力データ x のバッチ正規化は以下のように行われる

i. ミニバッチの平均 μB を計算する: m 1 μB = ∑ xi m i=1 2 ii. ミニバッチの分散 σB を計算する: m 1 ∑(xi − μB )2 m σB2 = i=1 iii. 正規化された入力 x ^i を計算する: x ^i = xi − μ B σB2 + ϵ ここで、ϵ は数値安定性のための小さな定数 iv. 出力 yi をスケールとシフトする: yi = γ x ^i + β ここで、γ はスケールパラメータ、β はシフトパラメータ 嚙み砕いた説明 バッチ正規化は、ニューラルネットワークの各層において、入力データが適切な範囲 に収まるように調整する技術 これにより、学習がより速く、安定して行われるようになる 各ミニバッチで計算される平均と分散を用いてデータを標準化し、その後にスケール とシフトを施すことで、モデルが学習可能な最適な範囲にデータを調整する 学習の際の勾配消失問題を緩和し、より深いネットワークを効率的に訓練することが できる 実際の応用例 バッチ正規化は、畳み込みニューラルネットワーク(CNN)やリカレントニューラル ネットワーク(RNN)など、様々な深層学習モデルで広く使われる モデルの収束を早くするために使用され、より小さな学習率での学習を可能にする 以下にKerasを用いたバッチ正規化の実装例を示す:

from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense, BatchNormalization # モデルの定義 model = Sequential() # 入力層とバッチ正規化層 model.add(Dense(64, input_shape=(32,), activation='relu')) model.add(BatchNormalization()) # 隠れ層とバッチ正規化層 model.add(Dense(64, activation='relu')) model.add(BatchNormalization()) # 出力層 model.add(Dense(10, activation='softmax')) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # モデルのサマリーを表示 model.summary() このコードスニペットでは、入力層と隠れ層の後にバッチ正規化層を追加すること で、学習の安定性を向上させている Kerasの BatchNormalization レイヤーを用いることで簡単にバッチ正規化を実装可能 Simple Network 定義や意味 Simple Networkは、通常1つまたは少数の隠れ層を持つ基本的なニューラルネットワ ークのことを指す このネットワークは入力層、1つまたは複数の隠れ層、そして出力層で構成される 各層の出力は次の層への入力として利用される ネットワークの重みとバイアスは学習アルゴリズム(通常は勾配降下法など)を通じ て最適化される 数式的には、各層の出力は以下のように表される:

a(l) = f (W (l) a(l−1) + b(l) ) ここで、a(l) は層lの出力、W (l) は層lの重み行列、b(l) は層lのバイアスベクトル、f は活性化 関数を示す。 嚙み砕いた説明 Simple Networkは、データが層を通じて処理され、最終的に出力が生成される一連の 操作 例えば、入力が画像データであれば、各層は画像の特徴を抽出し、最終的な層で何ら かの分類を行う 直感的には、各層はデータをより高次の抽象的な特徴に変換していると考えることが できる 実際の応用例 Simple Networkは主に分類問題や回帰問題で利用される 例えば、手書き数字の認識、二値分類タスクなどで使用される Kerasを用いたシンプルなネットワークの実装例を次に示す from keras.models import Sequential from keras.layers import Dense # モデルの初期化 model = Sequential() # 入力層と1つ目の隠れ層を追加 model.add(Dense(units=64, activation='relu', input_shape=(input_dim,))) # 出力層を追加 model.add(Dense(units=num_classes, activation='softmax')) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # モデルのサマリーを表示 model.summary() このコードスニペットでは、Kerasの Sequential モデルを使用してシンプルな全結合ネット ワークを構築している。最初の隠れ層には64個のユニットがあり、ReLU活性化関数を使用

している。出力層はクラス数に応じたユニットを持ち、ソフトマックス活性化関数を適用し ている。 Complex Network 定義や意味 複雑ネットワーク(Complex Network)は、社会、通信、交通、インターネットな ど、現実世界の多くのシステムをモデル化するための数学的構造 ノード(頂点)とエッジ(辺)からなるグラフとして表現され、ノードは実体を、エ ッジはノード間の関係を示す 複雑ネットワークは、ランダムネットワークやスケールフリーネットワーク、スモー ルワールドネットワークなどの特性を持つ スケールフリーネットワークでは、ノードの次数分布がべき乗則に従う。次数分布 P (k) は、次数 k を持つノードの確率を示す P (k) ∼ k −γ ここで、γ はべき乗則の指数 嚙み砕いた説明 複雑ネットワークは、インターネットの接続構造や人間関係のネットワークのよう に、多くのノードとそれをつなぐエッジで構成される 「スケールフリー」とは、一部のノードが非常に多くの接続を持ち(ハブ)、多くの ノードは少数の接続しか持たない特性 「スモールワールド」とは、全てのノードが少数の中間ノードを介して繋がっている 特性 実際の応用例 ソーシャルネットワークの分析、ウイルスの感染経路の特定、交通システムの最適化 などに応用 ゲーム制作においても、例えばMMORPGのプレイヤー間のインタラクションや、ゲ ーム内の経済システムのモデル化に利用されることがある 以下は、PythonとKerasを使った単純なニューラルネットワークの例を示す。複雑ネットワ ークの分析において、学習データの生成や特徴抽出に利用できる。

import numpy as np from keras.models import Sequential from keras.layers import Dense # サンプルデータ生成 X = np.random.rand(1000, 10) # 入力データ: 1000サンプル、10特徴 y = np.random.randint(2, size=(1000, 1)) # 出力データ: 0または1のバイナリ分類 # モデルの構築 model = Sequential() model.add(Dense(64, input_dim=10, activation='relu')) model.add(Dense(1, activation='sigmoid')) # 入力層と隠れ層 # 出力層 # モデルのコンパイル model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy']) # モデルの訓練 model.fit(X, y, epochs=10, batch_size=32) # モデルの評価 loss, accuracy = model.evaluate(X, y) print(f'Loss: {loss}, Accuracy: {accuracy}') このコードは、Kerasライブラリを用いてニューラルネットワークを構築し、ランダ ムなデータに対してバイナリ分類を行う 複雑ネットワークの研究において、ネットワークの特徴を入力データとし、特定のパ ターンを予測するモデルの開発に役立つ可能性がある Multiple Inputs/Outputs 定義や意味 Multiple Inputs/Outputs(多入力/多出力)とは、機械学習や深層学習モデルにおい て、複数の入力データを受け取り、複数の出力を生成するアーキテクチャを指す 多入力・多出力のモデルは、複雑なデータ処理や、関連する複数のタスクを同時に解 決する必要がある場合に特に有用 数式的には、入力ベクトルをx1 , x2 , … , xn とし、出力ベクトルをy1 , y2 , … , ym と する 多入力・多出力モデルは次のように表現されることが多い:

y1 , y2 , … , ym = f (x1 , x2 , … , xn ) 嚙み砕いた説明 多入力とは、モデルが複数の異なる種類のデータ(例えば、画像とテキスト)を同時 に受け取ることを指す 多出力とは、モデルが複数の異なるタスク(例えば、画像の分類と物体検出)を同時 に行うことを指す 例えば、猫と犬の画像を入力として、それぞれの動物の種類のラベルと、画像内の動 物の位置を同時に出力することが可能 このような場合、2つの入力(猫の画像、犬の画像)があり、2つの出力(ラベル、位 置情報)がある 実際の応用例 実際の多入力・多出力モデルの応用例として、Kerasを用いた実装を示す KerasはPythonで書かれた高水準のニューラルネットワークAPIであり、多入力・多出 力モデルの構築を容易にする 以下のコードスニペットは、Kerasを用いた多入力・多出力モデルの例を示す

from keras.models import Model from keras.layers import Input, Dense, concatenate # 入力層の定義 inputA = Input(shape=(64,)) inputB = Input(shape=(128,)) # 各入力に対するネットワークの定義 x = Dense(32, activation='relu')(inputA) x = Dense(16, activation='relu')(x) y = Dense(64, activation='relu')(inputB) y = Dense(32, activation='relu')(y) # 2つのネットワークを結合 combined = concatenate([x, y]) # 出力層の定義 z = Dense(2, activation='softmax')(combined) # モデルの定義 model = Model(inputs=[inputA, inputB], outputs=z) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # モデルのサマリーを表示 model.summary() このモデルは2つの異なる入力形式(64次元と128次元)を取り、それを中間の結合層 で統合し、最終的に2クラス分類を行う出力を生成する このようにして、複数の異なるデータソースからの情報を統合し、一つの統一モデル で出力を得ることが可能になる EarlyStopping 定義や意味 EarlyStoppingは機械学習のモデル訓練において、過学習(オーバーフィッティング) を防ぐための手法の一つ。モデルの精度が向上しなくなった時点で訓練を停止するこ とで、訓練データに過度に適合するのを防ぐ。

通常、訓練セットと検証セットでモデルを評価し、検証セットの損失が一定のエポッ ク数(通常は "patience" と呼ばれる)を超えて減少しなければ訓練を停止する。 数式で表すと、Lval (t) が検証セットの損失であるとき、Lval (t) ≤ Lval (t + p) を満 たす最大の t が見つかったら訓練を停止する。ただし、p はpatience(忍耐)に対応 するエポック数。 嚙み砕いた説明 EarlyStoppingは、モデルが訓練セットに対して良いパフォーマンスを示しても新しい データに対しては悪いパフォーマンスを示すことを防ぐための手段。言い換えれば、 モデルが訓練データに過度に適合(オーバーフィット)しないようにする。 例えば、テストの点数が毎回良くなっているのに急に変わらなくなったら、それ以上 勉強しても無駄なので、そのタイミングで勉強をやめるという考え方に似ている。 実際の応用例 EarlyStoppingは深層学習モデルの訓練時によく利用される。特に、ニューラルネット ワークを訓練する際に、検証セットのパフォーマンスが改善しなくなった時点で訓練 を終了することで、計算時間を節約し、モデルの汎化能力を向上させる。 Kerasを用いたEarlyStoppingの具体例:

from keras.models import Sequential from keras.layers import Dense from keras.callbacks import EarlyStopping # 単純なSequentialモデルの構築 model = Sequential() model.add(Dense(units=64, activation='relu', input_dim=100)) model.add(Dense(units=10, activation='softmax')) # モデルのコンパイル model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy']) # EarlyStoppingコールバックの設定 early_stopping = EarlyStopping(monitor='val_loss', patience=3) # モデルの訓練 model.fit(x_train, y_train, epochs=100, batch_size=32, validation_data=(x_val, y_val), callbacks=[early_stopping]) 上記のコードでは、 EarlyStopping コールバックが指定されているので、検証データ の損失が3エポック以上改善しない場合、訓練が停止される。これにより、過学習を 防ぎ、計算リソースを節約することができる。 ModelCheckpoint 定義や意味 ModelCheckpoint は、主に深層学習モデルのトレーニング中に最適なモデルを保存す るためのコールバックである。これにより、モデルのトレーニングが進行中でも途中 経過を保存し、後でその状態からトレーニングを再開することができる。 Kerasにおける ModelCheckpoint は、指定したメトリクス(例えば、検証セットに対す る損失や精度)が改善した場合にモデルを指定したファイルパスに保存する機能を持 つ。

嚙み砕いた説明 ModelCheckpoint は、トレーニング中に最も良いモデルを保存するためのツール。例 えば、20エポックのトレーニングを行う場合、各エポックの最後に検証損失をチェッ クし、もしその損失が今までの最小値であれば、その時点のモデルを保存する。これ により、トレーニングが終わった後でも最も良いモデルをすぐに利用可能になる。 例えば、トレーニング中にコンピュータがクラッシュしても、保存された最適なモデ ルから再開することが可能になる。 実際の応用例 ModelCheckpoint は、特にディープラーニングのトレーニングで長時間かかる場合 や、トレーニング中に最適なモデルを確保しておきたい場合に使用される。 以下のKerasを用いた具体例では、検証セットに対する最小の損失の時点でモデルを 保存する。 from keras.models import Sequential from keras.layers import Dense from keras.callbacks import ModelCheckpoint # モデルの構築 model = Sequential() model.add(Dense(64, activation='relu', input_dim=100)) model.add(Dense(1, activation='sigmoid')) model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy']) # ModelCheckpointの設定 checkpoint = ModelCheckpoint(filepath='best_model.h5', monitor='val_loss', verbose=1, save_best_only=True, mode='min') # モデルのトレーニング model.fit(x_train, y_train, epochs=20, batch_size=128, validation_data=(x_val, y_val), callbacks=[checkpoint])

上記のスクリプトでは、 ModelCheckpoint は val_loss (検証データに対する損失)が 減少した場合にのみモデルを保存する。このようにして、最適なモデルが自動的にフ ァイルとして保存される。 SGD (Stochastic Gradient Descent) 定義や意味 Stochastic Gradient Descent(SGD)は、機械学習および深層学習における最適化ア ルゴリズムの一つ。目的は、損失関数(誤差関数)の最小化を通してモデルのパラメ ータを最適化すること。 SGDは、各イテレーションでトレーニングデータセットからランダムなサンプル(バ ッチ)を使用して勾配を計算し、その勾配に基づいてパラメータを更新する。この方 法は、計算効率が高く、特に大規模なデータセットに対して有用である。 数式として、重み w の更新規則は以下のように表される: w = w − η ⋅ ∇L(w) ここで、η は学習率、∇L(w) は損失関数 L の勾配である。 嚙み砕いた説明 SGDは、データセット全体を使うのではなく、小さな部分(バッチ)を使ってモデル の重みを更新する手法。これにより、計算が速くなるとともに、メモリの使用量も抑 えられる。 大規模なデータセットでは、全データを使って勾配を計算するのは非現実的。SGD は、ランダムに選ばれた小さなデータセットで勾配を近似することで、効率よく最適 解に近づく。 例えば、1000万枚の画像データセットであっても、SGDはその一部だけを使ってモ デルを改善し続けることができる。 実際の応用例 SGDは、Kerasなどの深層学習ライブラリで一般的に使用されている最適化アルゴリ ズムで、分類や回帰問題、画像認識など幅広いタスクに対応。 KerasでのSGDの実装例は以下のとおり:

from keras.models import Sequential from keras.layers import Dense from keras.optimizers import SGD # モデルの定義 model = Sequential() model.add(Dense(units=64, activation='relu', input_dim=100)) model.add(Dense(units=10, activation='softmax')) # SGDオプティマイザの設定 sgd = SGD(learning_rate=0.01, momentum=0.9) # モデルのコンパイル model.compile(loss='categorical_crossentropy', optimizer=sgd, metrics=['accuracy']) # トレーニングデータでの学習 model.fit(x_train, y_train, epochs=10, batch_size=32) 上記のコードスニペットでは、SGDを用いてモデルをトレーニングしてい る。 learning_rate は学習率、 momentum はモーメンタムを示す。モーメンタムは、 過去の勾配を利用して更新の方向を調整し、より滑らかな収束を目指すものである。 Adam 定義や意味 Adamは、Adaptive Moment Estimation(適応モーメント推定)の略で、深層学習にお ける最適化アルゴリズムの一つ 勾配ベースの最適化アルゴリズムで、過去の勾配の指数移動平均を利用してパラメー タを適応的に更新 勾配の一階モーメント(平均)と二階モーメント(分散)を同時に計算し、それに基 づいて学習率を調整 パラメータの更新式は以下のように表される

mt = β1 mt−1 + (1 − β1 )∇L(θt ) vt = β2 vt−1 + (1 − β2 )(∇L(θt ))2 mt m ^t = 1 − β1t vt v^t = 1 − β2t η θt+1 = θt − m ^t v^t + ϵ ここで、θt はパラメータ、∇L(θt )は損失関数の勾配、mt は勾配の一階モーメントの 推定値、vt は勾配の二階モーメントの推定値、β1 とβ2 はそれぞれのモーメントの減衰 率、η は学習率、ϵはゼロ除算を防ぐための小さな定数 嚙み砕いた説明 Adamは、勾配降下法を改良した効率的なアルゴリズムで、パラメータの更新に過去 の勾配の情報を利用する 勾配の平均と分散を使うことで、異なるパラメータごとに異なる学習率を割り当て、 より速く、より安定した収束を実現 特に大規模なデータセットや不均一なデータセットで有効 具体的には、過去の勾配を記憶して、その平均値や分散を計算し、これに基づいて次 のパラメータ更新を行うことで、勾配の変動に対応する 実際の応用例 Adamは、Kerasをはじめとする多くの深層学習ライブラリで標準的に用いられる最適 化アルゴリズム 機械学習モデルのトレーニング時に、損失関数を最小化するためのパラメータ更新に 使用される 以下はKerasでのAdamの使用例

import keras from keras.models import Sequential from keras.layers import Dense from keras.optimizers import Adam # モデルの構築 model = Sequential([ Dense(64, activation='relu', input_shape=(input_dim,)), Dense(64, activation='relu'), Dense(output_dim, activation='softmax') ]) # Adamオプティマイザの設定 optimizer = Adam(learning_rate=0.001) # モデルのコンパイル model.compile(optimizer=optimizer, loss='categorical_crossentropy', metrics=['accuracy'] # モデルのトレーニング model.fit(x_train, y_train, epochs=10, batch_size=32) このコードスニペットでは、Kerasを用いてニューラルネットワークモデルを構築 し、Adamオプティマイザを適用してトレーニングを行う Adam クラスのインスタンスを生成し、 learning_rate を指定してモデルに組み込むこ とで、Adamによる最適化を実現する Categorical Crossentropy 定義や意味 Categorical Crossentropyは、多クラスの分類問題において、モデルの予測と実際のラ ベルの間の不一致を測定するための損失関数。特に、出力層がソフトマックス関数を 用いているニューラルネットワークで使用されることが多い。 損失の計算は以下の数式で表される: C L(y, y^) = − ∑ yi log(y^i ) i=1

ここで、C はクラスの総数、yi は実際のラベル(one-hotエンコーディング形式)、y ^i は予測 確率分布。 嚙み砕いた説明 Categorical Crossentropyは、モデルがどれだけ正確にクラスを予測したかを評価する ための指標。モデルが正しいクラスに対して高い確率を予測するほど、損失は小さく なる。 例えば、3つのクラスがある場合、実際のラベルがクラス1であるとき、理想的なモデ ルはクラス1に対して確率1を出力し、他のクラスに対して確率0を出力する。 Categorical Crossentropyは、この理想からのずれを測る。 実際の応用例 Categorical Crossentropyは、Kerasなどのディープラーニングフレームワークで多ク ラス分類のタスクに広く使用されている。 例えば、手書き数字認識のMNISTデータセットにおけるニューラルネットワークの訓 練に利用される。 from keras.models import Sequential from keras.layers import Dense, Activation from keras.optimizers import Adam from keras.losses import CategoricalCrossentropy # モデルの定義 model = Sequential([ Dense(512, input_shape=(784,)), # 入力層 Activation('relu'), # 活性化関数 Dense(10), # 出力層 Activation('softmax') # ソフトマックス関数 ]) # モデルのコンパイル model.compile(optimizer=Adam(), loss=CategoricalCrossentropy(), metrics=['accuracy']) # モデルの訓練(例:x_train, y_trainは訓練データ) # model.fit(x_train, y_train, epochs=10, batch_size=32)

このコードスニペットでは、Kerasを用いてニューラルネットワークを構築し、Categorical Crossentropyを損失関数として設定している。訓練データを用いてモデルを訓練し、各エポ ックごとにモデルの精度を評価する。 MeanSquaredError 定義や意味 Mean Squared Error (MSE) は、統計学および機械学習における回帰分析の性能を評 価するための指標の一つ。MSEは、予測値と実際の値の差を二乗し、その平均を取る ことで計算される。 数式で表すと、次のようになる: n 1 MSE = ∑(yi − y^i )2 n i=1 ここで、n はデータの総数、yi は実際の値、y^i は予測値を示す。 嚙み砕いた説明 MSEは、予測モデルの精度を測るために使用される指標。予測が実際の値からどれだ け離れているかを示す。 基本的には、予測が実際の値に近ければ近いほど、MSEの値は小さくなる。完全に一 致すればMSEは0になる。 予測値と実際の値の差(誤差)を二乗しているため、大きな誤差がより強く影響す る。これにより、外れ値に敏感な特性を持つ。 実際の応用例 MSEは、回帰問題におけるモデルの性能評価によく使われ、特にディープラーニング のフレームワークであるKerasでの使用が普及している。 KerasでMSEを損失関数として指定する例を以下に示す。

from keras.models import Sequential from keras.layers import Dense from keras.losses import MeanSquaredError # モデルの構築 model = Sequential() # 入力層と出力層を持つシンプルなモデル model.add(Dense(units=1, input_dim=1, activation='linear')) # MSEを損失関数としてコンパイル model.compile(optimizer='adam', loss=MeanSquaredError()) # モデルのサマリーを表示 model.summary() # データの準備 import numpy as np # 例としてランダムなデータを生成 X_train = np.random.rand(100, 1) y_train = 3 * X_train + np.random.rand(100, 1) * 0.1 # モデルの訓練 model.fit(X_train, y_train, epochs=50, batch_size=10) # 訓練後、モデルを使って予測 predictions = model.predict(X_train) # 予測結果を表示 print(predictions) 上記のコードは、単純な線形回帰モデルをKerasで構築し、MSEを損失関数として使 用している。モデルはランダムに生成されたデータで訓練され、訓練後に予測を行 う。

Accuracy 定義や意味 Accuracy(精度)は、予測がどの程度正確であるかを表す指標であり、全予測のうち 正解した予測の割合を示す 数式で表すと、Accuracyは以下のように定義される Accuracy = Number of Correct Predictions Total Number of Predictions ここで、正しい予測の数は、モデルが正しく分類したデータポイントの数を指し、総 予測数はモデルが行った全ての予測の数を指す 嚙み砕いた説明 Accuracyとは、例えば100個のテスト問題に対して80個の問題に正解した場合、その 精度は80%であると示す指標 これは全体に対する正解の割合を示し、モデルやシステムの性能を評価するための基 本的な指標の一つ 一般的に、精度が高いほど、モデルが正確に予測を行っていると考えられる 実際の応用例 Accuracyは、機械学習モデルの性能を評価する際に一般的に用いられる 特に、分類問題において、モデルがどの程度正確にクラスを予測できているかを評価 するために使用される 以下に、Kerasを用いた精度の評価の例を示す

from keras.models import Sequential from keras.layers import Dense from keras.optimizers import Adam from keras.metrics import Accuracy # モデルの構築 model = Sequential([ Dense(64, activation='relu', input_shape=(input_dim,)), Dense(32, activation='relu'), Dense(num_classes, activation='softmax') ]) # モデルのコンパイル model.compile(optimizer=Adam(), loss='categorical_crossentropy', metrics=[Accuracy()]) # モデルのトレーニング model.fit(x_train, y_train, epochs=10, batch_size=32, validation_data=(x_val, y_val)) # 評価 loss, accuracy = model.evaluate(x_test, y_test) print(f'Accuracy: {accuracy:.2f}') この例では、Kerasを用いて簡単なニューラルネットワークモデルを作成し、精度メ トリクスを用いてモデルの性能を評価している モデルのコンパイル時に metrics 引数で Accuracy() を指定することで、トレーニング や評価の際に精度を表示することが可能 Precision 定義や意味 Precision(適合率)は、機械学習やデータマイニングにおけるモデルの性能を評価す る指標の一つである。特に、分類問題において、モデルがどれだけの正確さで正のク ラスを予測できたかを示す。 Precisionは次の数式で定義される: Precision = True Positives (TP) True Positives (TP) + False Positives (FP)

True Positives (TP) は、モデルが正しく正のクラスと予測したサンプルの 数 False Positives (FP) は、モデルが誤って正のクラスと予測したサンプルの 数 嚙み砕いた説明 Precisionは、モデルが「正しい」と予測したものの中で、どれだけ実際に正しかった かを測る指標。例えば、スパムメール検出モデルがメールをスパムと予測したとき、 その中で実際にスパムだったメールの割合を表す。 高いPrecisionは、モデルが誤って正のクラスと判断することが少ないことを意味す る。ただし、Precisionが高いだけでは、全体の正確性を保証するわけではなく、他の 指標(RecallやF1スコア)と併せて評価することが重要。 実際の応用例 Precisionは、特に誤警報を避けたい場合に重要な指標である。例えば、医療診断シス テムやスパムフィルターなど、偽陽性が重大な影響を及ぼすシステムにおいて重要。 以下に、Kerasを用いてモデルのPrecisionを計算する例を示す。

from keras.models import Sequential from keras.layers import Dense from keras.metrics import Precision from keras.optimizers import Adam from sklearn.model_selection import train_test_split from sklearn.datasets import make_classification # データセットを生成 X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42) # トレーニングデータとテストデータに分割 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42 # モデルの構築 model = Sequential([ Dense(32, activation='relu', input_shape=(X_train.shape[1],)), Dense(1, activation='sigmoid') ]) # モデルのコンパイル(Precisionを評価指標として追加) model.compile(optimizer=Adam(), loss='binary_crossentropy', metrics=[Precision()]) # モデルのトレーニング model.fit(X_train, y_train, epochs=10, batch_size=32, validation_split=0.2) # モデルの評価 loss, precision = model.evaluate(X_test, y_test) print(f'Precision: {precision:.4f}') このコードは、Kerasを用いて単純なニューラルネットワークモデルを構築し、Precisionを 評価指標としてモデルの性能を測定する例である。Precisionは、モデルがどれだけ正確に正 のクラスを予測できたかを示す。