NLP_spaCy

1.2K Views

November 28, 24

スライド概要

医学生。AIや業務・学習効率化に興味あり。

関連スライド

SP_Librosa

DL_PyTorch

各ページのテキスト

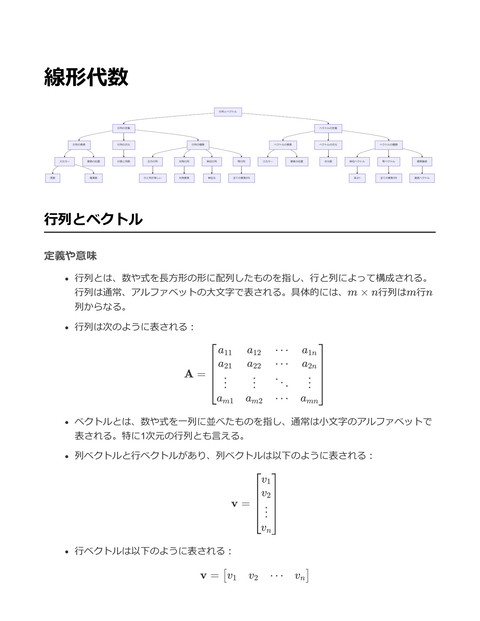

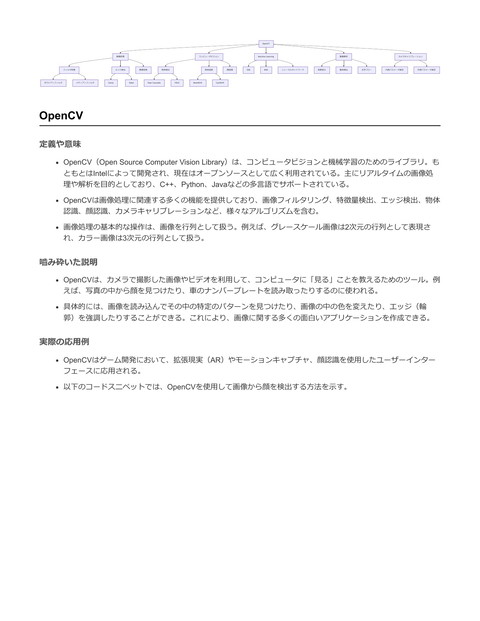

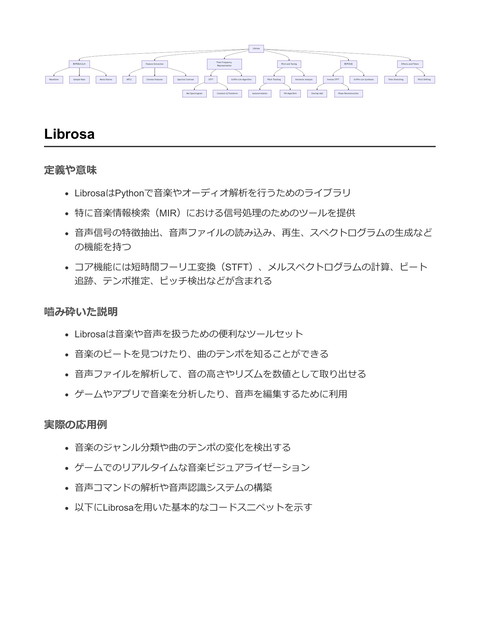

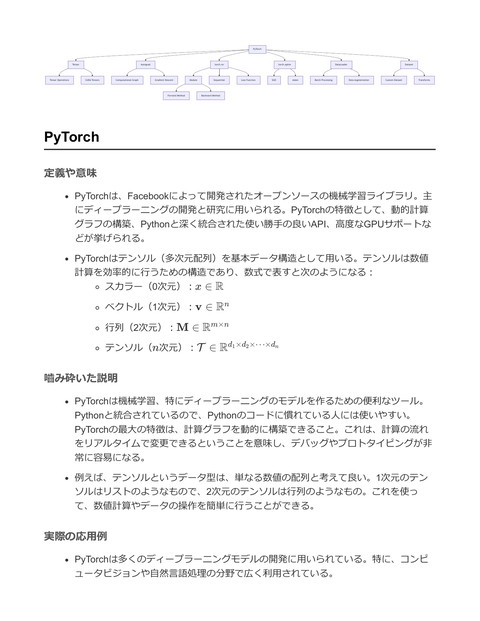

spaCy Tokenizer Vocabulary Tokenization Process Lexeme Lexicon Pipeline Word Embedding Component Tagger Parser Part-of-Speech Tagging Dependency Parsing Doc Object Processing Pipeline Entity Recognizer Phrase Matching Span Token Attributes Language Model Pre-trained Models Custom Models Named Entity Recognition Entity Types NER Training Syntactic Dependency spaCy 定義や意味 spaCyは自然言語処理(NLP)のためのPythonライブラリ。高速で、正確な情報抽 出、テキストの解析、自然言語理解のタスクに最適化されている。 spaCyは、言語モデルを使用してテキストのトークン化、品詞タグ付け、名前付きエ ンティティ認識(NER)、依存構造解析などを行う。 これらの機能を駆使して、テキストデータから有意義な情報を抽出することができ る。 嚙み砕いた説明 spaCyは、テキストを理解するためにコンピュータが使うツールの一つ。たとえば、 文を単語に分けたり、各単語が名詞や動詞などどんな役割を持っているかを判断した りする。 具体的には、"I like cats."という文を与えると、spaCyはこの文を3つの単語("I", "like", "cats")に分け、"I"が主語であること、"like"が動詞であること、"cats"が目的語 であることを理解できる。 実際の応用例 spaCyは、チャットボット、検索エンジン、情報抽出システムなど、さまざまな自然 言語処理アプリケーションで活用されている。 以下は、テキストから名前付きエンティティを抽出するためのspaCyの使用例であ る:

import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析 text = "Apple is looking at buying U.K. startup for $1 billion" doc = nlp(text) # 名前付きエンティティの抽出と表示 for ent in doc.ents: print(ent.text, ent.label_) # 出力例: # Apple ORG # U.K. GPE # $1 billion MONEY このコードでは、テキストから「Apple」が組織(ORG)として、「U.K.」が地理的 な政治単位(GPE)として、「$1 billion」が金額(MONEY)として抽出される。 spaCyはゲーム制作においても、ゲーム内キャラクターの対話生成やプレイヤーから の入力解析に応用可能。たとえば、プレイヤーが入力したテキストを理解し、その意 図に基づいてキャラクターの反応を制御することができる。 Tokenizer 定義や意味 トークナイザー(Tokenizer)は、テキストを処理可能な単位に分割するプロセスを提 供するツールやアルゴリズム。自然言語処理(NLP)においては、文章を「トーク ン」と呼ばれる単語や句に分ける役割を果たす。 トークン化の基本的な目的は、テキストの文字列を単語やサブ単語、記号、数字など の意味のある単位に分解し、機械学習モデルやその他の処理に適した形式に変換する こと。 数式で表現すると、テキスト T をトークンの集合 {t1 , t2 , … , tn } に分けるプロセス であり、各 ti はテキスト内の意味のある単位を表す。

嚙み砕いた説明 トークナイザーは、長いテキストを小さな部品に分解する機械である。たとえば、 「私は猫が好きです。」という文を「私」「は」「猫」「が」「好き」「です」とい った単位に分割する。 これにより、テキストデータを機械が理解しやすい形に変換し、分析や処理が容易に なる。 トークナイザーは単なる空白文字での分割だけではなく、句読点の処理や特殊な文字 列の分解も行う。 実際の応用例 トークナイザーは自然言語処理(NLP)における基本的なステップの一つであり、 様々なAIモデルやテキスト解析の前処理に利用される。 例えば、spaCyというPythonライブラリを使ってテキストをトークン化する方法は以 下の通りである。 import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # トークン化するテキスト text = "I love programming and creating games with Python!" # テキストを処理 doc = nlp(text) # トークンを出力 for token in doc: print(token.text) このコードは、テキストを個々の単語や記号に分解し、それぞれを出力する。結果と して、"I", "love", "programming", "and", "creating", "games", "with", "Python", "!" と表 示される。 ゲーム制作においては、キャラクターの会話やストーリーの解析、検索エンジンのキ ーワード抽出などに利用される。

Vocabulary 定義や意味 Vocabulary(ボキャブラリ)とは、自然言語処理において、テキストデータの中から 特徴量として利用するための単語の集合を指す。通常はコーパス(大量の文書デー タ)から抽出される。 ボキャブラリは、テキストデータを数値データに変換する際、単語をベクトル表現に 変換するために必要な、対応表のような役割を持つ。 数学的には、ボキャブラリは集合として表現され、V = {w1 , w2 , … , wn } と表す ことができ、ここで wi はボキャブラリ内の単語を表す。 嚙み砕いた説明 ボキャブラリとは、たくさんの文章やテキストの中から使われる単語を集めたリスト のこと。例えば、本を読むときに知らない単語があったら、その単語をメモしていく ようなもの。 このリストを使って、文章を数字として理解できるようにする。コンピューターは数 字が得意なので、単語を数字に変えるためのカギとしてボキャブラリを使う。 実際の応用例 自然言語処理でテキストデータを解析する際、ボキャブラリは単語のベクトル化に使 われる。これにより、機械学習モデルがテキストデータを処理できるようになる。 spaCyを用いてボキャブラリを構築し、テキストをベクトルに変換する例を示す。

import spacy

# spaCyの英語モデルをロード

nlp = spacy.load("en_core_web_sm")

# テキストを処理

doc = nlp("Natural language processing with spaCy is fun!")

# ボキャブラリを表示

vocab = nlp.vocab

print(f"Vocabulary size: {len(vocab)}")

# 各トークンのIDを表示

for token in doc:

print(f"Word: {token.text}, ID: {token.vocab.strings[token.text]}")

このコードでは、spaCyを用いて英語のテキストを処理し、文中の単語(トークン)

に対応するIDを表示している。

ボキャブラリのサイズは、spaCyのモデルに含まれる全ての単語の数であり、これは

テキストを数値データに変換する基盤となる。

Pipeline

定義や意味

Pipelineとは、一連の処理を順次に実行するための方法論や構造を指す。特にデータ

処理や機械学習の分野で、データの前処理、特徴量抽出、モデル学習、予測などの各

ステップを連続して実行するための枠組みを指す。

Pipelineは各ステップをモジュール化し、パラメータや処理手順を一元管理できる。

これにより、再現性やメンテナンス性を向上させる。

数式で表すと、Pipelineは一連の関数 f1 , f2 , … , fn の合成として表現され、入力デ

ータ x に対して最終出力を fn (fn−1 (… f1 (x) …)) として得る。

嚙み砕いた説明

Pipelineは、処理の流れを一つの「パイプライン」として考えることで、各処理の順

番やパラメータを簡単に管理し、効率的に実行するための仕組み。例えば、洗濯に例

えると、洗う、すすぐ、脱水、乾燥という一連の作業を一つの流れとして管理するイ

メージ。

spaCyでは、Pipelineを使ってテキストの処理を行う。例えば、トークン化、品詞タ

グ付け、依存関係解析などを順番に実行する。

実際の応用例

spaCyを用いた自然言語処理のPipelineの例を示す。ここでは、テキストを処理する

ための一連のステップを定義し、各ステップを順次に実行する。

import spacy

# spaCyのモデルをロード

nlp = spacy.load("en_core_web_sm")

# パイプラインの確認

print(nlp.pipe_names)

# ['tagger', 'parser', 'ner']

# テキストを処理

doc = nlp("This is a sentence.")

# パイプラインの各ステップの結果を確認

for token in doc:

print(f"Token: {token.text}, POS: {token.pos_}, Dependency: {token.dep_}")

# 結果:

# Token: This, POS: DET, Dependency: nsubj

# Token: is, POS: AUX, Dependency: ROOT

# Token: a, POS: DET, Dependency: det

# Token: sentence, POS: NOUN, Dependency: attr

# Token: ., POS: PUNCT, Dependency: punct

上記のコードでは、spaCyのPipelineを利用して、テキストを解析し、トークン化、

品詞タグ付け、依存解析を行う。 nlp オブジェクトがPipelineを管理し、 doc オブジ

ェクトに解析結果が格納される。

Pipelineを使うことで、処理の流れを簡潔に実行し、必要な情報を効率的に取得する

ことが可能。

Doc Object 定義や意味 Doc オブジェクトは、自然言語処理ライブラリであるspaCyにおける中心的なデータ 構造である。 Doc オブジェクトはテキストの一貫した表現を提供し、トークン化、解 析、および他の自然言語処理タスクを効率的に行うための基盤を提供する。 Doc オブジェクトは、 Token オブジェクトのシーケンスであり、それぞれのトークン は単語や句読点などの最小単位を表す。また、 Doc オブジェクトは文境界、依存構 造、品詞タグ、名前付きエンティティなどの言語情報を保持する。 例えば、テキスト "spaCy is great!" を nlp オブジェクトで処理すると、次のよう な Doc オブジェクトが生成される。 Doc : [spaCy, is, great, !] 嚙み砕いた説明 Doc オブジェクトは、テキストを扱うための強力なツールであり、テキストがどのよ うに構造化されているかを理解するための情報を多く含んでいる。例えば、各単語が どのような品詞か、文中での役割、どの単語と関連しているかといった情報が含まれ ている。 簡単に言えば、 Doc オブジェクトはテキストを「単語のリスト」としてだけでなく、 「意味を持つ単位の集まり」として扱うことを可能にする。 実際の応用例 Doc オブジェクトは、自然言語処理タスクの基盤として広く使用されている。特に、 テキスト解析、情報抽出、対話システムの構築などの場面でその真価を発揮する。 具体例として、 spaCy を用いたテキスト解析のコードスニペットを示す。

import spacy

# 'en_core_web_sm'モデルをロード

nlp = spacy.load("en_core_web_sm")

# テキストを処理してDocオブジェクトを生成

doc = nlp("spaCy is great!")

# 各トークンのテキストと品詞を表示

for token in doc:

print(f"Text: {token.text}, POS: {token.pos_}")

# 出力:

# Text: spaCy, POS: PROPN

# Text: is, POS: AUX

# Text: great, POS: ADJ

# Text: !, POS: PUNCT

このコードスニペットでは、 spaCy の小さな英語モデルを使用してテキストを解析

し、生成された Doc オブジェクト内の各トークンのテキストと品詞(POS)を表示し

ている。これは、自然言語処理によるテキスト解析の基本的な例である。

Language Model

定義や意味

Language Model(言語モデル)とは、自然言語の文脈を理解し、テキストの生成や

補完を行うための統計的モデルのこと。これらのモデルは、与えられた一連の単語の

後に続く単語の確率を予測する。

言語モデルの根幹を成すのは、確率的アプローチであり、次の単語を予測するための

確率分布 P (wk ∣w1 , w2 , ..., wk−1 ) を学習すること。

n-gramモデルは古典的な言語モデルの一つで、n個の連続した単語から次の単語を予

測する。より現代的なものとしては、ニューラルネットワークをベースとしたモデル

がある。

嚙み砕いた説明

言語モデルは、人間が言葉を使って話したり書いたりする際の「次に何を言うか」を

予測するシステム。例えば、「私はリンゴを食べるのが好きです。だから今日もリン

ゴを○○○。」という文がある場合、○○○に入る言葉を予測する。

基本的には、過去のデータをもとにして次に来るべき単語を予測するための統計的ル

ールを作り出す。たとえば、"I love"の後には"you"や"coffee"などが来る可能性が高い

ことを学習する。

実際の応用例

言語モデルは、チャットボットや音声認識、機械翻訳、テキスト補完などで広く用い

られる。

spaCyは、自然言語処理のためのオープンソースライブラリであり、多言語のテキス

ト解析をサポートしている。spaCyは言語モデルを用いて品詞タグ付け、依存構造解

析、固有表現抽出などを行う。

以下にspaCyを用いた簡単な言語解析の例を示す。

import spacy

# 英語モデルをロード

nlp = spacy.load('en_core_web_sm')

# テキストの解析

doc = nlp("I love programming and building language models.")

# 各トークン(単語)の品詞を出力

for token in doc:

print(f"Token: {token.text}, POS: {token.pos_}, Lemma: {token.lemma_}")

# 結果は以下のようになる

# Token: I, POS: PRON, Lemma: I

# Token: love, POS: VERB, Lemma: love

# Token: programming, POS: NOUN, Lemma: programming

# Token: and, POS: CCONJ, Lemma: and

# Token: building, POS: VERB, Lemma: build

# Token: language, POS: NOUN, Lemma: language

# Token: models, POS: NOUN, Lemma: model

# Token: ., POS: PUNCT, Lemma: .

上記のコードは、spaCyの英語モデルを使用して与えられた文章を解析し、各単語の

品詞(POS)と基本形(Lemma)を出力する。

spaCyは、内部で事前学習された言語モデルを使用してこれらの情報を提供してい

る。これは、自然言語処理のタスクを簡素化し、多くのアプリケーションで使用され

ている。 Named Entity Recognition (NER) 定義や意味 Named Entity Recognition(NER)は、自然言語処理におけるタスクの一つで、テキ ストから実体名(人名、地名、組織名、日時、数量等)を識別し、それらを特定のカ テゴリに分類する技術。 NERは、テキスト中の語句を特定のエンティティ(実体)として識別するために、機 械学習モデルやルールベースのアプローチを用いる。 数式としては、テキスト T 内の各単語 wi に対して、ラベル yi を予測する問題。す なわち、関数 f : wi → yi を学習することになる。 嚙み砕いた説明 NERは、文章中に出てくる特定の名前や場所、組織などを見つけて、それが何を指し ているのかを教えてくれる技術。 例えば、「Googleの本社はカリフォルニアにあります」という文から、「Google」 が組織名、「カリフォルニア」が地名であることを識別する。 実際の応用例 NERは検索エンジン、質問応答システム、情報抽出、文書分類、テキスト要約など多 岐にわたる応用がある。 特に、ニュース記事からの情報抽出や、カスタマーサポートでの自動応答システムに おいて活用される。 Pythonの自然言語処理ライブラリであるspaCyを利用して、簡単にNERを実行するこ とができる。 以下にspaCyを使用したNERの基本的な例を示す:

import spacy

# spaCyの英語モデルのロード

nlp = spacy.load("en_core_web_sm")

# 対象となるテキスト

text = "Google's headquarters are located in California."

# テキストを解析

doc = nlp(text)

# 文書から抽出されたエンティティを表示

for ent in doc.ents:

print(ent.text, ent.label_)

# 出力は以下のようになる

# Google ORG

# California GPE

このコードでは、 en_core_web_sm という英語の小型モデルを読み込み、テキストを解析し

て、エンティティのテキストとそのラベル(カテゴリ)を抽出して表示している。

「Google」が組織(ORG)として、「California」が地名(GPE: Geopolitical Entity)として

認識されている。

Tokenization Process

定義や意味

トークン化(Tokenization)は、テキストデータを処理可能な小さな単位(トーク

ン)に分割するプロセスを指す

各トークンは単語、句読点、数字、または特定の意味を持つ文字列に対応することが

多い

例えば、文「I have a dog.」はトークン化されると、["I", "have", "a", "dog", "."]といっ

たリストに分割される

数式的に表すと、テキストデータ D がトークン化されると、集合 T =

{t1 , t2 , … , tn } へ変換される

嚙み砕いた説明 トークン化とは、長い文章を意味のある小さな単位に分ける作業 文章をそのまま扱うと長すぎて計算が大変なので、扱いやすい単位に切り分ける 例えば、文を単語ごとに切り分けることで、単語の出現頻度を数えたり、特定の単語 を検索したりするのが容易になる 実際の応用例 自然言語処理(NLP)における前処理として非常に重要なステップ トークン化後のデータは、テキスト分類、感情分析、名前付きエンティティ認識な ど、多くのNLPタスクで使用される ゲーム内のチャットボットの発話解析など、ユーザーとの対話を自然に行うためにも 用いられる 以下は、PythonのNLPライブラリspaCyを使ったトークン化の例: import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # トークン化したいテキスト text = "I have a dog." # テキストをspaCyで処理 doc = nlp(text) # トークンを出力 tokens = [token.text for token in doc] print(tokens) # 出力: ['I', 'have', 'a', 'dog', '.'] このコードスニペットでは、まずspaCyの英語モデルをロードし、次に与えられたテキスト をトークン化している。 doc はテキストを表し、各トークンに対して token.text を用いるこ とで、テキストのリストとして出力される。

Lexeme 定義や意味 Lexemeは言語学における基本的な単位であり、語彙的な意味を持つ最小の単位を指 す 具体的には、ある語のすべての形態的変化(異なる屈折形)を含む単一の抽象的な単 位を表す 言語処理においては、ある単語の基本形やルートを指すことが多い 例えば、英語の動詞 "run" の lexeme は "runs", "ran", "running" のすべてを含む 嚙み砕いた説明 Lexemeとは、いろいろな形に変化する単語をまとめて表すための基本の形のこと たとえば「走る」という意味を持つ単語には「走る」「走った」「走っている」など があるが、これらはすべて同じ「走る」というlexemeに属する この概念を使うと、同じ意味の異なる形の単語をひとまとめにして考えることができ る 実際の応用例 自然言語処理(NLP)において、特に形態素解析や言語モデルの構築に役立つ 例えば、形態素解析ツールとして有名なspaCyでは、Lexemeは単語の基本形やその 関連情報を管理するために使用される spaCyを使ってLexemeを扱うコード例は以下の通り

import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # 単語のLexemeを取得 word = "running" lexeme = nlp.vocab[word] # Lexeme情報の表示 print(f"Text: {lexeme.text}") # 基本形の単語 print(f"Orth: {lexeme.orth}") # 単語の固有ID print(f"Is alpha: {lexeme.is_alpha}") print(f"Is stop: {lexeme.is_stop}") # アルファベットで構成されているか # ストップワードであるか このコードは、単語 "running" の lexeme 情報を取得し、それに関連する情報(例え ば、単語がアルファベットのみで構成されているかどうか、ストップワードであるか どうか)を表示する これにより、異なる形に変化する単語を効率的に処理することが可能になる Lexicon 定義や意味 Lexicon(辞書)は、自然言語処理(NLP)における重要な概念であり、単語とその 関連情報を含むデータベースを指す。これには、単語の形態素、意味、品詞(Part of Speech、POS)、用法、同義語、反意語などが含まれる。Lexiconは、NLPシステム がテキストを解析し、理解するために使用される基本的なリソースの一つ。 形式的には、Lexiconは単語とその属性をペアにした集合として表現され、以下のよ うな形式になる: Lexicon = {(w1 , a1 ), (w2 , a2 ), … , (wn , an )} ここで、wi は単語、ai はその単語に関連する属性の集合を表す。 嚙み砕いた説明 Lexiconは、言葉の「辞書」を想像するとわかりやすい。例えば、「犬」という単語 には「名詞」という品詞や、「動物」「ペット」などの意味が含まれる。Lexiconは

こうした情報をシステムが自動的に理解できるように構造化している。 単に単語のリストではなく、各単語に対する情報を豊富に持っているため、NLPシス テムが文を正確に解釈したり、生成したりする際に役立つ。 実際の応用例 Lexiconは多くのNLPタスクで利用される。例えば、品詞タグ付け、文法解析、機械 翻訳、感情分析などにおいて、Lexiconを参照することで単語の意味や文法的役割を 判断する。 spaCyは先進的なNLPライブラリであり、Lexiconに基づいてテキスト解析を行う。以 下はspaCyを用いた簡単な品詞タグ付けの例: import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析 doc = nlp("The quick brown fox jumps over the lazy dog.") # 各トークンの品詞を出力 for token in doc: print(f"{token.text}: {token.pos_}") # 出力例 # The: DET # quick: ADJ # brown: ADJ # fox: NOUN # jumps: VERB # over: ADP # the: DET # lazy: ADJ # dog: NOUN このように、Lexiconを活用することで、文章中の各単語の品詞を識別し、文の構造 を理解することが可能になる。spaCyはその過程を効率的に処理するための機能を提 供している。

Word Embedding 定義や意味 Word Embeddingとは、自然言語処理において単語をベクトル空間に埋め込む手法の 総称。これにより、単語をコンピュータが理解しやすい数学的な形式に変換する 各単語は高次元のベクトルとして表現され、類似した意味を持つ単語はベクトル空間 内で近くに位置する 具体的には、次のような目的関数を用いて、単語の文脈に基づくベクトルを学習する ことが一般的 T J(θ) = ∑ log P (wi ∣ wi−k , … , wi−1 , wi+1 , … , wi+k ) i=1 ここで、P (wi ∣ wi−k , … , wi−1 , wi+1 , … , wi+k )は、単語wi がその前後の単語の 文脈からの条件付き確率を示す 嚙み砕いた説明 Word Embeddingは、単語を数値で表す方法。これにより、コンピュータは単語の意 味を理解しやすくなる 例えば、「王」と「女王」は類似した意味を持つため、それぞれのベクトルはベクト ル空間内で近くに位置する 単語がベクトルで表現されるため、ベクトル同士の足し算や引き算で意味的な操作が 可能になる。例として「女王」-「女性」+「男性」=「王」といった操作が考えられ る 実際の応用例 Word Embeddingは、自然言語処理タスク(例えば、文書分類、感情分析、質問応答 システムなど)で広く使用される spaCyを利用したWord Embeddingの例を以下に示す

import spacy

# spaCyの言語モデルをロード

nlp = spacy.load("en_core_web_md")

# 単語をベクトルに変換

word_queen = nlp("queen").vector

word_king = nlp("king").vector

word_woman = nlp("woman").vector

word_man = nlp("man").vector

# ベクトル演算による類似性の概念

result_vector = word_queen - word_woman + word_man

# 結果のベクトルに最も近い単語を探す

similarity = {}

for word in nlp.vocab:

if word.has_vector:

similarity[word.text] = word.vector @ result_vector / (word.vector_norm * result

# 類似度が最も高い単語を表示

sorted_similarity = sorted(similarity.items(), key=lambda item: -item[1])

print(sorted_similarity[:10])

上記の例では、spaCyを用いて「女王」から「女性」を引いて「男性」を足すこと

で、新しいベクトルを得ている。このベクトルに最も近い単語を探し出すことで、意

味的に類似した単語を発見することができる

Component

定義や意味

コンポーネントとは、プログラミングやゲーム開発における個々の機能や振る舞いを

独立したモジュールとして定義したもの

対象のオブジェクトに対して、特定の性質や能力を付与するための単位

コンポーネント指向の設計は、オブジェクト指向の設計とは異なり、オブジェクトの

継承ではなく、コンポーネントの組み合わせによってオブジェクトを構成する

数式による具体例を示すと、コンポーネントを Ci として、オブジェクト O が n 個

のコンポーネントからなるとき、O = {C1 , C2 , … , Cn } という集合で表現される

嚙み砕いた説明 コンポーネントは、プログラムやゲームの中で繰り返し使う特定の機能を小さな部品 として切り出したもの 例えば、ゲーム内のキャラクターに「移動」や「攻撃」という能力を付けたいとき、 それぞれの能力をコンポーネントとして作成し、必要なキャラクターにそれらを組み 込む これにより、異なるキャラクターに同じ「移動」や「攻撃」機能を簡単に追加できる し、特定の機能だけを交換したり修正したりできる 実際の応用例 Unityなどのゲームエンジンでは、コンポーネントを用いた設計が一般的で、例えば 「物理挙動コンポーネント」や「描画コンポーネント」など、様々なコンポーネント をオブジェクトに追加することが可能 Pythonでは、コンポーネント指向の設計をサポートするためにクラスやモジュールを 利用する

class Component: """基本的なコンポーネントクラス""" def update(self): pass class MoveComponent(Component): """移動コンポーネント""" def __init__(self, speed): self.speed = speed def update(self, position): # 位置を速度に基づいて更新する position += self.speed class GameObject: """ゲームオブジェクトクラス""" def __init__(self): self.components = [] def add_component(self, component): self.components.append(component) def update(self): for component in self.components: component.update() # ゲームオブジェクトに移動コンポーネントを追加する例 game_object = GameObject() move_component = MoveComponent(speed=5) game_object.add_component(move_component) game_object.update() spaCyに関連した応用例としては、spaCyのパイプラインがコンポーネント指向で設 計されており、トークナイザー、パーサー、エンティティ認識などの処理をコンポー ネントとして追加や並べ替えが可能

import spacy # spaCyのモデルをロード nlp = spacy.load('en_core_web_sm') # パイプラインのコンポーネントを表示 print(nlp.pipe_names) # 新しいコンポーネントを追加 def custom_component(doc): # ここにカスタム処理を追加 return doc nlp.add_pipe(custom_component, last=True) # 更新されたパイプラインのコンポーネントを表示 print(nlp.pipe_names) このように、コンポーネントを用いることで、プログラムの機能を柔軟に組み合わせ ることが可能になる Processing Pipeline 定義や意味 Processing Pipelineとは、データを処理する際に一連のステップを順序立てて実行す る仕組みのことを指す。各ステップは、一般的にデータの変換やフィルタリング、解 析などの特定の処理を担い、入力データを受け取り、処理後のデータを次のステップ に渡す。 数学的には、パイプラインを関数の合成として表現できる。例えば、関数f (x), g(x) , h(x)を順に適用するパイプラインは次のように表せる。 (h ∘ g ∘ f )(x) = h(g(f (x))) 嚙み砕いた説明 Processing Pipelineは、データが特定の出発点から始まり、ゴールに到達するまでに 通過する「道筋」を示す。例えば、テキストデータを扱う場合、最初にデータのクリ ーニングを行い、その後にトークン化、品詞タグ付け、依存関係解析などのステップ を順に実行する。

各ステップは前のステップの出力を利用するため、データがステップごとに異なる形 に変わっていくというイメージ。 実際の応用例 spaCyにおけるProcessing Pipelineは自然言語処理(NLP)で使用され、テキストデ ータを効率的に解析する。spaCyのパイプラインには、トークナイザー、タグ付け 器、パーサー、エンティティ認識器などが含まれる。 以下は、spaCyを用いた簡単なパイプラインの例である。 import spacy # spaCyのモデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析する text = "Apple is looking at buying U.K. startup for $1 billion" doc = nlp(text) # パイプラインを通過した後の結果を出力 for token in doc: # トークン化された単語とその品詞を表示 print(f"Word: {token.text}, POS: {token.pos_}") # エンティティ認識の結果を出力 for ent in doc.ents: print(f"Entity: {ent.text}, Label: {ent.label_}") 上記のコードでは、入力されたテキストがspaCyのパイプラインを通じてトークン化 され、各トークンの品詞がタグ付けされる。また、エンティティ認識を通じてテキス ト内の固有名詞が識別される。 これにより、テキストデータの解析が効率的に行えるようになる。 Span 定義や意味 Spanは一般に、ベクトル空間の線形代数における概念であり、特定のベクトル集合の 線形結合をすべて含む最小の部分空間を指す。特に、自然言語処理ライブラリである

spaCyにおいては、 Span はテキスト内の連続したトークンの部分列を表すオブジェク トとして使用される。 数式的には、ベクトル空間内のベクトル集合{v1 , v2 , … , vn }が与えられたとき、そ の集合のスパンは、すべての線形結合c1 v1 + c2 v2 + ⋯ + cn vn (ただしci はスカラ ー)として表される。 spaCyにおける Span は、次のようにPythonで表現される。 import spacy # nlpオブジェクトの作成 nlp = spacy.load("en_core_web_sm") # テキストのパース doc = nlp("This is a sentence.") # Spanオブジェクトの作成 span = doc[0:2] # "This is"というテキストを含むSpan 嚙み砕いた説明 線形代数におけるスパンは、いくつかのベクトルを組み合わせて作れるすべてのベク トルをまとめたもので、ベクトルが他のベクトルの組み合わせで作れるかどうかを考 えるために使う。 spaCyにおける Span は、文章中の特定の部分を指し示すためのもので、例えば"この 文の一部"をトークンとして取り扱うために使う。 たとえば、文全体から特定の単語やフレーズを取り出して注目したいときに Span を 使う。 実際の応用例 自然言語処理では、文の中から特定の単語やフレーズを取り出して、その意味を解析 したり、特徴を抽出したりする場面で Span が利用される。 spaCyを使用した例として、文から特定の名詞句を抽出して、それに特定の処理を行 うことができる。

import spacy # nlpオブジェクトの作成 nlp = spacy.load("en_core_web_sm") # テキストをパース doc = nlp("Apple is looking at buying U.K. startup for $1 billion") # 名詞句を抽出し、各名詞句を出力 for chunk in doc.noun_chunks: print(chunk.text) # 出力例: # Apple # U.K. startup # $1 billion 上記のコードでは、 Span オブジェクトを使って文中の名詞句を抽出し、それぞれを 出力している。これは情報抽出やテキスト解析において非常に有用である。 Token Attributes 定義や意味 Token Attributesは、自然言語処理ライブラリであるspaCyにおいて、テキストを構成 する単語や句(トークン)の様々な情報を取得するための属性群を指す 各トークンは、テキスト内の単一の単語や記号を表し、これに関連する様々な属性情 報を持つ spaCyでは、トークンごとにその形態素情報(例えば、品詞、活用形など)、文法的 関係(依存関係)、および位置情報(文中の開始位置や終了位置)などを取得できる 嚙み砕いた説明 トークンとは文章を構成する最小の単位で、通常は単語や句を表す Token Attributesとは、これらのトークンに関連する情報で、例えばその単語がどんな 意味を持つか、文法的にどんな役割を果たしているかを示す spaCyでは、簡単にテキストをトークンに分割し、その詳細な情報をプログラムから 取得できる

実際の応用例 Token Attributesは、文章解析や自然言語処理のタスクにおいて重要な役割を果たす 例えば、テキストの品詞を取得して文法的な解析を行ったり、依存関係を調べて意味 解析を行ったりするのに利用される 以下に、spaCyを用いた具体的なコード例を示す。 import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析 doc = nlp("Apple is looking at buying U.K. startup for $1 billion") # 各トークンの属性を表示 for token in doc: print(f"Text: {token.text}") # トークンのテキスト print(f"Lemma: {token.lemma_}") # 原形 print(f"POS: {token.pos_}") # 品詞 print(f"Tag: {token.tag_}") # 詳細な品詞 print(f"Dep: {token.dep_}") # 依存関係 print(f"Shape: {token.shape_}") # 形状(大文字小文字のパターン) print(f"Is alpha: {token.is_alpha}")# アルファベットかどうか print(f"Is stop: {token.is_stop}") print("") # ストップワードかどうか # 改行 このコードは、テキストをトークンに分解し、それぞれのトークンの様々な属性を取得して 表示する。このようにして、テキストの詳細な解析を行うことが可能となる。 Pre-trained Models 定義や意味 Pre-trained Models(事前学習モデル)は、特定のタスクのために一からモデルを学 習するのではなく、既に大規模なデータセットで学習されたモデルを使用して、その モデルを転用または微調整する手法。 事前学習モデルは、通常、自然言語処理(NLP)や画像認識の分野で使用される。大 規模なデータセット上で一般的なパターンを学習しており、特定のタスクに対して微

調整(ファインチューニング)することで高精度な結果を得る。 微調整の際には、損失関数を最小化するための最適化手法が用いられる。例えば、損 失関数 L(θ) の最小化を考えるとき、モデルのパラメータ θ は次のように更新され る: θt+1 = θt − η∇θ L(θt ) ここで、η は学習率を示す。 嚙み砕いた説明 Pre-trained Modelsは、すでに「勉強済み」のモデルを流用することを意味する。こ れにより、一からモデルを学習するのに比べて時間や計算資源を大幅に節約できる。 例えば、犬と猫の画像を分類するモデルを作るとき、すでに大量の画像で学習された モデルを使うことで、少量の犬と猫の画像を使って微調整するだけで高精度な分類が 可能になる。 自然言語処理の分野では、BERTやGPTのようなモデルが事前学習モデルとしてよく 知られており、これらは文章の意味を理解するために多くのテキストで事前学習され ている。 実際の応用例 Pre-trained Modelsは、NLPのタスク(例:文章の分類、感情分析、名前付きエンテ ィティ認識など)で頻繁に使用される。これにより、開発者は特定のタスクに対して モデルを訓練する時間を短縮できる。 spaCyは、NLPのためのオープンソースライブラリで、事前学習された言語モデルを 利用することで、テキストの解析や処理を簡単に行える。 以下は、spaCyで事前学習モデルを使用してテキストを解析する例:

import spacy # spaCyの事前学習モデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析 doc = nlp("Apple is looking at buying U.K. startup for $1 billion") # トークンとその品詞タグを出力 for token in doc: print(token.text, token.pos_) # 出力例: # Apple PROPN # is AUX # looking VERB # at ADP # buying VERB # U.K. PROPN # startup NOUN # for ADP # $ SYM # 1 NUM # billion NUM この例では、spaCyの事前学習モデルを使ってテキストを解析し、各単語の品詞(名 詞、動詞など)を取得している。 Custom Models 定義や意味 カスタムモデルとは、既存の機械学習モデルをベースとして、特定のタスクやデータ セットに合わせて調整したモデルのことを指す。特に自然言語処理(NLP)の分野で は、カスタムモデルによって言語の特定のニュアンスや専門用語を理解する能力を高 めることができる。 数式で表現すると、カスタムモデルは次のように定義される。既存のモデルを Mbase とし、新たなタスクに特化したモデルを Mcustom とすると、Mcustom は以下のよう に表現される: Mcustom = f (Mbase , D, θ)

ここで、D は特定のデータセット、θ は調整されたパラメータ。 嚙み砕いた説明 カスタムモデルは、基本的な学習済みモデルに特定のデータや要件を加えることで、 より専門的なタスクに適用できるようにしたもの。例えば、一般的な英語のニュース を分析するためのモデルがあるとして、そのモデルを特定の業界の専門用語や独自の 文体に適応させるためにカスタマイズすることができる。 実際の応用例 カスタムモデルは、特にNLPの分野で応用され、テキスト分類、固有表現認識、文書 の要約などに利用される。例えば、spaCyを用いたカスタムモデルの作成を考える。

import spacy

from spacy.training import Example

from spacy.pipeline.textcat import Config, single_label_cnn_config

# 既存の言語モデルをロード

nlp = spacy.load("en_core_web_sm")

# テキスト分類パイプラインを追加

textcat_config = Config().from_str(single_label_cnn_config)

textcat = nlp.add_pipe("textcat", config=textcat_config, last=True)

# カテゴリを追加

textcat.add_label("POSITIVE")

textcat.add_label("NEGATIVE")

# トレーニングデータ

train_data = [

("I love this product", {"cats": {"POSITIVE": 1, "NEGATIVE": 0}}),

("This is the worst experience", {"cats": {"POSITIVE": 0, "NEGATIVE": 1}})

]

# トレーニング

optimizer = nlp.begin_training()

for i in range(10):

# epochs

for text, annotations in train_data:

doc = nlp.make_doc(text)

example = Example.from_dict(doc, annotations)

nlp.update([example], sgd=optimizer)

# 新しいテキストの分類

doc = nlp("I am very happy with the service")

print(doc.cats)

# {'POSITIVE': 0.9, 'NEGATIVE': 0.1}

この例では、spaCyを用いてカスタムのテキスト分類モデルを構築。既存のモデルに

新たな分類カテゴリを追加し、特定のデータを使用してトレーニングを行い、カスタ

ムモデルを完成させている。

Entity Types 定義や意味 Entity Typesは、自然言語処理(NLP)の分野で用いられる概念で、テキスト中の固有 名詞や特定の意味を持つ単語群を分類するカテゴリのことを指す。具体的には、人 名、地名、組織名、日付、金額などが含まれる。 この概念は、特にNamed Entity Recognition(NER)タスクで重要であり、NERは文 章中からこれらのEntity Typesを識別し、特定のカテゴリに属するものとしてラベル 付けを行う。 嚙み砕いた説明 Entity Typesとは、文中で出てくる「特別な意味を持つ単語の種類」を指す。例えば 「東京」は地名、「2023年」は日付、「ジョン・スミス」は人名といった具合に、こ れらの単語をそれぞれのカテゴリに分ける。 こうした分類は、テキスト解析を行う際に、文の意味をより深く理解するために役立 つ。例えば、文章中の「東京」という単語を地名として認識することで、その文がど こに関連しているのかを知ることができる。 実際の応用例 NLPライブラリであるspaCyを用いたテキスト解析では、Entity Typesを用いて文章か ら特定の情報を抽出することができる。例えば、ニュース記事から人物名や企業名を 抽出して、どのニュースがどの人物や組織に関連しているかを分析する。 以下に、PythonのspaCyライブラリを用いたEntity Typesの識別例を示す:

import spacy # spaCyのモデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析 text = "Apple is looking at buying U.K. startup for $1 billion" doc = nlp(text) # テキスト中のエンティティを表示 for ent in doc.ents: print(ent.text, ent.label_) # 出力例: # Apple ORG # U.K. GPE # $1 billion MONEY このコードスニペットでは、 en_core_web_sm というspaCyの事前学習済みモデルを用 いて、テキスト中の「Apple」を組織(ORG)、「U.K.」を地名(GPE)、「$1 billion」を金額(MONEY)として識別している。 NER Training 定義や意味 NER(Named Entity Recognition)は、テキストデータ内から固有名詞を抽出し、そ れを特定のカテゴリに分類する自然言語処理(NLP)のタスク カテゴリには、例えば人名、組織名、地名、日付などが含まれる NERトレーニングは、ニューラルネットワークや他の機械学習モデルを用いて、この タスクを実行するモデルを学習させるプロセス モデルは、通常、ラベル付きのテキストデータセットを用いて教師あり学習を行い、 テキスト中のエンティティの境界とラベルを学習する 嚙み砕いた説明 NERはテキストから意味のある単語やフレーズを探し出し、それが何を指しているの かを特定する技術

例えば、「AppleはiPhoneを発売しました」という文章から、「Apple」を企業名とし て、「iPhone」を製品名として認識すること トレーニングは、たくさんの例文をモデルに見せて、「これは企業名」「これは製品 名」などと教える作業 spaCyを使うと、NERモデルのトレーニングが比較的簡単に行える 実際の応用例 NERは、情報抽出、質問応答システム、文書の自動要約、記事の分類などのタスクで 利用される 例えば、ニュース記事から企業名や場所、金額などを自動抽出してデータベースに保 存する処理 以下は、spaCyを用いたNERモデルのトレーニング例

import spacy from spacy.training import Example # 空のモデルを作成 nlp = spacy.blank("en") # NERパイプラインを追加 ner = nlp.add_pipe("ner") # カテゴリ(ラベル)を追加 ner.add_label("PERSON") ner.add_label("ORG") # 訓練データの例 TRAIN_DATA = [ ("Steve Jobs was the CEO of Apple.", {"entities": [(0, 10, "PERSON"), (25, 30, "ORG" ("Bill Gates founded Microsoft.", {"entities": [(0, 10, "PERSON"), (22, 31, "ORG")]} ] # トレーニング optimizer = nlp.begin_training() for i in range(100): # エポック数 for text, annotations in TRAIN_DATA: example = Example.from_dict(nlp.make_doc(text), annotations) nlp.update([example], drop=0.5, sgd=optimizer) # モデルのテスト doc = nlp("Elon Musk is the CEO of SpaceX.") for ent in doc.ents: print(ent.text, ent.label_) # 出力: Elon Musk PERSON # SpaceX ORG このコードスニペットは、spaCyを用いた簡単なNERトレーニングの例を示している。ま ず、空の言語モデルを作成し、NERコンポーネントを追加してカテゴリを定義する。次に、 訓練データを用意し、モデルをトレーニングする。最後に、トレーニングされたモデルを使 って新しい文章からエンティティを抽出する。

Tagger 定義や意味 Taggerは、自然言語処理(NLP)においてテキストの各単語に対して品詞(Part of Speech, POS)やその他の形態素情報を付与するためのツールやアルゴリズムの総称 POSタグ付けは、文中の各単語に対してその文法的役割を示すラベルを付与するプロ セス 例えば、"The cat sat on the mat." という文に対して、"The" は冠詞 (ART)、"cat" は名 詞 (NOUN)、"sat" は動詞 (VERB) などのタグを付与する POSタグ付けは一般に、確率モデル(例:隠れマルコフモデル)や機械学習アルゴリ ズムを使用して実行される 嚙み砕いた説明 Taggerは、文章を理解するために各単語の役割を特定する道具で、まるで文章にタグ を付けるようなもの 例えば、"私はリンゴを食べた"という文にタグを付けると、"私"は主語、"リンゴ"は目 的語、"食べた"は動詞として認識される これにより、文章の構造を理解しやすくするだけでなく、他の自然言語処理タスク (例:文脈の理解、翻訳)をサポートする 実際の応用例 Taggerは様々なNLPアプリケーションで使用されており、特に情報抽出、機械翻訳、 音声認識、テキスト要約などで重要な役割を果たす spaCyはPythonで広く使われる自然言語処理ライブラリで、高速かつ高精度なPOSタ グ付け機能を提供している 以下は、spaCyを用いたPOSタグ付けの実装例:

import spacy

# spaCyの英語モデルをロード

nlp = spacy.load("en_core_web_sm")

# 対象となるテキスト

text = "The quick brown fox jumps over the lazy dog."

# テキストを処理してDocオブジェクトを生成

doc = nlp(text)

# 各トークン(単語)に対して、そのテキストとPOSタグを表示

for token in doc:

print(f"Word: {token.text}, POS: {token.pos_}, Tag: {token.tag_}")

上記コードスニペットでは、テキストを解析し、各単語に対応するPOSタグと詳細な

タグ情報を出力している

token.pos_ は一般的な品詞タグを、 token.tag_ は詳細な品詞情報を提供

このように、Taggerを利用することで、テキストデータをより深く分析することが可

能となる

Parser

定義や意味

パーサーとは、入力されたデータ(通常はテキスト)を解析し、その構造を理解する

ためのコンポーネント。特にプログラミング言語や自然言語の文法に従って入力を解

析する際に使用される。パーサーは、入力を構文木(パースツリー)に変換し、その

構造を明示的に表現する。

パーサーは以下のような形式的な文法に基づいて動作することが多い。例えば、コン

テキストフリーワード文法(CFG: Context-Free Grammar)を用いる場合、以下のよ

うな構文ルールがあるとする:

S → aSb ∣ ϵ

ここで、S は開始記号、aとbはターミナルシンボル、ϵは空文字列を示す。

嚙み砕いた説明 パーサーとは、テキストデータを「読み解く」ためのツール。例えば、文章を読み、 主語や動詞を特定することができる。また、プログラミングの世界では、ソースコー ドを解析し、その構造を理解するために使われる。具体的には、文を細かく分けて 「これは動詞」「これは名詞」といった形で分類し、それらを組み合わせて全体の意 味を把握する。 実際の応用例 パーサーは様々な場面で応用されている。例えば、自然言語処理 (NLP) の分野では、 テキストから文法構造や意味を抽出するために使用される。Pythonの自然言語処理ラ イブラリ「spaCy」はその一例であり、高速で効率的なパーサーを内蔵している。 以下に、spaCyを用いた簡単なパーサーの例を示す。 import spacy # spaCyの言語モデルをロード nlp = spacy.load("en_core_web_sm") # 解析するテキスト text = "The quick brown fox jumps over the lazy dog." # テキストを解析 doc = nlp(text) # 各文の構文解析結果を表示 for token in doc: print(f"Word: {token.text}, POS: {token.pos_}, Dependency: {token.dep_}, Head: {toke # 結果として、各単語の品詞(POS)、係り受け構造(Dependency)、およびその親ノード(Head)を出力 この例では、spaCyのパーサーを使用して文の各単語に対する品詞(POS)や係り受け関係 (Dependency)を解析している。これは、テキストデータを構造化し、意味を理解するため の第一歩となる。

Entity Recognizer 定義や意味 Entity Recognizer(エンティティ認識器)は、テキストから特定のエンティティを識 別し、抽出するための自然言語処理(NLP)の技術 エンティティとは、通常、固有名詞や特定のカテゴリーに属する名詞を指し、たとえ ば人名、地名、組織名、日付、金額などが含まれる エンティティ認識を行う際には、多くの場合、事前に定義されたラベルセットがあ り、テキスト中のそれぞれのエンティティがどのラベルに属するかを分類する 数式で表現すると、テキスト T に対して、エンティティの集合 E = {e1 , e2 , … , en } を識別し、各エンティティ ei にラベル li を割り当てる 形式的には、f (T ) = {(e1 , l1 ), (e2 , l2 ), … , (en , ln )} という関数 f を見つける問 題 嚙み砕いた説明 簡単に言うと、Entity Recognizerは文章の中から「誰が」「どこで」「何を」などの 情報を見つけ出す技術 たとえば、"Apple was founded by Steve Jobs in Cupertino." という文から、 「Apple」は組織、「Steve Jobs」は人名、「Cupertino」は地名という情報を見つけ 出す この技術を使うことで、文章をより意味のある単位に分解し、情報を整理することが できる 実際の応用例 Entity Recognizerは、情報抽出、質問応答システム、検索エンジンの最適化、カスタ マーサービスのチャットボットなどで活用されている 例として、Pythonの自然言語処理ライブラリspaCyを用いたエンティティ認識のコー ドスニペットを示す

import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # テキストを解析 text = "Apple was founded by Steve Jobs in Cupertino." doc = nlp(text) # 認識されたエンティティを出力 for ent in doc.ents: print(ent.text, ent.label_) # 出力例: # Apple ORG # Steve Jobs PERSON # Cupertino GPE このコードでは、 en_core_web_sm というspaCyの英語モデルを使用し、テキストを解 析してエンティティを抽出 doc.ents を用いることで、テキスト中に認識されたエンティティとそのラベル(例え ば、組織名「ORG」、人名「PERSON」、地名「GPE」など)を取得可能 Phrase Matching 定義や意味 Phrase Matchingは、テキストデータから特定のフレーズを効率的に見つけ出す手法 の一つ 特に自然言語処理(NLP)において、与えられたフレーズがテキスト中に出現するか どうかを迅速に判定するために使用される spaCyなどのNLPライブラリでは、トークン化されたテキストに対して特定のパター ンを設定し、マッチするフレーズを抽出する 数式的には、テキストをトークンの列 T = {t1 , t2 , … , tn } とし、目標とするフレー ズをトークンの列 P = {p1 , p2 , … , pm } として、P が T のサブシーケンスとして 存在するかを判定する問題

嚙み砕いた説明 Phrase Matchingは、例えば文章中から特定の単語の組み合わせ(例: "machine learning")を探し出す技術 単語を一つ一つチェックして、フレーズがそのままの形でテキスト内に出現するかを 確認する 検索対象のフレーズがどの位置にあるかを特定するのが主な目的 例えば、ニュース記事から "climate change" というフレーズが含まれる文を抽出する ことなどに使える 実際の応用例 デジタルアシスタントが特定のコマンドを認識する際に使用される 顧客のフィードバックやレビューから特定のキーワードを抽出し、分析を行う コンテンツフィルタリング、例えば不適切な表現をフィルタリングする際に、特定の フレーズを検出する 以下は、PythonのspaCyライブラリを用いた簡単なPhrase Matchingの実装例:

import spacy from spacy.matcher import PhraseMatcher # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # PhraseMatcherを初期化 matcher = PhraseMatcher(nlp.vocab) # マッチさせたいフレーズを定義 phrases = ["machine learning", "natural language processing", "artificial intelligence"] patterns = [nlp(text) for text in phrases] # PhraseMatcherにパターンを追加 matcher.add("TechTerms", None, *patterns) # テストするテキスト text = "I am learning about natural language processing and machine learning." # テキストをspaCyのDocに変換 doc = nlp(text) # マッチングを実行 matches = matcher(doc) # マッチした部分を表示 for match_id, start, end in matches: span = doc[start:end] print(f"Matched phrase: {span.text}") このコードは、与えられたテキストから事前に指定した技術用語のフレーズを探し出すため にspaCyのPhraseMatcherを使用している。結果として、"natural language processing" や "machine learning" などがテキスト中から検出される。 Syntactic Dependency 定義や意味 Syntactic Dependency(統語的依存性)とは、文中の単語間の関係を示す概念であ り、特にどの単語が他の単語にどのように依存しているかを示す

これによって、文法構造が明らかになり、自然言語処理において重要な役割を果たす 統語的依存解析の結果は、通常、依存木(dependency tree)として表現される。こ の木の各ノードは単語を表し、エッジは依存関係を表す 嚙み砕いた説明 Syntactic Dependencyは、文を構成する各単語がどのように繋がり合っているかを示 す 例えば、「The cat sat on the mat」という文では、「sat」が主要な動詞で、「cat」 が「sat」の主語として、「on」が前置詞として「sat」と繋がっている このような関係性を視覚化することで、文の意味や構造をより深く理解できる 実際の応用例 Syntactic Dependencyは、自然言語処理(NLP)で多くの応用がある。例えば、文の 意味解析、情報抽出、機械翻訳など PythonのNLPライブラリspaCyを使用すると、簡単に統語的依存解析を行うことがで きる 以下に、spaCyを用いた簡単なコードスニペットを示す:

import spacy

# spaCyの英語モデルをロード

nlp = spacy.load('en_core_web_sm')

# 解析する文

doc = nlp("The quick brown fox jumps over the lazy dog")

# 各トークンの依存関係を表示

for token in doc:

print(f"Word: {token.text}, Dependency: {token.dep_}, Head: {token.head.text}")

# 出力例:

# Word: The, Dependency: det, Head: fox

# Word: quick, Dependency: amod, Head: fox

# Word: brown, Dependency: amod, Head: fox

# Word: fox, Dependency: nsubj, Head: jumps

# Word: jumps, Dependency: ROOT, Head: jumps

# Word: over, Dependency: prep, Head: jumps

# Word: the, Dependency: det, Head: dog

# Word: lazy, Dependency: amod, Head: dog

# Word: dog, Dependency: pobj, Head: over

このコードは文をspaCyで解析し、それぞれの単語の依存関係を表示する

各単語の依存タグ(例えば、 det は限定詞、 nsubj は主語など)が表示され、どの単

語に依存しているか(Head)が示されている

こうした情報を用いることで、文の構造を理解し、さらなる自然言語処理タスクに応

用できる

Part-of-Speech Tagging

定義や意味

Part-of-Speech (POS) Taggingは、自然言語処理における基本的なタスクの一つであ

り、文章中の各単語に対してその品詞を割り当てるプロセス

品詞とは、名詞、動詞、形容詞、副詞など、文法上のカテゴリに基づいて単語を分類

するもの

POS Taggingは、文法解析や情報抽出、機械翻訳などの多くの自然言語処理タスクの

基盤となる

形式的には、与えられた単語の列 w1 , w2 , … , wn に対して、対応する品詞の列 t1 , t2 , … , tn を見つけるタスクとして定義される 嚙み砕いた説明 POS Taggingは、文章中の単語に「名詞」「動詞」「形容詞」などのラベルを付ける 作業 例えば、「The quick brown fox jumps over the lazy dog」という文に対して、"The" は冠詞、"quick" は形容詞、"brown" は形容詞、"fox" は名詞、"jumps" は動詞、"over" は前置詞、"the" は冠詞、"lazy" は形容詞、"dog" は名詞とタグ付けする これにより、コンピュータは文の構造を理解しやすくなる 実際の応用例 POS Taggingは、テキストの意味理解や文法解析、情報抽出、機械翻訳などに使われ る spaCyを用いたPOS Taggingの実例を以下に示す

import spacy # spaCyの英語モデルをロード nlp = spacy.load("en_core_web_sm") # 対象のテキスト text = "The quick brown fox jumps over the lazy dog." # テキストを解析 doc = nlp(text) # 各単語とその品詞を出力 for token in doc: print(f"{token.text}: {token.pos_}") # 結果: # The: DET # quick: ADJ # brown: ADJ # fox: NOUN # jumps: VERB # over: ADP # the: DET # lazy: ADJ # dog: NOUN 上記のコードでは、spaCyの自然言語処理ライブラリを使用して、英語の文章を解析 し、各単語に品詞タグを付ける en_core_web_sm は、spaCyの英語用の小型モデルで、軽量かつ高速に動作する token.pos_ を用いることで、各トークン(単語)の品詞情報を取得可能 Dependency Parsing 定義や意味 Dependency Parsing(依存構文解析)は、文の構造を解析し、各単語の文法的な関係 を明らかにするプロセスを指す。具体的には、文中の各単語がどのように他の単語に 依存しているかを示す「依存関係」を導出する。

依存関係は通常、木構造を形成し、各ノードは文の単語を表し、エッジは単語間の依 存関係を表す。 例えば、文「The cat sat on the mat.」において、「sat」が動詞で中心となり、 「cat」が主語として「sat」に依存し、「on the mat」が場所を表す句として「sat」 に依存する。 数式的に、文 S は単語の列 {w1 , w2 , … , wn } として表され、各単語 wi は他の単語 wj に依存し、その関係はペア (wi , wj ) として表現される。 嚙み砕いた説明 Dependency Parsingは、文章を理解するための分析手法で、文章の中でどの単語がど の単語に影響を与えているのかを明らかにするもの。 人間は自然に「主語」「動詞」「目的語」などの役割を文中で把握するが、コンピュ ータはこれを自動的に解析する必要がある。この解析を行うのがDependency Parsing。 文法的な関係を理解することで、自然言語処理の様々な応用に役立つ。 実際の応用例 Dependency Parsingは、自然言語処理の多くの分野で応用されている。特に、情報抽 出、質問応答システム、機械翻訳で重要な役割を果たす。 以下にPythonの自然言語処理ライブラリspaCyを使用したDependency Parsingの例を 示す。

import spacy

# spaCyの英語モデルをロード

nlp = spacy.load("en_core_web_sm")

# 解析したい文

sentence = "The cat sat on the mat."

# 文を解析

doc = nlp(sentence)

# 各トークンの依存関係を表示

for token in doc:

# token.text: トークンのテキスト

# token.dep_: 依存関係のラベル

# token.head.text: トークンの親のテキスト

print(f"{token.text} ({token.dep_}) <-- {token.head.text}")

# 出力例:

# The (det) <-- cat

# cat (nsubj) <-- sat

# sat (ROOT) <-- sat

# on (prep) <-- sat

# the (det) <-- mat

# mat (pobj) <-- on

このコードは、spaCyを用いて文を解析し、各単語の依存関係を出力する。ここ

で、 token.dep_ はトークンの依存関係ラベルを示し、 token.head.text はそのトークンが依

存している親トークンを示す。