SP_Librosa

2.3K Views

November 28, 24

スライド概要

医学生。AIや業務・学習効率化に興味あり。

関連スライド

DL_PyTorch

各ページのテキスト

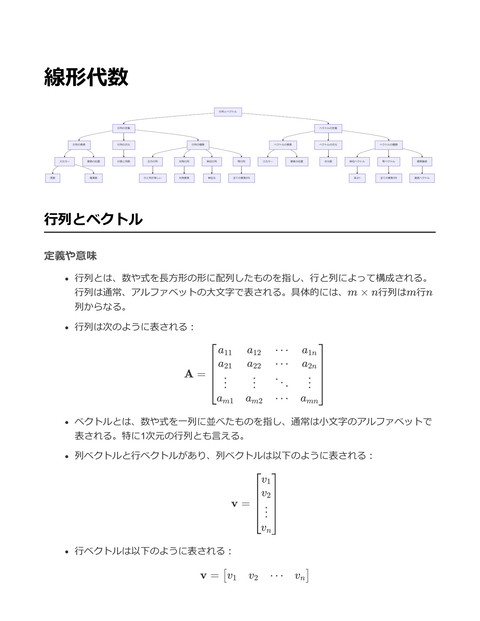

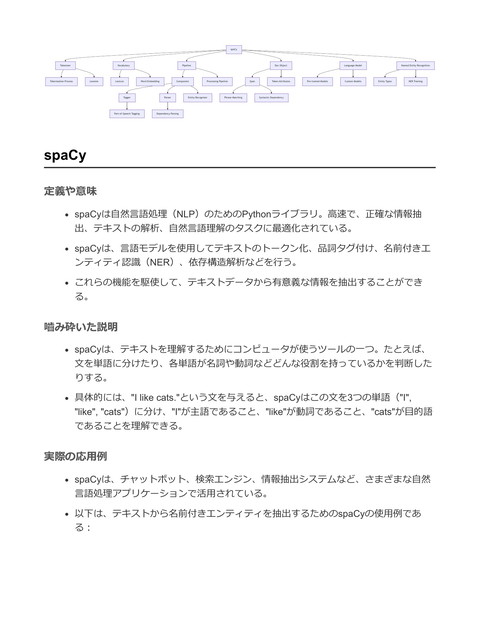

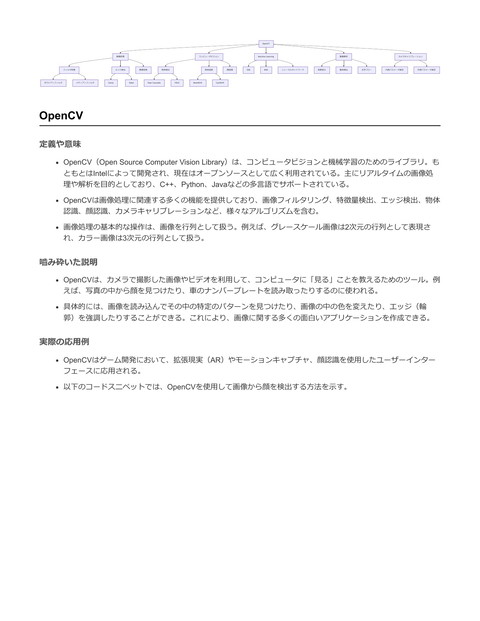

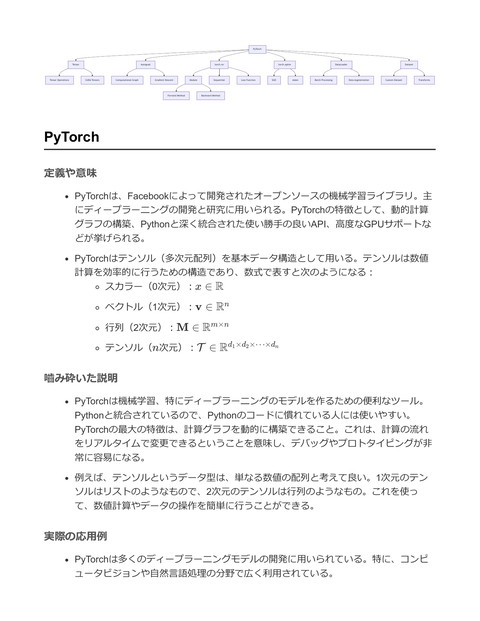

Librosa 音声読み込み Waveform Sample Rate Time-Frequency Representation Feature Extraction Mono/Stereo MFCC Chroma Features Spectral Contrast Mel Spectrogram STFT Griffin-Lim Algorithm Constant-Q Transform 音声合成 Pitch and Tuning Pitch Tracking Autocorrelation Harmonic Analysis YIN Algorithm Inverse STFT Overlap Add Effects and Filters Griffin-Lim Synthesis Time Stretching Pitch Shifting Phase Reconstruction Librosa 定義や意味 LibrosaはPythonで音楽やオーディオ解析を行うためのライブラリ 特に音楽情報検索(MIR)における信号処理のためのツールを提供 音声信号の特徴抽出、音声ファイルの読み込み、再生、スペクトログラムの生成など の機能を持つ コア機能には短時間フーリエ変換(STFT)、メルスペクトログラムの計算、ビート 追跡、テンポ推定、ピッチ検出などが含まれる 嚙み砕いた説明 Librosaは音楽や音声を扱うための便利なツールセット 音楽のビートを見つけたり、曲のテンポを知ることができる 音声ファイルを解析して、音の高さやリズムを数値として取り出せる ゲームやアプリで音楽を分析したり、音声を編集するために利用 実際の応用例 音楽のジャンル分類や曲のテンポの変化を検出する ゲームでのリアルタイムな音楽ビジュアライゼーション 音声コマンドの解析や音声認識システムの構築 以下にLibrosaを用いた基本的なコードスニペットを示す

import librosa

import librosa.display

import numpy as np

import matplotlib.pyplot as plt

# 音声ファイルのロード

file_path = 'example.wav'

y, sr = librosa.load(file_path)

# 短時間フーリエ変換(STFT)の計算

D = np.abs(librosa.stft(y))

# メルスペクトログラムの計算

S = librosa.feature.melspectrogram(y=y, sr=sr)

# スペクトログラムの表示

plt.figure(figsize=(10, 4))

librosa.display.specshow(librosa.amplitude_to_db(S, ref=np.max),

y_axis='mel', x_axis='time')

plt.title('Mel spectrogram')

plt.colorbar(format='%+2.0f dB')

plt.tight_layout()

plt.show()

# ビートの検出

tempo, beats = librosa.beat.beat_track(y=y, sr=sr)

print(f"Estimated tempo: {tempo} BPM")

上記スニペットでは、音声ファイルを読み込み、メルスペクトログラムを表示し、曲

のテンポを推定している

librosa.load() で音声ファイルのデータを取得

し、 librosa.stft() や librosa.feature.melspectrogram() でスペクトラム解析を行う

librosa.beat.beat_track() でテンポとビートを推定し、リアルタイムアプリケーショ

ンや音楽分析に利用可能

音声読み込み 定義や意味 音声読み込みとは、デジタルオーディオデータをプログラムに取り込むプロセスのこ とを指す。デジタルオーディオデータは通常、WAVやMP3などのファイル形式で保存 されており、これを扱いやすい形式に変換して利用する。 音声データは通常、サンプリングレート(Hz)に基づいて時間領域で表現される。サ ンプリングレートとは、1秒間に何回音声をサンプリングするかを示す。 嚙み砕いた説明 音声読み込みは、コンピュータに音声ファイルを「聞かせる」ことで、プログラムが その音声を理解し、分析したり変換したりできるようにする工程。 デジタル音声は、アナログ音声を一定間隔でデジタルの数値に変換したもの。それを 再びプログラムで扱える形にするために、音声読み込みが必要。 実際の応用例 音声読み込みは、音声認識システムやミュージックプレイヤー、ゲームにおける効果 音の再生など、さまざまな場面で応用される。 Pythonの音声処理ライブラリ「Librosa」を使用して音声ファイルを読み込む方法の 具体例を以下に示す。 import librosa # 音声ファイルのパス file_path = 'audio/sample.wav' # 音声ファイルを読み込み、波形データとサンプリングレートを取得 waveform, sample_rate = librosa.load(file_path, sr=None) # 波形データとサンプリングレートを出力 print("Waveform: ", waveform) print("Sample Rate: ", sample_rate) 上記のコードでは、 librosa.load() 関数を使用して音声ファイルを読み込 む。 sr=None とすることで、元のサンプリングレートを保持したままデータを取得す る。

波形データは、音声データを数値化したもので、この数値をもとに音声の分析や変換 を行うことができる。 Feature Extraction 定義や意味 Feature Extraction(特徴抽出)とは、データから有用な情報を取り出すプロセスであ り、特に機械学習やデータ解析で重要な役割を果たす 生データから特徴量を取り出すことにより、モデルの性能を向上させる 特徴量を数学的に表現すると、データセット X に対して特徴抽出関数 f は、f : X → F であり、F は特徴空間 音声データにおいては、MFCC(メル周波数ケプストラム係数)やスペクトログラム などが代表的な特徴量 嚙み砕いた説明 Feature Extractionは、データの中から「これが重要だ」と思われる部分を抽出してく る作業 例えば、音楽データの場合、波形そのものではなく、音の高さやリズムを数値化して 取り出す これにより、機械学習モデルは生データの複雑さの影響を受けずに、データの本質的 な情報を学習できる 実際の応用例 音声認識や音楽情報検索において、音声データの特徴量を抽出することは重要 Librosaを使用して音声データからMFCCを抽出する例

import librosa import numpy as np # 音声ファイルの読み込み file_path = 'audio_file.wav' y, sr = librosa.load(file_path, sr=None) # MFCCの抽出 mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13) # MFCCの表示 print("MFCCs shape:", mfccs.shape) 上記のコードでは、Librosaを使って音声ファイルを読み込み、MFCC特徴量を抽出し ている librosa.load で音声データを読み込み、 librosa.feature.mfcc でMFCCを計算 結果として得られる mfccs は、音声データの各フレームに対する13次元の特徴ベクト ルを含む Time-Frequency Representation 定義や意味 時間-周波数表現(Time-Frequency Representation)は、信号を時間領域と周波数領 域の両方で解析する手法。これは、信号の周波数成分が時間とともにどのように変化 するかを捉えるために使用される。 最も一般的な手法の一つが短時間フーリエ変換(Short-Time Fourier Transform, STFT)であり、信号を短い時間窓に分割してそれぞれの窓にフーリエ変換を適用す ることで時間-周波数平面を得る。 STFTを用いると、時間 t における周波数 f の成分は次のように表される: X(t, f ) = ∫ ∞ x(τ )w(τ − t)e−j2πf τ dτ −∞ ここで、x(τ ) は元の信号、w(τ − t) は時間窓関数である。

嚙み砕いた説明 時間-周波数表現は、音楽や音声などの時間的に変化する信号を解析するためによく用 いられる。例えば、音楽の中でドラムやギターがどのようなタイミングで鳴っている かを視覚化することができる。 短時間フーリエ変換(STFT)は、信号を小さな時間の「窓」に区切って、その中で 周波数成分を計算する。これにより、時間とともにどの周波数が現れているかを見る ことが可能になる。イメージとしては、音楽の波形を縦(時間)と横(周波数)の2 次元グラフに変換して色で表すようなもの。 実際の応用例 音響信号処理において、音楽のビートやリズムを抽出するために時間-周波数表現が使 用される。また、音声認識や音楽情報検索の分野でも重要な役割を果たす。 Pythonの音響処理ライブラリであるLibrosaを用いることで、簡単にSTFTを計算し、 時間-周波数表現を得ることができる。 import librosa import librosa.display import matplotlib.pyplot as plt import numpy as np # 音声ファイルをロード y, sr = librosa.load(librosa.example('trumpet')) # 短時間フーリエ変換を計算 D = librosa.stft(y) # 振幅スペクトログラムを取得 S_db = librosa.amplitude_to_db(np.abs(D), ref=np.max) # スペクトログラムをプロット plt.figure(figsize=(10, 6)) librosa.display.specshow(S_db, sr=sr, x_axis='time', y_axis='hz', cmap='magma') plt.colorbar(format='%+2.0f dB') plt.title('Spectrogram (dB)') plt.show() このコードは、Librosaを使用して音声ファイルのSTFTを計算し、振幅スペクトログ ラムとして視覚化する。 specshow 関数を用いることで、時間-周波数平面における信 号の変化を視覚的に確認できる。

Pitch and Tuning 定義や意味 Pitch (音高) とは、音楽理論における音の高低を指す用語。物理的には音波の周波数 (Hz)によって決定される。音楽で使用される標準的なチューニングでは、A4のピ ッチを440Hzとする。 Tuning (調律) は、楽器や音声が特定のピッチに一致するように調整するプロセス。 これには、実際の音の周波数を基準となる周波数に合わせることが含まれる。 数式的には、ある音のピッチP はその周波数f に依存し、A4の音(440Hz)を基準とした相 対的なピッチは以下の式で表される: P = 69 + 12 ⋅ log2 ( f ) 440 嚙み砕いた説明 ピッチは、音がどのくらい高いか低いかを示すもので、まるで音の「高さ」や「位 置」を決めるものと考えるとよい。周波数が高いほど音は高く、低いほど音は低い。 調律は、ピアノやギターのような楽器が正しい音程で演奏されるように、音を微調整 すること。たとえば、ギターの弦を巻いたり緩めたりして音程を合わせること。 実際の応用例 ゲームや音楽制作で音の高さを変える際にピッチシフトを使用。 ライブ演奏や録音で楽器が他の楽器と調和するようにチューニングを行う。 Librosa を用いてピッチとチューニングを行う具体例:

import librosa

# 音声ファイルを読み込む

y, sr = librosa.load('audio_file.wav')

# ピッチをシフトする(2半音上げる)

y_shifted = librosa.effects.pitch_shift(y, sr, n_steps=2)

# ピッチの推定

pitches, magnitudes = librosa.piptrack(y=y, sr=sr)

# 基本周波数の抽出(最も大きいマグニチュードのピッチを選択)

pitch = pitches[magnitudes.argmax()]

print(f"推定ピッチの周波数: {pitch} Hz")

このコードでは、Librosaを使用して音声ファイルのピッチを2半音上げ、またピッチ推定を

行ってその基本周波数を求める。

音声合成

定義や意味

音声合成は、テキストやその他のデータから人工的に音声を生成する技術を指す。こ

れは、音声を自動的に生成するためのプロセスであり、テキスト読み上げ(TTS:

Text-to-Speech)、音声アシスタント、ゲームキャラクターの声など、さまざまな応

用がある。

数学的には、音声波形を生成するためにデジタル信号処理(DSP)を用いる。音声は

通常、時間領域で表現される波形であり、これをデジタル的に表現するために、離散

時間信号としてサンプリングされる。音声波形 s(t) は以下のように表されることが

ある:

s(t) = A sin(2πf t + ϕ)

ここで、A は振幅、f は周波数、ϕ は位相である。

嚙み砕いた説明 音声合成は、機械が人間のように話すことを可能にする技術。テキストを入力する と、それに対応した音声が出力される。例えば、ナビゲーションシステムで目的地を 案内する声や、スマートフォンの音声アシスタントがこれにあたる。 音声合成の基本的な考え方は、音をデジタル的に生成することである。音は空気の振 動として伝わる波であり、これをデジタルデータとして表現し、それをスピーカーを 通して再生することで音声として聞くことができる。 実際の応用例 音声合成は、ゲームでのキャラクターボイス、ナビゲーションシステム、視覚障害者 向けの読書支援ツール、言語学習アプリなど、多岐にわたる応用がある。 PythonのライブラリLibrosaを使用して音声の基本的な操作を行うことができる。 Librosaは主に音楽情報解析のためのライブラリだが、音声合成のための前処理や解析 にも使用できる。 以下に、Librosaを用いて音声ファイルをロードし、基本的な音声処理を行う例を示す。 import librosa import numpy as np # 音声ファイルをロード y, sr = librosa.load('example.wav', sr=None) # 音声の波形を表示 import matplotlib.pyplot as plt plt.figure(figsize=(14, 5)) librosa.display.waveshow(y, sr=sr) plt.title('Waveform of the audio') plt.show() # 音声のSTFT(短時間フーリエ変換)を計算 D = librosa.stft(y) S_db = librosa.amplitude_to_db(np.abs(D), ref=np.max) # スペクトログラムを表示 plt.figure(figsize=(14, 5)) librosa.display.specshow(S_db, sr=sr, x_axis='time', y_axis='log') plt.colorbar(format='%+2.0f dB') plt.title('Spectrogram of the audio') plt.show()

このコードスニペットは、音声ファイルを読み込み、その波形とスペクトログラムを 表示する。Librosaを用いることで、音声データを簡単に解析し、視覚化することが可 能。 音声合成の前処理や解析において、音声の特徴を視覚化することは、音響特性を理解 するために非常に有用である。 Effects and Filters 定義や意味 エフェクト(Effects)とは、オーディオ信号に対して特定の処理を施し、その音質や 音響特性を変更するための技術を指す。一般的なエフェクトには、リバーブ、ディレ イ、ディストーション、コーラスなどが含まれる。 フィルター(Filters)は、オーディオ信号の特定の周波数成分を強調または除去する ためのプロセスであり、ローパスフィルター、ハイパスフィルター、バンドパスフィ ルター、ノッチフィルターなどがある。 数学的には、フィルターは伝達関数 H(f ) を用いて記述され、信号の周波数成分を変 化させる。たとえば、ローパスフィルターは高周波成分を抑えるため、H(f ) が低周 波で1、高周波で0に近づくように設計される。 嚙み砕いた説明 エフェクトは音楽やゲームのサウンドを豊かにするためのツール。たとえば、リバー ブを加えると音がホールで鳴っているように聞こえる。 フィルターは音の特定の部分を強調したり、取り除いたりする。たとえば、ハイパス フィルターを使って低い音をカットすると、音が軽くてクリアになる。 実際の応用例 Librosaライブラリを用いてオーディオ信号にエフェクトやフィルターを適用する例を 示す。LibrosaはPythonでのオーディオ解析と処理のためのライブラリである。

import librosa import numpy as np import soundfile as sf # オーディオファイルを読み込む audio_file = 'example.wav' y, sr = librosa.load(audio_file, sr=None) # フィルターを適用する例:ハイパスフィルター # Librosa自体には直接のフィルタリング機能がないため、SciPyを用いる from scipy.signal import butter, lfilter # ハイパスフィルターの設計 def butter_highpass(cutoff, fs, order=5): nyq = 0.5 * fs normal_cutoff = cutoff / nyq b, a = butter(order, normal_cutoff, btype='high', analog=False) return b, a def highpass_filter(data, cutoff, fs, order=5): b, a = butter_highpass(cutoff, fs, order=order) y = lfilter(b, a, data) return y # 1000Hz以上の周波数を通すハイパスフィルターを適用 cutoff_frequency = 1000.0 filtered_audio = highpass_filter(y, cutoff_frequency, sr) # フィルター後のオーディオを保存 sf.write('filtered_example.wav', filtered_audio, sr) このコードでは、Librosaを用いてオーディオファイルを読み込み、SciPyを用いてハ イパスフィルターを適用している。これにより、低周波のノイズを除去し、クリアな 音質を得ることができる。 ゲーム制作において、エフェクトやフィルターはキャラクターの声や環境音をリアル にするために使われることが多い。たとえば、洞窟の中での声にリバーブをかけてリ アリティを増すなど。

Waveform 定義や意味 Waveformは、音波や信号の時間領域での表現を指す。これは通常、時間を横軸に、 振幅を縦軸にしたグラフとして視覚化される。 音響信号はデジタル化されると、サンプリングレートによって一定間隔で振幅が記録 され、これがWaveformとして表現される。 数学的には、Waveformは信号 x(t) を時間 t の関数として表現し、離散化されたデー タポイント x[n] で表される。 例えば、サイン波のWaveformは以下のように表される: x(t) = A sin(2πf t + ϕ) ここで、A は振幅、f は周波数、ϕ は位相。 嚙み砕いた説明 Waveformは、音楽や音声を視覚的に理解するためのツール。例えば、音楽トラック の波形を見れば、どの部分で音が大きくなっているか、小さくなっているかが一目で わかる。 例えば、スピーカーから再生される音がどのように変動するかをグラフとして表すこ とができる。 音声編集ソフトウェアでは、Waveformを見ながら音の編集を行うことが一般的。 実際の応用例 Waveformは音響信号処理やデジタル音楽制作で広く利用されており、音声の分析や 編集、視覚化に使われる。 PythonのLibrosaライブラリを使用してWaveformを操作することができる。Librosaは 音楽とオーディオ分析のためのライブラリで、Waveformの読み込みや再生、可視化 が可能。 以下は、Librosaを使用してオーディオファイルのWaveformを読み込み、プロットする例:

import librosa import librosa.display import matplotlib.pyplot as plt # 音声ファイルの読み込み file_path = 'audio_file.wav' y, sr = librosa.load(file_path, sr=None) # Waveformのプロット plt.figure(figsize=(14, 5)) librosa.display.waveshow(y, sr=sr) plt.title('Waveform of the Audio File') plt.xlabel('Time (seconds)') plt.ylabel('Amplitude') plt.show() このコードスニペットでは、Librosaを使って音声ファイルを読み込み、matplotlibを 使ってWaveformをプロットしている。 waveshow 関数を使用すると、Waveformを簡単 に表示可能。 Sample Rate 定義や意味 サンプルレート(標本化周波数)は、アナログ信号をデジタル信号に変換する際に、 1秒間に何回サンプルを取得するかを示す指標 単位はヘルツ(Hz)で表され、例えばサンプルレートが44,100 Hzであれば、1秒間に 44,100回のサンプルを取得することを意味する ナイキストの定理に基づき、サンプルレートは信号の最大周波数成分の少なくとも2 倍以上でなければならない 具体的には、あるアナログ信号 x(t) をサンプルレート fs でサンプリングする場合、 デジタル信号は x[n] = x(nTs ) で表される。ここで、Ts = f1 はサンプル間隔 s 嚙み砕いた説明 サンプルレートは音をデジタル化するときに「どれくらい細かく音を切り取っている か」を示すもの

例えば、CDの音質は44,100 Hzでサンプリングされており、これは1秒間に44,100回

音をチェックしているということ

高いサンプルレートはより多くの情報を捕らえるが、データ量も増える

実際の応用例

音楽制作では、適切なサンプルレートを選ぶことで、音質を維持しながらファイルサ

イズを最適化することができる

ゲーム開発において、サウンドエフェクトやBGMの品質を設定する際に重要な役割を

果たす

Librosaライブラリを用いて音声ファイルのサンプルレートを取得し、変更することが

できる

以下に、Librosaを用いたサンプルレートの取得と変更の例を示す:

import librosa

# 音声ファイルの読み込みとサンプルレートの取得

file_path = 'example.wav'

y, sr = librosa.load(file_path)

print(f"Original Sample Rate: {sr} Hz")

# サンプルレートを変更して音声をリサンプリング

target_sr = 22050

# 新しいサンプルレート

y_resampled = librosa.resample(y, orig_sr=sr, target_sr=target_sr)

print(f"Resampled to {target_sr} Hz")

このコードでは、Librosaを用いて音声ファイルのサンプルレートを取得し、異なるサンプル

レートでリサンプリングする方法を示している。

Mono/Stereo

定義や意味

音声信号におけるモノラル(Mono)とステレオ(Stereo)の概念

モノラルはシングルチャンネルの音声形式であり、すべての音を一つのチャンネルに

まとめて出力する

ステレオは二つの独立した音声チャンネルを使用し、左右のスピーカーから異なる音 を出力する 音声データでは、モノラルは通常1次元配列で表され、ステレオは2次元配列で表され る(例:左チャンネルと右チャンネル) 嚙み砕いた説明 モノラルは一つのスピーカーを通して音が出るようなイメージ。すべての音が一つに 集約される ステレオは二つのスピーカーを使い、左右から別々の音が出る。これにより音の方向 や空間的な広がりを感じることができる ステレオはコンサートや映画のような音場感を再現するために使われる 実際の応用例 音楽の制作やミキシングで、モノラルとステレオの音声を使い分ける ゲーム制作において、プレイヤーの位置や動きに応じて音の出所を調整するのに役立 つ 以下は、PythonのLibrosaライブラリを用いてモノラル音声をステレオ音声に変換するコード 例 import numpy as np import librosa import soundfile as sf # 音声ファイルを読み込む(モノラル) y_mono, sr = librosa.load('mono_audio.wav', mono=True) # モノラル音声をステレオに変換(左右チャンネルに同じ音を入れる) y_stereo = np.vstack((y_mono, y_mono)) # ステレオ音声として保存 sf.write('stereo_audio.wav', y_stereo.T, sr) # コメント: # - librosa.loadでモノラル音声を読み込む # - np.vstackを使用して二つのチャンネルを作成 # - soundfile.writeでステレオ音声を保存

このコードでは、モノラル音声データを読み込み、左右のチャンネルに同一のデータを適用 してステレオ音声を作成し、ファイルとして保存する。LibrosaとSoundFileを利用すること で、音声データの操作が簡単に行える。 MFCC 定義や意味 MFCC(Mel-Frequency Cepstral Coefficients、メル周波数ケプストラム係数)は、音 声信号の特徴を数値的に表現する方法の一つ。音声認識や音楽情報検索などで広く用 いられる。 音声信号を短時間フーリエ変換(STFT)により振幅スペクトルに変換し、そのスペ クトルをメルスケールに基づいてフィルタバンクで通過させ、対数を取った後に離散 コサイン変換(DCT)を適用することで得られる。 数式で表すと、まず音声信号のフーリエ変換を行い、得られたスペクトルをメルフィ ルタバンクに通す。次に、各フィルタの出力の対数を取る。最後に、これらの対数ス ペクトルをDCTで変換し、ケプストラム係数を得る。 MFCC = DCT (log(S ⋅ M )) ここで S は振幅スペクトル、M はメルフィルタバンク。 嚙み砕いた説明 MFCCは、音声を「耳で聞いた感じ」に近い形で数値化する技術。人間の聴覚に基づ いたメルスケールを使うことで、人の声の特徴を捉えるのに適している。 音声を録音して、その音を細かく分析する。まず、その音を短い時間ごとに区切っ て、各部分の周波数の「強さ」を計算する。その後、人が感じる音の高さの変化に基 づいて、その数値を変換する。最後に、不要な情報を取り除き、特徴的な数字の列と して出力する。 実際の応用例 音声認識システムで、音声をテキストに変換する前処理として使用される。 音楽ジャンル分類や楽曲の類似性計測など、音楽情報検索にも応用される。 PythonライブラリのLibrosaを用いてMFCCを計算するコード例:

import librosa import librosa.display import numpy as np import matplotlib.pyplot as plt # 音声ファイルの読み込み filename = 'audio.wav' y, sr = librosa.load(filename, sr=None) # MFCCの計算 mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13) # MFCCの表示 plt.figure(figsize=(10, 4)) librosa.display.specshow(mfccs, x_axis='time') plt.colorbar() plt.title('MFCC') plt.tight_layout() plt.show() このコードでは、Librosaライブラリを用いて音声ファイルからMFCCを抽出し、その 結果を可視化する。 librosa.feature.mfcc 関数により音声データ y とサンプリングレ ート sr を入力として、13次元のMFCCを計算。 librosa.display.specshow を使い、計 算結果を時間軸に沿って表示。 Chroma Features 定義や意味 Chroma Featuresは、音楽信号処理において音の周波数特性を12のピッチクラス(C, C#, D, ..., B)にマッピングする技術である。これは音楽のメロディックおよびハーモ ニックな特性を捉えるために用いられる。 音楽信号の短時間フーリエ変換(STFT)の結果を基に、各周波数成分を対応するピ ッチクラスに集約することで得られる。 数式で表現すると、各時間フレームtにおけるクロマベクトルct は、次のように定義 される。 ct = [ct (C), ct (C#), … , ct (B)]

ここで、ct (p)は時間フレームtにおけるピッチクラスpの強度である。 嚙み砕いた説明 音楽を聞くとき、私たちは音の高さ(ピッチ)を感じる。Chroma Featuresは音楽を 分析する際に、この音の高さの情報を12の音階(CからBまでの1オクターブ)に落と し込むことで、音楽の和音やメロディの特性を捉える手法である。 例えば、ピアノの鍵盤でいうと、白鍵と黒鍵を合わせた12の音がChromaとして表現 される。 実際の応用例 Chroma Featuresは音楽情報検索、音楽ジャンル分類、コード認識など様々な音楽関 連のタスクで広く利用されている。 Pythonの音楽処理ライブラリであるLibrosaを用いると、音楽信号からChroma Featuresを簡単に抽出することができる。 import librosa import librosa.display import matplotlib.pyplot as plt # 音楽ファイルを読み込む y, sr = librosa.load(librosa.ex('nutcracker')) # Chroma Featuresを計算 chroma = librosa.feature.chroma_stft(y=y, sr=sr) # Chroma Featuresを表示 plt.figure(figsize=(10, 4)) librosa.display.specshow(chroma, x_axis='time', y_axis='chroma', cmap='coolwarm') plt.colorbar() plt.title('Chroma Features') plt.tight_layout() plt.show() 上記のコードスニペットでは、Librosaを用いて音楽ファイルからChroma Featuresを 抽出し、Matplotlibを用いて視覚化している。Chroma Featuresの視覚化により、時間 経過に伴う音楽のピッチクラスの変化を確認できる。

Spectral Contrast 定義や意味 Spectral Contrastは、音声信号のスペクトルにおいて、ピークとトラフの差を測定す る特徴量 音声の質感や音色を特徴づけるために使用され、特に楽器の分類や音楽ジャンルの分 析において重要 数式として、スペクトルコントラストは以下のように定義される。各周波数帯域での 最大値(ピーク)と最小値(トラフ)の対数差を計算することで求める Ck = log10 ( Epeak,k + ϵ ) Evalley,k + ϵ ここで、Epeak,k はk 番目の周波数帯域におけるピークエネルギー、Evalley,k はトラフエネル ギー、ϵはゼロ除算を防ぐための小さな値 嚙み砕いた説明 Spectral Contrastは、音の強弱のコントラストを周波数ごとに測る方法 音声信号をスペクトログラムに変換し、各周波数帯域での強い音(ピーク)と弱い音 (トラフ)の差を計算 これにより、音がどのように変化しているかを詳細に理解することができ、例えば、 音楽では異なる楽器や音楽ジャンルの違いを捉えるのに役立つ 実際の応用例 音声認識や音楽情報検索システムでの特徴抽出 楽器の分類や音楽ジャンルの分類において、音の質感や音色を分析するために使用 Librosaライブラリを用いてSpectral Contrastを計算する例

import librosa import librosa.display import matplotlib.pyplot as plt # 音声ファイルを読み込む y, sr = librosa.load(librosa.example('trumpet')) # スペクトルコントラストを計算 spectral_contrast = librosa.feature.spectral_contrast(y=y, sr=sr) # スペクトルコントラストをプロット plt.figure(figsize=(10, 4)) librosa.display.specshow(spectral_contrast, x_axis='time', sr=sr) plt.colorbar(label='Spectral Contrast (dB)') plt.title('Spectral Contrast') plt.tight_layout() plt.show() このコードでは、Librosaを使って音声信号を読み込み、スペクトルコントラストを計算し、 結果を視覚化している。音声信号のピークとトラフの差を時間軸に沿ってプロットすること で、音の質感や音色の変化を視覚的に確認することができる。 STFT(短時間フーリエ変換) 定義や意味 短時間フーリエ変換(Short-Time Fourier Transform, STFT)は、信号を時間と周波数 の両方に依存する形で表現するための変換手法 STFTは信号を一定の長さのウィンドウに分割し、それぞれのウィンドウに対してフ ーリエ変換を適用することで、時間変化する周波数成分を解析する 数式での定義は以下の通り: X(t, ω) = ∫ ∞ x(τ )w(τ − t)e−jωτ dτ −∞ ここで、x(τ )は入力信号、w(τ − t)はウィンドウ関数、e−jωτ は複素指数関数

嚙み砕いた説明 STFTは、音楽や音声のような時間とともに変化する信号を分析するための手法 信号を小さな部分に分けて、それぞれの部分でどの周波数成分が強いかを調べる 例えば、音楽の中でどのタイミングでどの楽器がどんな音を出しているかを解析する ことができる 実際の応用例 STFTは音声処理、音楽情報検索、音響解析などで幅広く利用される PythonのライブラリであるLibrosaを使ってSTFTを応用する具体例を以下に示す import librosa import numpy as np import matplotlib.pyplot as plt # 音声ファイルを読み込む y, sr = librosa.load(librosa.example('trumpet')) # STFTを計算 D = librosa.stft(y) # 振幅スペクトルを取得 S_db = librosa.amplitude_to_db(np.abs(D), ref=np.max) # STFTの結果をプロットする plt.figure(figsize=(10, 6)) librosa.display.specshow(S_db, sr=sr, x_axis='time', y_axis='log') plt.colorbar(format='%+2.0f dB') plt.title('STFT Magnitude') plt.show() このコードはLibrosaを使用して音声ファイルのSTFTを計算し、その結果をスペクト ログラムとして表示 librosa.stft 関数によって入力信号の短時間フーリエ変換を実行 し、 librosa.display.specshow で結果を視覚化 この例により、時間と周波数の関係を視覚的に理解可能となる

Griffin-Lim Algorithm 定義や意味 Griffin-Lim Algorithm(グリフィン・リムアルゴリズム)は、位相情報を持たない振幅 スペクトログラムから時間領域の信号を再構成するための反復アルゴリズム このアルゴリズムは、振幅スペクトログラムと一致する信号を生成することを目的と し、特に音声処理や音楽信号処理において用いられる 位相を持たない振幅スペクトログラム ∣S∣ から信号 x(t) を再構成する際に、まず初 期位相 θ0 を仮定し、逆フーリエ変換を用いて時間信号を生成し、その時間信号から 新しいスペクトログラムを計算し、元の振幅スペクトログラムに一致するように位相 を更新するというプロセスを繰り返す 各ステップでの位相更新は以下のように行われる Sk+1 = ∣S∣ ⋅ Xk ∣Xk ∣ ここで Xk は k 番目の反復で得られるスペクトログラムである 嚙み砕いた説明 Griffin-Lim Algorithmは、音声や音楽の波形データを失ったときに、その波形を復元す るための手法 通常、音声は周波数成分と位相成分から成るが、位相が失われた状態(振幅スペクト ログラム)のみで、元の音声に近い波形を作り出す 具体的には、初めに適当な位相を仮定して音声信号を生成し、その信号から得られる スペクトログラムの位相を元に次の信号を生成し、これを繰り返して精度を高める 実際の応用例 Griffin-Lim Algorithmは音声合成や音声解析の分野でよく使われる。例えば、音声認識 システムや音声エフェクトの生成、音楽制作の場面で利用される Pythonの音声処理ライブラリLibrosaを使用してGriffin-Lim Algorithmを実装する例

import numpy as np import librosa # 音声ファイルの読み込み y, sr = librosa.load('audio.wav') # スペクトログラムの計算 D = np.abs(librosa.stft(y)) # Griffin-Lim Algorithm を使用して時間信号を再構成 reconstructed_y = librosa.griffinlim(D) # 再構成された音声信号を保存 librosa.output.write_wav('reconstructed_audio.wav', reconstructed_y, sr) このコードでは、Librosaを用いて音声ファイルを読み込み、短時間フーリエ変換 (STFT)を用いてスペクトログラムを計算し、Griffin-Lim Algorithmで波形を再構成 している librosa.griffinlim 関数がGriffin-Lim Algorithmを実行する役割を果たしており、振幅 スペクトログラムから時間信号を生成する Pitch Tracking 定義や意味 ピッチトラッキングとは、時間に応じた音の基本周波数(ピッチ)を特定するプロセ スを指す。音声信号の解析において、音楽や音声の高さを検出するために用いられ る。 ピッチは通常、ヘルツ (Hz) で表され、音声信号の周期成分に基づいて計算される。 数式的には、信号の基本周波数 f0 を見つけることがピッチトラッキングの目標とな る。これを求めるために、音声信号 s(t) の周期を検出する手法が用いられる。 嚙み砕いた説明 ピッチトラッキングは、音楽や音声の中で「どの高さの音が出ているか」を検出する 技術。たとえば、ピアノの音を録音した際に、その音がA4(440Hz)かC5(523.25Hz)か を特定すること。

音声信号は複雑な波形で表されるが、その波形の中で最も繰り返しの短い周期を見つ

け出し、その逆数をとることで基本周波数(ピッチ)を特定する。

実際の応用例

ピッチトラッキングは音楽制作ソフトウェアやカラオケマシンで使われ、音楽のキー

を変更したり、音声のメロディを解析したりする際に活用される。

PythonライブラリのLibrosaを用いてピッチトラッキングを実装する例を以下に示

す。

import librosa

import numpy as np

# 音声ファイルの読み込み

filename = 'audio_file.wav'

y, sr = librosa.load(filename)

# ピッチトラッキング

# librosa.pyinを用いてピッチを抽出

fmin = librosa.note_to_hz('C2') # 最小周波数

fmax = librosa.note_to_hz('C7') # 最大周波数

pitches, magnitudes = librosa.core.piptrack(y=y, sr=sr, fmin=fmin, fmax=fmax)

# ピッチ抽出のサンプル

times = librosa.frames_to_time(np.arange(pitches.shape[1]), sr=sr)

pitch_values = []

for t in range(pitches.shape[1]):

index = magnitudes[:, t].argmax()

pitch = pitches[index, t]

if pitch > 0:

# ピッチが検出された場合

pitch_values.append((times[t], pitch))

print("Detected pitches (time, frequency):")

for time, pitch in pitch_values:

print(f"Time: {time:.2f}s, Pitch: {pitch:.2f}Hz")

上記のコードでは、Librosaの piptrack 関数を用いて音声信号内のピッチを検出して

いる。 fmin と fmax はピッチ検出の対象となる周波数範囲を指定している。

Harmonic Analysis 定義や意味 調和解析(Harmonic Analysis)は、信号や関数を基本的な波形、特に三角関数によっ て表現し、解析する数学の分野 調和解析は、フーリエ変換などの手法を用いて、周期的な信号や関数をそれぞれの周 波数成分に分解することができる この解析により、信号の周波数特性や周期性を理解することが可能になる フーリエ変換の一般的な形式は次の通り F (ω) = ∫ ∞ f (t)e−iωt dt −∞ ここで、F (ω)は周波数領域での関数、f (t)は時間領域での関数、ω は角周波数、iは 虚数単位 嚙み砕いた説明 調和解析は、音楽や信号処理において、複雑な音や信号を単純な波の組み合わせに分 解する技術 これにより、音楽の音色やノイズのパターンを分析・理解することができる 例えば、楽器の音を録音し、その音がどのような周波数成分から構成されているかを 調べることができる 実際の応用例 音声信号処理において、楽曲のメロディや和音を解析するために用いられる ゲーム制作において、リアルタイムでの音響効果の解析や生成に役立てることが可能 PythonライブラリのLibrosaを使用して、音楽信号を読み込んでその周波数成分を解 析するコード例を示す

import librosa import numpy as np import matplotlib.pyplot as plt # 音声ファイルを読み込む filename = 'audio_file.wav' y, sr = librosa.load(filename) # 短時間フーリエ変換を適用してスペクトログラムを取得 D = librosa.stft(y) # 周波数軸に対する平均を取り、調和成分を抽出 harmonic = np.mean(np.abs(D), axis=1) # 調和成分をプロット plt.figure(figsize=(10, 4)) plt.plot(harmonic) plt.title('Harmonic Analysis') plt.xlabel('Frequency Bin') plt.ylabel('Magnitude') plt.grid(True) plt.show() 上記のコードでは、音声ファイルを読み込み、短時間フーリエ変換を使ってそのスペ クトルを解析 結果として、調和成分のスペクトルを視覚化し、どの周波数成分が強いかを示す Librosaライブラリを利用することで、音声信号の調和解析を効率的に行うことができ る Inverse STFT 定義や意味 Inverse Short-Time Fourier Transform (逆短時間フーリエ変換)は、時間-周波数領域に 変換された信号を元の時間領域の信号に戻す処理 具体的には、STFTによって得られた複素数の行列から時間領域の信号に再構成する 手法 数学的には、STFTで得られた複素スペクトル X[n, k] から時間領域の信号 x[n] を 再構成する

各フレームごとに逆フーリエ変換を行い、オーバーラップ加算法を使って元の信号を 再構成する N −1 x[n] = ∑ ∑ X[m, k]ej2πkn/N ⋅ w[n − mH] m k=0 ここで、w[n] はウィンドウ関数、H はホップサイズ、N はフーリエ変換のサイズを示す 嚙み砕いた説明 Inverse STFTは、音声や音楽のデータを分析後に元に戻すための変換 STFTでは音の信号を時間と周波数で分析するが、逆変換ではその分析結果を使って 元の音を再現する 音声信号を加工したり、ノイズを除去した後に元の形にする際に使われる 実際の応用例 音声信号処理において、ノイズを除去したり、エコーを除去した後に元の音声を再構 成する 音楽の音質を改善したり、音声エフェクトを追加する際に使用される 以下にPythonのライブラリLibrosaを用いて、逆STFTを行う例を示す: import librosa import numpy as np # 音声ファイルの読み込み y, sr = librosa.load('audio_file.wav') # STFTの計算 D = librosa.stft(y) # 何らかの処理をSTFTに対して行う(例:振幅を減少させる) D_processed = D * 0.5 # Inverse STFTを用いて元の時間領域に戻す y_inverse = librosa.istft(D_processed) # 結果の信号を保存する librosa.output.write_wav('processed_audio.wav', y_inverse, sr)

このコードでは、Librosaを使って音声ファイルを読み込み、STFTを計算し、処理を行って から逆STFTを使って時間領域の信号に戻している。音声信号の振幅を半分にする簡単な処理 を例として示している。 Griffin-Lim Synthesis 定義や意味 Griffin-Lim Synthesisは、与えられた振幅スペクトログラムから位相を推定し、音声信 号を再合成する手法である。この手法は、特に音声信号処理において、スペクトログ ラムから音声を生成する際に用いられる。位相が欠落しているスペクトログラムに対 して、反復的に位相を補完し、時間領域の信号を得るために使用される。 Griffin-Limアルゴリズムは以下の手順で進行する: i. 初期位相をランダムに設定またはゼロに設定する。 ii. 逆フーリエ変換を用いて時間領域信号を得る。 iii. 得られた信号から再び短時間フーリエ変換(STFT)を行い、振幅を元のスペク トログラムの振幅に置き換える。 iv. 2と3を所定の回数または収束するまで繰り返す。 嚙み砕いた説明 Griffin-Lim Synthesisは、「音の影」を与えられたときに、その音を再構築しようとす る方法。具体的には、音の強さ(振幅)はわかっているけど、音の形(位相)がわか らないときに、その形を推測して実際の音を再現する技術。何度も試行錯誤しなが ら、少しずつ正しい音に近づけていく。 例えば、楽譜だけを見て、どんな音楽が流れるのかを想像して演奏を試みるようなプ ロセスに似ている。 実際の応用例 Griffin-Limアルゴリズムは、テキスト読み上げシステムや音声合成システムなどで、 生成されたスペクトログラムから実際の音声信号を再構成するために使用される。 以下は、Pythonの音声処理ライブラリであるLibrosaを用いてGriffin-Lim Synthesisを実装する 例である。

import librosa import librosa.display import numpy as np import matplotlib.pyplot as plt # 音声ファイルを読み込む y, sr = librosa.load(librosa.example('trumpet')) # 音声信号をスペクトログラムに変換 D = librosa.stft(y) # スペクトログラムの振幅を取得 amplitude = np.abs(D) # Griffin-Limアルゴリズムを用いて音声信号を再構成 y_reconstructed = librosa.griffinlim(amplitude) # 再構成された音声信号をプロット plt.figure() librosa.display.waveshow(y_reconstructed, sr=sr) plt.title('Reconstructed Audio Signal') plt.show() このコードは、Librosaの griffinlim 関数を用いて、与えられた振幅スペクトログラムから音 声信号を再構成するプロセスを示している。まず、音声ファイルを読み込み、そのスペクト ログラムを計算し、振幅を取得する。次に、Griffin-Limアルゴリズムを適用して、音声信号を 再構成し、その結果をプロットする。 Time Stretching 定義や意味 Time Stretchingは音声信号処理における技術の一つで、音声のピッチを変えずにその 長さ(再生時間)を変更する手法を指す。音楽制作や音声編集において、テンポを変 えたいがピッチはそのままにしたいという場合に活用される。 数学的には、時間領域の信号を時間的に拡張または縮小することを意味する。具体的 には、音声信号をフーリエ変換して周波数領域に変換し、そこから位相情報を操作し て時間スケールを変更する。

例えば、信号 x(t) を時間スケール α でストレッチする場合、新しい信号 x′ (αt) を 生成する。 嚙み砕いた説明 Time Stretchingは、音楽のテンポを変えたいけれど、歌の高さや楽器の音程はそのま まにしておきたいというときに使う技術。たとえば、曲を速くしたいけど声の高さは 変えたくない、というときに使える。 このプロセスは、音声信号を小さな部分に分けて、それぞれの部分を時間的に引き延 ばしたり縮めたりして、つなぎ合わせることで行う。 実際の応用例 音楽制作ソフトでのテンポ変更 映画やテレビの音声編集において、異なる長さの映像に合わせて音声を調整する場合 ゲームにおいて、シーンのテンポに合わせてBGMを調整する場合 以下はPythonの音声ライブラリLibrosaを用いたTime Stretchingの実装例。 import librosa # 音声ファイルの読み込み y, sr = librosa.load('audio_file.wav') # Time Stretchingの実施(例えば、テンポを1.5倍に) y_stretched = librosa.effects.time_stretch(y, rate=1.5) # ストレッチ後の音声を保存または処理 librosa.output.write_wav('stretched_audio_file.wav', y_stretched, sr) このコードスニペットでは、Librosaを用いて音声ファイルを読み込み、 time_stretch 関数を 使ってそのテンポを1.5倍に引き伸ばしている。 rate パラメータはストレッチの倍率を指定 し、 1.5 は元の長さの1.5倍の時間で再生されることを意味する。

Pitch Shifting 定義や意味 ピッチシフティングとは、オーディオ信号の音高(ピッチ)を変える処理のこと。音 楽制作やサウンドデザインにおいて、音の高さを変更するために用いられる。音高の 変更は、信号の周波数を変化させることによって実現される。 ピッチシフトは音の持続時間を変えずに音高を変えることができるため、元のテンポ を保ったまま音の高さを調整することが可能。 数式的には、信号の周波数 f を k 倍することで、新しい音高 f ′ = k ⋅ f を得る。 嚙み砕いた説明 ピッチシフティングは、音声や音楽の録音の高さを上げたり下げたりする技術。例え ば、ギターの音を録音した際に、その音を別のキーに合わせるためにピッチシフトを 使うことができる。音の速さはそのままに、高さだけを変えることができるのが特 徴。 イメージとしては、録音した声を再生するときに、声を高くしたり低くしたりするこ とができるフィルターのようなものである。 実際の応用例 ピッチシフティングは音楽制作やゲーム開発において広く使われる。例えば、ゲーム 内のキャラクターの声を変更したり、音楽トラックを他のキーに合わせたりする際に 利用される。 PythonのLibrosaライブラリを使ってオーディオのピッチをシフトする例を以下に示 す。

import librosa import soundfile as sf # 音声ファイルを読み込む file_path = 'input_audio.wav' y, sr = librosa.load(file_path) # ピッチを2半音上げる n_steps = 2 y_shifted = librosa.effects.pitch_shift(y, sr, n_steps=n_steps) # ピッチシフトした音声を保存する output_path = 'output_audio.wav' sf.write(output_path, y_shifted, sr) # コメント: # このコードはLibrosaを使用して音声ファイルを読み込み、ピッチを2半音上げた後、新しいファイルとし 上記のコードスニペットでは、Librosaの effects.pitch_shift 関数を使用して、音声 のピッチを変更している。 n_steps の値を調整することで、ピッチのシフト量を制御 できる。 Mel Spectrogram 定義や意味 Mel Spectrogramは、音声信号を時間と周波数の二次元表現に変換したもので、特に 人間の聴覚に基づいた周波数軸であるMel尺度に基づいている Mel尺度では、人間の聴覚の感度に基づいて周波数を対数的に変換するため、低周波 数領域を詳細に、高周波数領域を粗く表現する 音声信号を短時間フーリエ変換(STFT)を用いて周波数領域に変換し、その後、周 波数軸をMel尺度に再マッピングして得られる 数式としては、線形周波数 f を Mel 周波数 m(f ) に変換する公式は次の通り: m(f ) = 2595 ⋅ log10 (1 + f ) 700

嚙み砕いた説明 音声データを視覚的に表現する方法の一つで、人間の耳がどのように音を感知するか をシミュレートしたもの 普通のスペクトログラムと異なり、低音部分を細かく、高音部分をざっくりと表現す る これにより、人間が聞き取りやすい音の特徴を強調し、ノイズを減らすことができる 実際の応用例 音声認識システムや音楽ジャンル分類、楽器認識などの音声処理タスクで広く使用さ れる 特に機械学習モデルの入力として利用され、音声データの特徴抽出に役立つ 以下にPythonのライブラリLibrosaを用いてMel Spectrogramを生成するコードスニペットを 示す: import librosa import librosa.display import matplotlib.pyplot as plt # 音声ファイルを読み込む y, sr = librosa.load(librosa.example('trumpet')) # Mel Spectrogramを計算 S = librosa.feature.melspectrogram(y=y, sr=sr, n_mels=128, fmax=8000) # 振幅をdBに変換 S_dB = librosa.power_to_db(S, ref=np.max) # Mel Spectrogramをプロット plt.figure(figsize=(10, 4)) librosa.display.specshow(S_dB, sr=sr, x_axis='time', y_axis='mel', fmax=8000) plt.colorbar(format='%+2.0f dB') plt.title('Mel Spectrogram') plt.tight_layout() plt.show() このコードは、Librosaの melspectrogram 関数を用いて、音声信号をMel Spectrogram に変換する librosa.display.specshow を用いて、計算されたMel Spectrogramを可視化

power_to_db 関数で振幅をデシベルスケールに変換し、可視化しやすくしている Constant-Q Transform 定義や意味 Constant-Q Transform (CQT) は、音声信号や音楽信号の解析において用いられる時間 周波数解析手法の一つ。短時間フーリエ変換 (STFT) と類似しているが、周波数分解 能が可変であり、音楽的な音程(ピッチ)に基づいて設計されている。 CQT の各バンドの中心周波数が等比数列で分布しており、隣接するバンド間の周波数 比が一定(これは音楽の音階に対応)である特徴を持つ。このため、各バンドの Q 値 (中心周波数をバンド幅で割った値)が一定であることから、Constant-Q Transform と呼ばれる。 CQT の数式表現は次のようになる。入力信号を x(t)、中心周波数を fk とすると、k 番目の CQT は次式で表される: N −1 X(k) = ∑ x(n) ⋅ w(n, k) ⋅ e−j2πfk n n=0 ここで、w(n, k) は k 番目の周波数成分に対応する窓関数。 嚙み砕いた説明 Constant-Q Transform とは、音楽や音声信号を解析するための方法の一つ。通常のフ ーリエ変換は一定の周波数間隔で分解するが、CQT は音楽の音程に合わせて周波数の 間隔を調整している。 音楽には「ドレミファソラシド」といった音階があり、これらの音は一定の比率で周 波数が上がる。CQT はこの音階に基づいて、周波数を分解するため、音楽信号の解析 にとても適している。 CQT を使用することで、同じ音階の音を異なる周波数でも同じように解析できる。 実際の応用例 Constant-Q Transform は、音楽情報検索、音楽トラックの解析、楽器認識、音楽のピ ッチ検出などに利用される。 Python ライブラリ Librosa を用いることで、簡単に CQT を計算することができる。 以下に Librosa を用いた CQT の計算例を示す。

import librosa import librosa.display import matplotlib.pyplot as plt import numpy as np # 音声ファイルのロード y, sr = librosa.load(librosa.ex('trumpet')) # CQT の計算 cqt = librosa.cqt(y, sr=sr) # CQT の振幅をデシベルに変換 cqt_db = librosa.amplitude_to_db(np.abs(cqt), ref=np.max) # CQT のプロット plt.figure(figsize=(10, 6)) librosa.display.specshow(cqt_db, sr=sr, x_axis='time', y_axis='cqt_note') plt.colorbar(format='%+2.0f dB') plt.title('Constant-Q Transform') plt.show() このコードでは、Librosa を使って音声ファイルを読み込み、CQT を計算し、その結 果をプロットしている。CQT を可視化することで、時間とともにどの音程がどのよう に変化しているかを視覚的に確認できる。 Autocorrelation 定義や意味 自己相関(Autocorrelation)とは、信号やデータ系列において、異なる時点間での相 関を測定する手法 数学的には、時系列データの自己相関は次のように定義される N −τ R(τ ) = ∑ xt ⋅ xt+τ t=1 ここで、xt は時系列データの値、N はデータの長さ、τ はラグ(遅延)を示す

嚙み砕いた説明 自己相関は、データの中でどの程度過去のデータが現在のデータに影響を与えている かを示す指標 例えば、音楽信号では、音の繰り返しやパターンを検出するために使われる 自己相関が高い場合、データは過去の値に依存していることを示す 実際の応用例 自己相関は、音楽信号処理でピッチ検出やテンポ解析に使用される Librosaライブラリを用いて音楽データの自己相関を計算することで、音の周期性やパ ターンを分析可能 以下のコードスニペットは、Librosaを使用して音声信号の自己相関を計算する方法を示す import numpy as np import librosa # 音声ファイルを読み込む y, sr = librosa.load(librosa.example('trumpet')) # 自己相関を計算 autocorr = librosa.autocorrelate(y) # 結果を表示 print(autocorr) # 自己相関のプロット import matplotlib.pyplot as plt plt.plot(autocorr) plt.title('Autocorrelation of Trumpet Example') plt.xlabel('Lag') plt.ylabel('Autocorrelation') plt.show() 上記のコードは、Librosaの autocorrelate 関数を使用して音声信号の自己相関を計算 し、matplotlibを用いてプロットを行う このプロットは、信号内の周期性や繰り返しパターンを視覚的に確認するために利用 される

YIN Algorithm 定義や意味 YINアルゴリズムは、フランスの音声・音響研究所(IRCAM)のAlain de Cheveigné とHideki Kawaharaによって2002年に提案された音高推定アルゴリズムである。 このアルゴリズムは、主に音声信号の基本周波数(ピッチ)を高精度で推定すること を目的としている。 YINアルゴリズムは自己相関関数に基づいており、ピッチ推定のために「差分関数」 を計算し、局所的な最小値を探す。 差分関数 d(τ ) は以下のように定義される: N d(τ ) = ∑ (xj − xj+τ ) 2 j=1 ここで、xj は信号サンプル、τ は遅延(ラグ)、N は信号の長さを表す。 嚙み砕いた説明 YINアルゴリズムは、音声や音楽の録音からその音高を検出するための手法。 音高は音の高さを示し、音楽や音声処理において非常に重要な要素。 YINアルゴリズムは、信号の異なる遅延(時間のずれ)を比較し、音の周期性を探る ことで音高を推定する。 簡単に言うと、信号の波形がどのくらいの周期で繰り返されるかを調べる方法。 実際の応用例 音声認識、音楽情報検索、音楽制作ソフトウェアなどで音高の検出に応用される。 Librosaライブラリを用いることでPythonでYINアルゴリズムを簡単に実装できる。 以下はLibrosaを用いたYINアルゴリズムの実装例:

import librosa

# 音声ファイルの読み込み

y, sr = librosa.load('audio_file.wav')

# YINアルゴリズムを用いた基本周波数の推定

f0 = librosa.yin(y, fmin=librosa.note_to_hz('C2'), fmax=librosa.note_to_hz('C7'))

# 結果の表示

print(f"Estimated fundamental frequencies: {f0}")

librosa.yin 関数を使用することで、指定した音声データの基本周波数をYINアルゴ

リズムで推定できる。

fmin と fmax で基本周波数の検索範囲を指定することが可能で、これにより計算の精

度を向上させる。

Overlap Add

定義や意味

Overlap Add法(OLA法)は、信号処理で広く用いられる手法の一つであり、短時間

フーリエ変換(STFT)によって得られた信号のセグメントを時間領域に戻すために

使用される

各セグメントはオーバーラップしており、各部分を加算することで元の信号を再構築

する

数式で表すと、時間領域信号 x[n] をセグメント xk [n] に分解し、各セグメントを重

ね合わせるという操作になる

セグメントは通常、窓関数 w[n] をかけられた後、フーリエ変換され、逆変換の際に

オーバーラップして加算される

数式表現は以下の通りである:

x[n] = ∑ xk [n − Rk]

k

ここで R はオーバーラップのシフトサイズを示す

嚙み砕いた説明 Overlap Add法は、音声や音楽信号の処理でよく使われる手法で、信号を小さな部分 に分けて処理し、それをまた組み合わせて元の信号を再現する方法 簡単に言えば、信号を切り分けてそれぞれの部分を計算し、またそれらを重ねて元に 戻すことで、特定の処理を効率よく行う手法 短い窓で切り取った信号を変換し、加工した後に再度繋ぎ合わせるというプロセスで 成り立つ 実際の応用例 Overlap Add法は、音声信号のノイズ除去や音響効果の付与、音声合成などに利用さ れる Pythonの音声処理ライブラリであるLibrosaを使用して、音声信号に対してSTFTを行 い、逆STFTで再構築する際にOverlap Add法が内部的に用いられている import librosa import numpy as np # 音声ファイルの読み込み filename = 'audio.wav' y, sr = librosa.load(filename, sr=None) # STFTを使用して音声信号を周波数領域に変換 D = librosa.stft(y) # ここで周波数領域での処理が可能 # 例えば、特定の周波数帯域のフィルタリングや効果音の付与など # 逆STFTを使って信号を時間領域に戻す y_reconstructed = librosa.istft(D) # `y` と `y_reconstructed` は音声信号のオリジナルと再構築されたもの # Overlap Add法が内部で用いられている 上記の例では、Librosaを用いて音声信号をSTFTで変換し、逆STFTで再構築する過程 でOverlap Add法が使用されている この方法により、信号を効率的に変換し、加工することが可能となる

Phase Reconstruction 定義や意味 フェーズ再構成(Phase Reconstruction)は、音響信号処理において、特にスペクト ログラムを用いた信号の再合成に関わる重要な技術である 通常、スペクトログラムは振幅(Magnitude)と位相(Phase)の情報を持つが、位 相情報は失われやすい フェーズ再構成では、振幅スペクトログラムから位相を推定し、元の信号を復元する ことを目的とする よく知られた方法としてグリフィン・リムアルゴリズム(Griffin-Lim Algorithm)があ る 嚙み砕いた説明 音楽などの音声データは、通常時間領域の波形として表現される しかし、音声を分析するために周波数領域に変換することが多く、その際に位相情報 が重要になる 位相が正確でないと、音声信号を元の状態に戻すことが難しくなるため、フェーズ再 構成が必要となる 例えば、透明でない音のエコーや雑音を取り除くために、この技術が使われる 実際の応用例 音声信号の編集や合成、ノイズリダクション、エフェクト処理などに応用される 特に、音楽のピッチ変更やタイムスケーリングといった処理を行う際に重要となる PythonのLibrosaライブラリを用いた具体例を示す

import librosa import numpy as np import librosa.display import matplotlib.pyplot as plt # 音声ファイルの読み込み y, sr = librosa.load(librosa.example('trumpet')) # 短時間フーリエ変換(STFT)を計算 D = librosa.stft(y) # 振幅スペクトログラムを取得 magnitude = np.abs(D) # 位相再構成を行う # Griffin-Lim Algorithmを利用して、位相を推定し音声信号を再合成 y_reconstructed = librosa.griffinlim(magnitude) # 元の信号と再構成された信号をプロットして比較 plt.figure(figsize=(10, 5)) plt.subplot(1, 2, 1) librosa.display.waveshow(y, sr=sr) plt.title('Original Signal') plt.subplot(1, 2, 2) librosa.display.waveshow(y_reconstructed, sr=sr) plt.title('Reconstructed Signal') plt.tight_layout() plt.show() このコードでは、Librosaを用いて音声信号をSTFTにより周波数領域に変換し、振幅 スペクトルのみからグリフィン・リムアルゴリズムを用いて位相を再推定し、信号を 再構成している 再構成された信号が元の信号とどの程度似ているかを視覚的に確認することができる