ML_scikit-learn

185 Views

November 28, 24

スライド概要

医学生。AIや業務・学習効率化に興味あり。

関連スライド

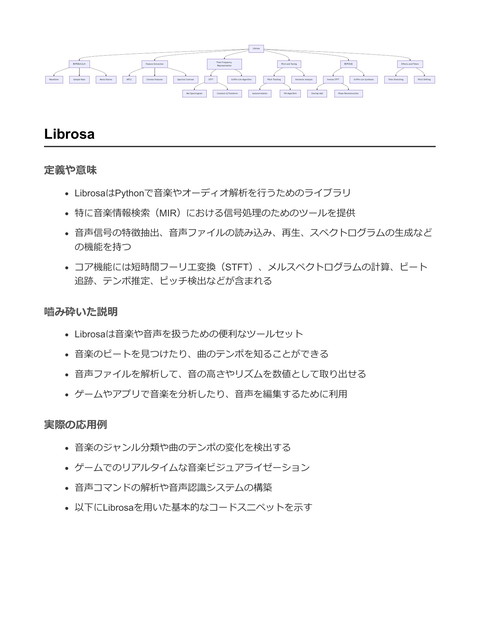

SP_Librosa

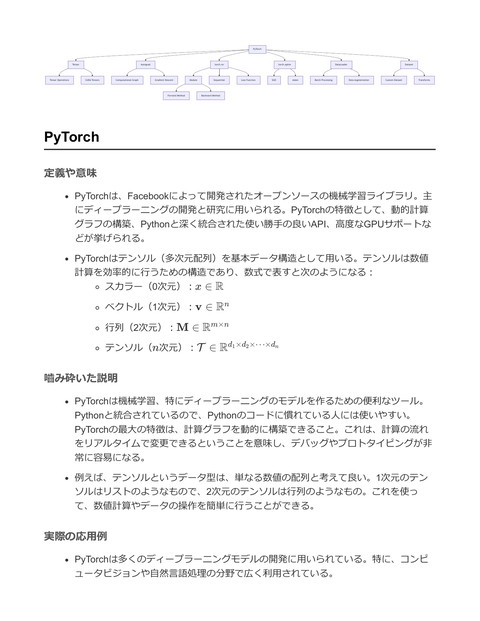

DL_PyTorch

各ページのテキスト

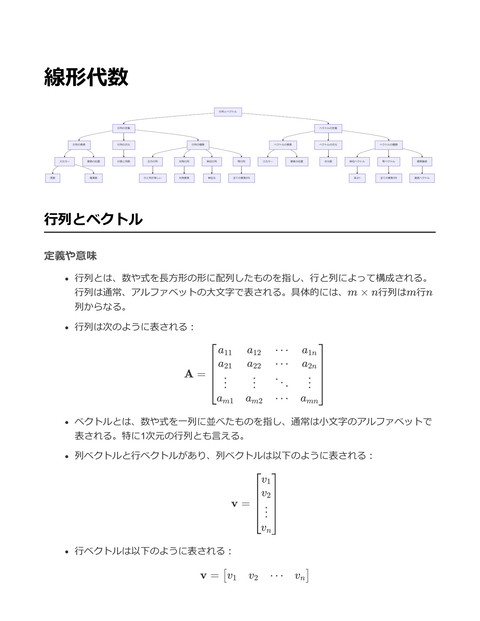

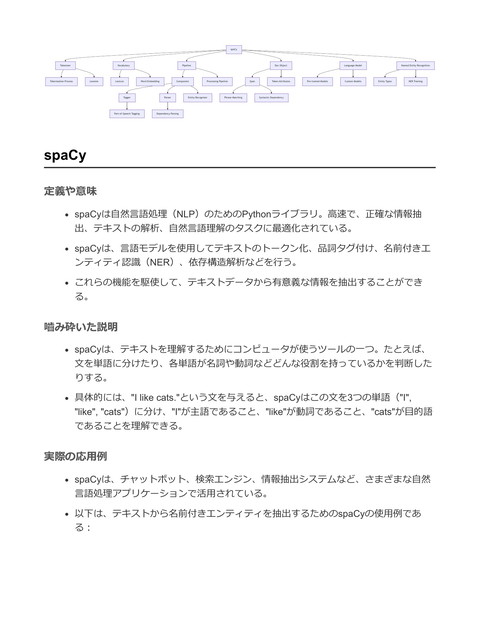

scikit-learn データ前処理 標準化 正規化 欠損値処理 教師あり学習 カテゴリ変数のエンコーデ ィング 回帰 線形回帰 分類 決定木回帰 ロジスティック回帰 教師なし学習 クロスバリデーション サポートベクターマシン モデル選択と評価 クラスタリング K-Means 階層型クラスタリング 次元削減 主成分分析 GridSearchCV RandomizedSearchCV パイプライン 交差検証 評価指標 Pipeline FeatureUnion 特異値分解 scikit-learn 定義や意味 scikit-learnは、Pythonプログラミング言語用のオープンソースの機械学習ライブラ リ。分類、回帰、クラスタリング、次元削減など、さまざまなタイプの機械学習アル ゴリズムを提供 SciPy(Scientific Python)エコシステムの一部であり、NumPy、SciPy、matplotlib、 pandasなどのライブラリと統合することで、データ分析と機械学習モデルの開発を容 易にする 例えば、線形回帰モデルは、与えられたデータセットに対して直線を適合させ、デー タの傾向を予測するために使用 嚙み砕いた説明 scikit-learnは、データを使ってコンピュータに学習させるための便利なツールセッ ト。例えば、過去のデータを分析して未来の傾向を予測したり、データをグループに 分けたりすることができる 機械学習の初心者でも、簡単に使い始められるように設計されており、様々なデータ 処理やアルゴリズムが利用可能 例えば、手書き数字の画像を数字に分類するためのモデルを作りたいとき、scikitlearnを利用することで、複雑な数式やアルゴリズムを手作業で実装する必要がない 実際の応用例 データの前処理、モデルの訓練、予測、評価に使用される。特に機械学習を用いたデ ータ分析や予測モデルの構築に応用 例えば、以下のコードスニペットは、scikit-learnを使った線形回帰モデルの例

from sklearn.model_selection import train_test_split from sklearn.linear_model import LinearRegression from sklearn.metrics import mean_squared_error import numpy as np # サンプルデータを生成 X, y = np.arange(10).reshape((5, 2)), range(5) # データを訓練セットとテストセットに分割 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42 # 線形回帰モデルを作成 model = LinearRegression() # モデルを訓練 model.fit(X_train, y_train) # テストデータを用いて予測 y_pred = model.predict(X_test) # モデルの評価 mse = mean_squared_error(y_test, y_pred) print(f"Mean Squared Error: {mse}") このコードでは、まずデータを訓練データとテストデータに分け、線形回帰モデルを 訓練。テストデータに対する予測結果を評価し、平均二乗誤差(MSE)を出力 こうしたモデルは、例えば家の価格を予測したり、株価の動向を予測するのに使われ ることがある データ前処理 定義や意味 データ前処理とは、機械学習モデルを訓練する前に、生データを適切な形式に変換 し、データの質を向上させるための一連のプロセスを指す。これには、データのクリ ーニング、正規化、標準化、欠損値の処理、特徴抽出、エンコーディングなどが含ま れる。 数式的には、データ前処理は入力データ X を変換関数 f によって適切な形式 X ′ に 変換する操作として表される。すなわち、

X ′ = f (X) ここで、f はデータの特性に応じた前処理手法を表す。 嚙み砕いた説明 データ前処理は、データセットを「掃除」して使いやすくすること。生データには欠 損値や異常値が含まれていることが多く、そのまま使用すると機械学習モデルの性能 が低下する可能性がある。データを均一なスケールにすることで、モデルの学習プロ セスを改善し、予測の精度を向上させる。 例えば、異なる単位で測定された特徴を持つデータセットがある場合、そのままでは 一部の特徴がモデルに過剰に影響を与えてしまう。これを防ぐために、各特徴を標準 化(平均0、分散1に変換)する。 実際の応用例 データ前処理は、特に機械学習パイプラインの初期段階で不可欠であり、モデルの精 度と信頼性を向上させる。以下は、scikit-learnを用いたデータ前処理の具体例。 from sklearn.preprocessing import StandardScaler from sklearn.impute import SimpleImputer from sklearn.pipeline import Pipeline from sklearn.datasets import load_iris # データセットの読み込み data = load_iris() X = data.data # 欠損値の補完と標準化のパイプラインを作成 pipeline = Pipeline([ ('imputer', SimpleImputer(strategy='mean')), ('scaler', StandardScaler()) # データを標準化 ]) # データに前処理を適用 X_processed = pipeline.fit_transform(X) # 前処理されたデータを表示 print(X_processed[:5]) # 最初の5サンプルを表示 # 欠損値を平均値で補完

上記コードは、Irisデータセットを用いて欠損値を平均で補完し、その後、各特徴を標 準化するプロセスを示している。 Pipeline を使用することで、データ前処理の複数ス テップをまとめて管理でき、再現性のある処理を実現する。 教師あり学習 定義や意味 教師あり学習(Supervised Learning)は、機械学習の一つの手法であり、入力データ とそれに対応する正解ラベルが与えられたデータセットに基づいてモデルを構築する 手法 学習プロセスでは、モデルは与えられた入力データから正解ラベルを予測するための 関数 f : X → Y を学習する 一般的な目的は、未知のデータに対して正確にラベルを予測できるようにすること 数式で表すと、与えられたデータセット {(x1 , y1 ), (x2 , y2 ), … , (xn , yn )} に対し て、モデルは y = f (x) を学習する 嚙み砕いた説明 教師あり学習とは、コンピュータに「これが入力で、これが答えだよ」というペアを たくさん教えて、未知の入力に対しても自動的に答えを出せるようにすること 例えば、メールの自動振り分け機能では、過去に「このメールはスパムだ」「このメ ールはスパムではない」とラベル付けされたデータを基に新しいメールを分類する 実際の応用例 教師あり学習は、画像分類、音声認識、テキスト分類、医療診断など、さまざまな分 野で応用されている scikit-learnを用いた基本的な教師あり学習の例として、線形回帰モデルの構築を示す

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_squared_error

# データセットの準備 (例としてランダムデータ)

import numpy as np

X = np.random.rand(100, 1)

# 100個のサンプル、1つの特徴量

y = 3 * X.squeeze() + 2 + np.random.randn(100) * 0.1

# 直線にノイズを加える

# 訓練データとテストデータに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42

# 線形回帰モデルの適用

model = LinearRegression()

model.fit(X_train, y_train)

# 予測の実行

y_pred = model.predict(X_test)

# モデルの性能評価

mse = mean_squared_error(y_test, y_pred)

print(f'Mean Squared Error: {mse:.2f}')

# 平均二乗誤差を出力

# 結果: 平均二乗誤差は予測の精度を評価する指標の一つ

このコードでは、ランダムに生成したデータに対して線形回帰モデルを訓練し、テス

トデータに対する予測精度を評価している

scikit-learnの LinearRegression クラスを用いて簡単に教師あり学習を実装可能

教師なし学習

定義や意味

教師なし学習とは、ラベル付けされていないデータからパターンや構造を見つけ出す

機械学習の一種。教師なし学習では、学習データにおいて出力に相当する情報がな

く、データの分布や特徴を理解することが目的

主な手法として、クラスタリング、次元削減、密度推定などがある

クラスタリングの例として、データセットをいくつかのクラスタに分けるための手法

であるk-meansアルゴリズムがある

嚙み砕いた説明 教師なし学習は、データに対して「これが答えだ」というラベルを付けずに、そのデ ータの中にあるパターンを見つける手法。例えば、膨大な顧客データから共通の特徴 を持つグループを見つけるなど 人間が「こういうグループがあるかもしれない」と仮説を立てずに、データそのもの に任せて分類や特性の抽出を行う 実際の応用例 教師なし学習は、データのクラスタリングや次元削減に用いられる 例えば、顧客の購買履歴を元に顧客をいくつかのグループに分け、各グループに対し て異なるマーケティング戦略を立てることができる scikit-learnでk-meansによるクラスタリングを行う例を以下に示す from sklearn.cluster import KMeans import numpy as np # サンプルデータ生成 X = np.array([[1, 2], [1, 4], [1, 0], [4, 2], [4, 4], [4, 0]]) # k-meansアルゴリズムの適用 kmeans = KMeans(n_clusters=2, random_state=0).fit(X) # 各データ点のクラスタラベルを出力 print(kmeans.labels_) # 結果: array([0, 0, 0, 1, 1, 1]) # 各クラスタの中心を出力 print(kmeans.cluster_centers_) # 結果: array([[1., 2.], # [4., 2.]]) このコードでは、6つのデータポイントを2つのクラスタに分け、それぞれのクラスタ の中心を計算している 各データポイントがどのクラスタに属するかは kmeans.labels_ で確認でき、クラスタ の中心は kmeans.cluster_centers_ で確認できる

モデル選択と評価 定義や意味 モデル選択とは、与えられたデータセットに対して最適な予測モデルを選定するプロ セスのこと。また、モデル評価は、選択したモデルの性能を定量的に評価する手法を 指す。これらは、機械学習において重要なステップである。 モデルの性能は、通常、データセットをトレーニングセットとテストセットに分割 し、トレーニングセットでモデルを学習させた後、テストセットでその性能を評価す ることで測定する。 モデルの性能評価には様々な指標があり、回帰問題では平均二乗誤差 (MSE) や決定 係数 (R2 )、分類問題では精度、再現率、F1スコアなどが用いられる。 嚙み砕いた説明 モデル選択と評価は、機械学習における「正しい道具」を選び、それが「どれだけう まく働いているか」を確認する過程。例えば、あるゲームのプレイヤーの行動を予測 するために、色々なモデル(道具)を試し、どれが最も正確に予測できるかを評価す る。 モデル選択では、さまざまなアルゴリズム(例えば、線形回帰、決定木、ランダムフ ォレストなど)を試し、最もよく機能するものを選ぶ。 評価は、選んだモデルがどれだけ正確に未来のデータを予測できるかを確認する。例 えば、プレイヤーの勝率を予測するモデルが実際の勝率とどれだけ一致しているかを 確認する。 実際の応用例 ゲーム内でプレイヤーの行動を予測するためのモデル選択と評価の例を示す。ここで は、scikit-learnを用いた簡単な例を示す。

from sklearn.model_selection import train_test_split, cross_val_score

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import accuracy_score

# データセットのロード

iris = load_iris()

X, y = iris.data, iris.target

# データセットをトレーニングセットとテストセットに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42

# モデルの選択(ここではランダムフォレストを使用)

model = RandomForestClassifier()

# モデルのトレーニング

model.fit(X_train, y_train)

# テストセットでの予測

y_pred = model.predict(X_test)

# モデルの評価(精度を使用)

accuracy = accuracy_score(y_test, y_pred)

print(f"Model Accuracy: {accuracy:.2f}")

# クロスバリデーションを用いた評価

cv_scores = cross_val_score(model, X, y, cv=5)

print(f"Cross-Validation Scores: {cv_scores}")

print(f"Mean Cross-Validation Score: {cv_scores.mean():.2f}")

# コメント:

# - データセットをトレーニングセットとテストセットに分割し、ランダムフォレストモデルを選択してト

# - テストセットを用いてモデルの精度を評価

# - クロスバリデーションを用いてモデルの安定性と一般化性能を評価

この例では、Irisデータセットを用いてランダムフォレスト分類器を訓練し、テストセ

ットでの精度を評価し、さらにクロスバリデーションを用いてモデルの一貫性を確認

している。

パイプライン 定義や意味 パイプライン(pipeline)は、データ処理や機械学習のプロセスにおける一連のステ ップを順に実行するための構造 各ステップは通常、データの前処理、特徴抽出、モデル学習、評価などのタスクで構 成される パイプラインによって、データ処理の流れを一元管理し、コードの可読性を向上さ せ、再現性のある処理を実現することが可能 数式で表現すると、パイプラインは以下の形式になる: f (x) = fn (fn−1 (… f2 (f1 (x)) …)) ここで、fi はパイプライン内の各ステップを表す 嚙み砕いた説明 パイプラインは料理のレシピのようなもの。例えば、サラダを作る工程を考えると、 野菜を洗う、野菜を切る、ドレッシングをかけるという手順がある これと同様に、データを処理するときにも一連の手順があり、それを順番に実行する ための枠組みがパイプライン ゲーム制作においても、キャラクターのモデリング、アニメーションの適用、エフェ クトの追加といった工程をパイプラインとして管理することができる 実際の応用例 Scikit-learnでのパイプラインは、特にデータ前処理とモデル学習を組み合わせる際に よく使われる 例えば、データの標準化とサポートベクターマシン(SVM)の組み合わせをパイプラ インで実装する例を以下に示す:

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.svm import SVC

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# データセットの読み込み

iris = load_iris()

X, y = iris.data, iris.target

# データセットの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42

# パイプラインの定義

pipeline = Pipeline([

('scaler', StandardScaler()),

# データの標準化

('svm', SVC())

# サポートベクターマシン

])

# モデルの学習

pipeline.fit(X_train, y_train)

# テストデータで予測

y_pred = pipeline.predict(X_test)

# 精度の評価

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy: {accuracy:.2f}")

このコードスニペットでは、データの標準化とSVMによる分類を一つのパイプライン

として管理

パイプラインを使用することで、前処理からモデルの適用までを簡潔かつ効率的に行

うことが可能

これにより、モデルの再現性が向上し、新たなデータセットや異なるモデルを試す際

もパイプラインの構造を活用できる

標準化(Standardization) 定義や意味 標準化とは、データセットの各特徴量(フィーチャー)の尺度を均一化する手法の一 つ。具体的には、各特徴量の平均を0、分散を1に変換するプロセス。数式で表すと、 あるデータ点 xi の標準化された値 zi は以下のように計算される。 zi = xi − μ σ ここで、μ は特徴量の平均、σ は特徴量の標準偏差を示す。 嚙み砕いた説明 データセットにおいて異なる特徴量が異なる単位やスケールを持つことが多いため、 例えば身長がセンチメートル、体重がキログラムなど、直接比較するのが難しい。標 準化はこれらの数値を同一の基準に揃え、比較や機械学習アルゴリズムへの適用を容 易にする技術。 実際の応用例 機械学習アルゴリズム、特にサポートベクターマシン(SVM)やk-近傍法(k-NN)な ど、距離計算を行う手法において、特徴量のスケールが異なると影響を受けやすいた め、標準化は重要な前処理ステップ。 標準化を行うことで、アルゴリズムが効率的に学習し、精度が向上することが期待さ れる。 以下はscikit-learnを用いてデータセットを標準化する例。

from sklearn.preprocessing import StandardScaler import numpy as np # サンプルデータを作成 data = np.array([[1.0, 2.0, 3.0], [4.0, 5.0, 6.0], [7.0, 8.0, 9.0]]) # StandardScalerのインスタンスを生成 scaler = StandardScaler() # データを標準化 standardized_data = scaler.fit_transform(data) print("標準化されたデータ:") print(standardized_data) このコードでは、 StandardScaler クラスを用いて行列形式のサンプルデータを標準化してい る。それぞれの特徴量は平均0、分散1に変換され、異なるスケールのデータを比較可能にし ている。 正規化 (Normalization) 定義や意味 正規化とは、データのスケールを統一するための手法であり、通常、各特徴量を同一 の範囲に収めることを目的とする。これは、異なるスケールを持つデータを比較した り、学習アルゴリズムの性能を向上させるために重要。 数学的には、正規化は以下のように行われることが多い: x′ = x − min(X) max(X) − min(X) ここで、x′ は正規化後の値、xは元の値、min(X)およびmax(X)はデータセットX の最小値と最大値。

嚙み砕いた説明 正規化は、例えば身長と体重のように異なる単位を持つデータを同じ基準で比較でき るようにする方法。これにより、特定の特徴量が他の特徴量よりも過度に影響を与え ることを防ぐことができる。 例えば、ゲームにおけるキャラクターステータスの均一化や、機械学習モデルでの効 率化を図る。 実際の応用例 正規化は特に機械学習の前処理段階で頻繁に使用される。例えば、scikit-learnライブ ラリを用いることで簡単に正規化を行うことができる。 from sklearn.preprocessing import MinMaxScaler # サンプルデータ data = [[-1, 2], [-0.5, 6], [0, 10], [1, 18]] # Min-Maxスケーリングのインスタンスを生成 scaler = MinMaxScaler() # データを正規化 normalized_data = scaler.fit_transform(data) print(normalized_data) # 出力例: [[0. , 0. ], [0.25, 0.25], [0.5 , 0.5 ], [1. , 1. ]] 上記のコードでは、 MinMaxScaler を用いてデータを0から1の範囲に正規化している。 この手法はニューラルネットワークや他の機械学習アルゴリズムにおいて、モデルの 収束速度を向上させるためによく使用される。 欠損値処理 定義や意味 欠損値処理とは、データセットに存在する欠損値(欠落したデータポイント)を適切 に扱うプロセスのこと。欠損値は、データ分析や機械学習において問題を引き起こす 可能性があるため、無視するか、補完するか、削除するかなどの方法で対処する必要 がある。

欠損値の処理方法には、削除、平均値または中央値での補完、前の値や後の値での補 完、機械学習モデルを用いた補完などがある。 嚙み砕いた説明 データセットにはしばしば、特定のエントリーに値が存在しない「欠損値」が含まれ ることがある。これらの欠損値が原因で、データ分析や機械学習モデルの精度が低下 することがあるため、適切な方法で欠損値を処理することが重要となる。 例えば、データの一部が入力ミスで抜けていたり、センサーの故障で計測値が取れな かったりすることがある。このような場合、欠損値を無視して分析を進めると結果が 偏ってしまう可能性がある。 実際の応用例 欠損値処理は、データクリーニングの重要なステップとして用いられ、データ分析お よび機械学習モデルのトレーニングにおいて欠かせないプロセスである。 scikit-learnを使用した欠損値処理の例を以下に示す。

import numpy as np

import pandas as pd

from sklearn.impute import SimpleImputer

# サンプルデータの作成

data = {

'A': [1, 2, np.nan, 4],

'B': [np.nan, 2, 3, 4],

'C': [1, 2, 3, np.nan]

}

df = pd.DataFrame(data)

# 欠損値を平均値で補完するImputerの作成

imputer = SimpleImputer(strategy='mean')

# Imputerをデータに適用

imputed_data = imputer.fit_transform(df)

# 補完結果をDataFrameに変換

imputed_df = pd.DataFrame(imputed_data, columns=df.columns)

print("Original DataFrame:")

print(df)

print("\nImputed DataFrame:")

print(imputed_df)

上記のコードスニペットでは、 pandas を用いてサンプルデータを作成

し、 scikit-learn の SimpleImputer を用いて欠損値を平均値で補完している。

SimpleImputer の strategy パラメータを変更することで、欠損値を中央値や最頻値で

補完することも可能である。

カテゴリ変数のエンコーディング

定義や意味

カテゴリ変数のエンコーディングとは、機械学習モデルが利用できる形式にカテゴリ

データを変換する手法を指す

カテゴリ変数とは、特定のカテゴリーやラベルで構成されるデータであり、数値デー

タと異なり直接数値演算ができない

エンコーディングによってカテゴリデータを数値データに変換することで、アルゴリ ズムがそのデータを処理可能にする 一般的なエンコーディング手法には、ワンホットエンコーディング(One-Hot Encoding)やラベルエンコーディング(Label Encoding)がある 嚙み砕いた説明 カテゴリ変数は、「色」や「サイズ」など、特定のグループやラベルでデータを分類 するもの 機械学習アルゴリズムは数値を扱うため、これらのラベルを数値に変換する必要があ る ワンホットエンコーディングは各カテゴリを0または1で表し、ラベルエンコーディン グはカテゴリを異なる整数値に変換する 実際の応用例 機械学習モデルでカテゴリデータを使用する際に、データが数値として扱われるよう にするために使用される 特に、scikit-learnライブラリを使用する場合、 OneHotEncoder や LabelEncoder を用い てカテゴリ変数をエンコードすることができる

from sklearn.preprocessing import OneHotEncoder, LabelEncoder # サンプルデータ categories = ['red', 'green', 'blue', 'green', 'red'] # ラベルエンコーディング label_encoder = LabelEncoder() labels_encoded = label_encoder.fit_transform(categories) print("Label Encoded:", labels_encoded) # 出力: Label Encoded: [2 1 0 1 2] # ワンホットエンコーディング onehot_encoder = OneHotEncoder(sparse=False) categories_reshaped = [[c] for c in categories] # 2D配列に変換 onehot_encoded = onehot_encoder.fit_transform(categories_reshaped) print("One Hot Encoded:\n", onehot_encoded) # 出力: # One Hot Encoded: # [[0. 0. 1.] # [0. 1. 0.] # [1. 0. 0.] # [0. 1. 0.] # [0. 0. 1.]] このように、カテゴリ変数をエンコードすることで、数値データとしてモデルに入力 することが可能になる 回帰 定義や意味 回帰とは、統計学や機械学習において、入力変数(特徴量)と出力変数(目標)の間 の関係性をモデル化する手法の一つ。特に連続値を予測するために使用される。 回帰モデルは、入力データを基に予測するための関数を学習し、その関数を用いて新 しいデータの出力を予測する。 数式として、回帰モデルは一般に次の形で表される: y = f (X) + ϵ

ここで、y は目標変数、X は特徴量ベクトル、f はモデル化された関数、ϵは誤差項を

表す。

嚙み砕いた説明

回帰は、例えば家の価格を予測するために使用される。家の大きさや部屋数などの特

徴量を用いて、家の価格という連続的な値を予測する。

よく知られた例として線形回帰がある。これは、直線をデータにフィットさせること

で、特徴量と目標変数の関係をモデル化する方法。

実際の応用例

回帰は、ビジネス予測、経済分析、自然科学の研究、ゲームにおけるキャラクターの

動きや環境の物理的シミュレーションなど、幅広い分野で応用されている。

Pythonのライブラリであるscikit-learnを使用して線形回帰を実装する例を以下に示

す。

from sklearn.linear_model import LinearRegression

import numpy as np

# 特徴量と目標変数のデータセット

X = np.array([[1], [2], [3], [4], [5]])

# 例: 部屋数

y = np.array([150, 200, 250, 300, 350])

# 例: 価格

# 線形回帰モデルの作成

model = LinearRegression()

# モデルの学習

model.fit(X, y)

# 新しいデータに対する予測

X_new = np.array([[6]])

y_pred = model.predict(X_new)

print(f"予測された価格: {y_pred[0]}")

# 出力: 予測された価格: 400.0

上記のコードでは、scikit-learnの LinearRegression クラスを使用して、単純な線形回

帰モデルを作成し、学習させている。部屋数に基づいて価格を予測する例であり、部

屋数6の新しいデータに対して価格を予測している。

どの概念について解説を作成するか指定してください。例えば、機械学習のモデル、データ 前処理、特徴選択、クラスタリングなど、具体的な項目を教えてください。 クロスバリデーション 定義や意味 クロスバリデーション(Cross-validation)は、モデルの汎化性能を評価するための手 法の一つ。データセットを複数のサブセットに分割し、学習と評価を繰り返すこと で、モデルの性能を安定的に評価することを目的とする 最も一般的な手法であるk分割クロスバリデーション(k-fold cross-validation)では、 データをk 個のほぼ等しいサイズのサブセット(fold)に分割する。モデルはk − 1個 のサブセットで学習し、残りの1つで評価を行う。このプロセスをk 回繰り返し、各 foldが一度ずつ評価に用いられる 各試行での評価結果を平均化することで、モデルの汎化性能を推定する k 1 CV_score = ∑ Score(fi ) k i=1 ここで、Score(fi )はi番目のfoldに対する評価スコア 嚙み砕いた説明 データをいくつかのグループに分け、その一つをテスト用、残りを学習用として使 う。これを全てのグループが一度はテスト用になるように繰り返す手法 例えば、データを5つに分ける場合、最初は1つ目のグループをテスト用、残りを学習 用に使い、次に2つ目のグループをテスト用にして、また学習を行う。このように5回 繰り返し、全ての結果をまとめることで、モデルが新しいデータに対してもどれくら い良い予測ができるかを確認する 実際の応用例 機械学習モデルの性能評価において、過学習を防ぎ、モデルの一般化能力を確認する ために使用される 多くの機械学習ライブラリでサポートされており、Pythonのscikit-learnでは簡単に実 装できる

from sklearn.model_selection import cross_val_score

from sklearn.datasets import load_iris

from sklearn.linear_model import LogisticRegression

# データセットのロード

iris = load_iris()

X, y = iris.data, iris.target

# モデルの定義

model = LogisticRegression(max_iter=200)

# クロスバリデーションの実行(5分割)

scores = cross_val_score(model, X, y, cv=5)

# 各foldのスコアとその平均を出力

print("Cross-validation scores:", scores)

print("Average score:", scores.mean())

このコードスニペットは、Irisデータセットに対してロジスティック回帰モデルを使用し、5

分割クロスバリデーションを実行して、各foldでのスコアとその平均を算出する例を示す。

クラスタリング

定義や意味

クラスタリングとは、データをいくつかのグループ(クラスター)に分ける手法であ

り、同じグループ内のデータは互いに似ているが、異なるグループのデータとは異な

る特徴を持つようにすることを目的とする

数式的には、データ集合 X = {x1 , x2 , … , xn } を与えられたとき、これを k 個の

クラスタ C1 , C2 , … , Ck に分割することを指す

代表的な手法として、k -means法があり、これは以下のような手順で行う

i. 初期のクラスタ中心 μ1 , μ2 , … , μk をランダムに選択

ii. 各データ点 xi を最も近いクラスタ中心に割り当てる

iii. 各クラスタ Cj の新しい中心を計算し、中心を更新: μj = ∣C1 ∣ ∑xi ∈Cj xi

j

iv. クラスタ中心が収束するまで2と3を繰り返す

嚙み砕いた説明 クラスタリングはデータをグループ分けするための方法 たとえば、写真をクラスタリングして、似たような風景のものをまとめたり、顧客デ ータをクラスタリングして、似た行動パターンの人々をグループ化するなどに使用さ れる k -means法では、データをいくつかのグループに分け、グループ内のデータがどれも 似ているように調整する 実際の応用例 ゲーム制作において、プレイヤーの行動パターンをクラスタリングし、異なる難易度 設定や報酬体系をプレイヤーのタイプごとに最適化することができる 画像処理において、似た色をクラスタリングして画像の圧縮に利用することができる 機械学習ライブラリのscikit-learnを用いて、クラスタリングを実行する際の実際のコ ード例を示す from sklearn.cluster import KMeans import numpy as np # サンプルデータの生成 X = np.array([ [1.0, 2.0], [1.5, 1.8], [5.0, 8.0], [8.0, 8.0], [1.0, 0.6], [9.0, 11.0] ]) # KMeansクラスタリングの実行 kmeans = KMeans(n_clusters=2) # 2つのクラスタに分ける kmeans.fit(X) # クラスタリングの結果 print("Cluster Centers:", kmeans.cluster_centers_) print("Labels:", kmeans.labels_) # 結果の出力 # 出力されたクラスタ中心と各データ点がどのクラスタに属するかを表示

このコード例では、X というデータセットを2つのクラスタに分け、各データ点がど のクラスタに属するかを求めている scikit-learnのKMeansクラスを用いることで簡単にクラスタリングが行える 次元削減 定義や意味 次元削減とは、高次元データをより低次元の空間に変換するプロセスを指す。これに より、データの可視化や計算の効率化、ノイズの除去が可能になる。次元削減には主 に線形次元削減と非線形次元削減が存在する。 主成分分析(Principal Component Analysis, PCA)は次元削減の代表的な手法であ り、データの分散を最大限に保つように新しい軸を設定する。PCAでは、データを平 均ゼロにシフトした後、共分散行列を計算し、その固有ベクトルと固有値を用いて変 換を行う。 数式で表すと、次元削減は次のように表現される。データ行列をX ∈ Rn×d とし、次 元削減後のデータをZ ∈ Rn×k とすると: Z = XW ここで、W ∈ Rd×k は変換行列を表す。 嚙み砕いた説明 次元削減は、データの要素(次元)が多すぎる場合に、その情報を保ちながら重要な 部分だけを取り出すための方法。例えば、3Dで描かれた物体を2Dの紙に描くような イメージ。 次元削減は、データの見た目をシンプルにし、計算を速くするために使われる。デー タが複雑すぎると、計算に時間がかかるし、データの本当の姿が見えにくくなる。 実際の応用例 次元削減は、データの可視化、ノイズ除去、特徴選択、モデルの過学習防止など、多 岐にわたる応用がある。特に機械学習においては、モデルのトレーニングを効率化す るために使われる。 scikit-learnを用いたPCAの実装例を以下に示す。この例では、乳がんの診断データセ ットを用いて次元を削減し、データの可視化を行う。

from sklearn.decomposition import PCA from sklearn.datasets import load_breast_cancer import matplotlib.pyplot as plt # データセットのロード data = load_breast_cancer() X = data.data y = data.target # PCAによる次元削減 pca = PCA(n_components=2) X_reduced = pca.fit_transform(X) # 結果のプロット plt.figure(figsize=(8, 6)) plt.scatter(X_reduced[y == 0, 0], X_reduced[y == 0, 1], alpha=0.5, label='Class 0') plt.scatter(X_reduced[y == 1, 0], X_reduced[y == 1, 1], alpha=0.5, label='Class 1') plt.xlabel('Principal Component 1') plt.ylabel('Principal Component 2') plt.title('PCA of Breast Cancer Dataset') plt.legend() plt.show() このコードは、乳がんデータセットを2次元に削減し、結果をプロットする。PCAを 用いることで、データの分布を視覚的に確認できる。 GridSearchCV 定義や意味 GridSearchCVは機械学習におけるハイパーパラメータの最適化手法の一つで、指定 されたパラメータ値の組み合わせに対して交差検証を行い、最も良い性能を示すパラ メータセットを探索する手法 scikit-learnの GridSearchCV クラスは、指定されたモデルに対してパラメータグリッド を設定し、異なるパラメータの組み合わせでモデルを訓練し、その結果を評価する 交差検証により異なるデータ分割で評価を行うため、過学習を防ぎ、より一般化され たモデルの選択を可能にする

嚙み砕いた説明 GridSearchCVは、機械学習モデルの「設定項目」(ハイパーパラメータ)を調整す るためのツール 例えば、決定木の深さや、ランダムフォレストの木の数など、モデルの性能に影響を 与える設定を試す 設定可能な項目を色々な組み合わせで試し、どの組み合わせが最も良い結果を出すか を見つける 交差検証という手法を使い、データを複数に分割して訓練とテストを繰り返し、どの 組み合わせが平均的に良いかを判断 実際の応用例 機械学習モデルのパラメータチューニングに使用される 例えば、分類問題でSVM(サポートベクターマシン)のハイパーパラメータであ る C とカーネル関数を最適化する 以下に、SVC(サポートベクターマシン分類器)のハイパーパラメータをGridSearchCVを使 って最適化する例を示す:

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# データセットのロード

iris = load_iris()

X, y = iris.data, iris.target

# データの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42

# ハイパーパラメータグリッドの定義

param_grid = {

'C': [0.1, 1, 10, 100],

'kernel': ['linear', 'rbf', 'poly'],

'gamma': ['scale', 'auto']

}

# SVCモデルのインスタンス化

svc = SVC()

# GridSearchCVのインスタンス化

grid_search = GridSearchCV(estimator=svc, param_grid=param_grid, cv=5, n_jobs=-1, verbos

# モデルのフィッティング

grid_search.fit(X_train, y_train)

# 最適なパラメータの表示

print("Best parameters found: ", grid_search.best_params_)

# テストセットでのスコアの表示

print("Test set score: ", grid_search.score(X_test, y_test))

上記のコードは、Irisデータセットを用いてSVCの最適なハイパーパラメータを見つ

けるためのもの

param_grid で試すパラメータの組み合わせを指定し、 GridSearchCV がそれらの組み

合わせを試す

最良のパラメータセットは grid_search.best_params_ で取得可能

テストセットでの性能を確認することで、最適化されたモデルの実際の精度を評価可

能

RandomizedSearchCV 定義や意味 RandomizedSearchCVは、機械学習モデルのハイパーパラメータチューニングをラン ダムに探索するための手法 ハイパーパラメータの組み合わせを網羅的に探索するGridSearchCVと異なり、ラン ダムに設定された数の組み合わせを評価する 探索する組み合わせの数はユーザーが指定でき、計算資源の消費を抑えつつ効果的に 最適なパラメータを見つけることが可能 クロスバリデーションを用いてモデルを評価し、最良のパラメータ組み合わせを見つ ける 目的関数を最小化する最適なパラメータを探索する際に用いる 数式で表すと、目的関数 f (θ) を最小化する θ を以下のように探索する: θ∗ = arg min f (θ) θ∈Θ ここで、Θ は探索するハイパーパラメータの空間を表す。 嚙み砕いた説明 モデルの良し悪しを決めるハイパーパラメータを、全ての組み合わせを試すのではな く、ランダムに選んで試す方法 たくさんの組み合わせを試すのは時間や計算力が必要なので、ランダムに選ぶことで 効率的に最適な設定を見つける 例えば、道に迷ったときに全ての道を試すのではなく、ランダムにいくつかの道を試 してみるようなイメージ 実際の応用例 機械学習モデルのハイパーパラメータチューニングに広く用いられる 特に、計算リソースが限られている場合や、パラメータ空間が非常に大きい場合に有 効 以下に、scikit-learnを用いたRandomizedSearchCVの例を示す。

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import RandomizedSearchCV

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# データセットの読み込み

iris = load_iris()

X, y = iris.data, iris.target

# 訓練データとテストデータに分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42

# ランダムフォレストモデルの初期化

rf = RandomForestClassifier()

# ハイパーパラメータの探索空間を定義

param_dist = {

'n_estimators': [10, 50, 100],

'max_features': ['auto', 'sqrt', 'log2'],

'max_depth': [None, 10, 20, 30],

'criterion': ['gini', 'entropy']

}

# RandomizedSearchCVの初期化

random_search = RandomizedSearchCV(

estimator=rf,

param_distributions=param_dist,

n_iter=10,

# 試行するパラメータの組み合わせ数

cv=5,

random_state=42

)

# モデルの訓練

random_search.fit(X_train, y_train)

# 最良のパラメータを出力

print("Best Parameters:", random_search.best_params_)

このコードでは、 RandomForestClassifier のハイパーパラメータを RandomizedSearchCV を

使用して最適化。 n_iter=10 により、ランダムに10の組み合わせを試行し、最良の結果を返

す。

交差検証 定義や意味 交差検証(Cross-Validation)は、機械学習モデルの性能評価を行うための手法であ る。データセットを複数の部分に分割し、その一部をモデルの訓練に使用し、残りを モデルの評価に使用することを繰り返すことで、モデルの汎化性能をより正確に推定 する。 一般的な手法としては、データセットをk 個に分割し(k -Fold Cross-Validation)、各 部分を一度ずつ評価セットとして使用し、残りを訓練に使用する。これにより、k 回 の評価を行い、それらの平均を最終的な評価とする。 k 1 Cross-Validation Score = ∑ Scorei k i=1 嚙み砕いた説明 交差検証は、データを何度も分けてモデルを訓練・評価することで、モデルが新しい データに対してどれだけうまく動作するかを確認するための方法。単一の訓練セット とテストセットだけで評価するよりも、モデルの性能をより安定して推定できる。 たとえば、データを5分割する場合、最初の1分割をテストに使い、残りを訓練に使 う。これを5回繰り返し、すべてのデータが一度はテストに使われるようにする。 実際の応用例 交差検証は、機械学習のモデル選定やハイパーパラメータのチューニングに広く用い られる。 scikit-learnを用いた具体例を以下に示す。ここでは、 KFold クラスを使ってデータを5 分割し、線形回帰モデルの交差検証を行う。

from sklearn.model_selection import KFold, cross_val_score

from sklearn.linear_model import LinearRegression

from sklearn.datasets import make_regression

# データセットを生成

X, y = make_regression(n_samples=100, n_features=2, noise=0.1, random_state=42)

# 線形回帰モデルをインスタンス化

model = LinearRegression()

# 交差検証の設定

kf = KFold(n_splits=5, shuffle=True, random_state=42)

# 交差検証によるスコアの計算

scores = cross_val_score(model, X, y, cv=kf, scoring='r2')

print(f"Cross-Validation R^2 Scores: {scores}")

print(f"Mean R^2 Score: {scores.mean()}")

このコードは、データセットを5つの部分に分け、それぞれを交互にテストセットと

しながら、線形回帰モデルの性能を評価している。出力されるスコアは、モデルが新

しいデータに対する予測性能の指標となる。

プログラミング及びゲーム制作における評価指標

定義や意味

評価指標は、モデルのパフォーマンスを測定するための基準を提供する手法

プログラミングやゲーム制作では、特に機械学習モデルの精度や効果を評価するため

に用いられる

典型的には、分類問題や回帰問題に応じた指標が存在する

分類問題における一般的な評価指標には、精度 (Accuracy)、適合率 (Precision)、再現

率 (Recall)、F1スコアなどがある

回帰問題における一般的な評価指標には、平均二乗誤差 (Mean Squared Error, MSE)

や決定係数 (R2 ) などがある

嚙み砕いた説明

評価指標は、モデルがどれくらい良く問題を解決できたかを数値で示すもの

例えば、ゲームAIが敵をどれだけ効率よく倒せるか、プレイヤーの動きをどれだけ正

確に予測できるかを数値で示す

分類問題では、どれだけ正しくクラスを識別できたかを測るのが評価指標の役目であ

り、回帰問題では予測と実際の値のズレを測る

ゲームのスコアシステムやパフォーマンス評価にも類似の考え方が使われる

実際の応用例

scikit-learn を用いてモデルの性能を評価する方法

以下に分類問題における評価指標の使用例を示す

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

# データセットのロード

data = load_iris()

X_train, X_test, y_train, y_test = train_test_split(data.data, data.target, test_size=0.

# モデルのトレーニング

model = RandomForestClassifier(random_state=42)

model.fit(X_train, y_train)

# 予測

y_pred = model.predict(X_test)

# 各評価指標を計算し出力

accuracy = accuracy_score(y_test, y_pred)

precision = precision_score(y_test, y_pred, average='weighted')

recall = recall_score(y_test, y_pred, average='weighted')

f1 = f1_score(y_test, y_pred, average='weighted')

print(f"Accuracy: {accuracy:.2f}")

print(f"Precision: {precision:.2f}")

print(f"Recall: {recall:.2f}")

print(f"F1 Score: {f1:.2f}")

この例では、Irisデータセットを用いてランダムフォレストモデルの性能を評価してい

る

accuracy_score はモデルが正しく分類した割合を示す precision_score は予測がどれだけ正確であるか(誤検出が少ないか)を示す recall_score は実際に正しい項目をどれだけ見逃さずに予測できたかを示す f1_score は精度と再現率の調和平均であり、バランスの取れた評価を行うために用い る Pipeline 定義や意味 Pipelineは一連のデータ処理ステップを連結し、統一されたプロセスとして実行する ための設計パターン。特に機械学習の文脈では、データの前処理、特徴量抽出、モデ ルの訓練、評価といった一連の処理を一つの流れとしてまとめることで、再利用性や 可読性を向上させる。 数式で表すと、Pipelineは次のように表現されることがある: y = fn ∘ fn−1 ∘ ⋯ ∘ f1 (x) ここで、fi は各処理ステップを表し、x は入力データ、y は最終的な出力。 嚙み砕いた説明 Pipelineは料理のレシピのようなもの。材料(データ)を準備し、順番に加工(前処 理や変換)し、最終的に出来上がった料理(予測値やモデル)を得る。各ステップを 一つずつ行うのではなく、全体の流れを一つの手続きとしてまとめることで手間を省 く。 例えば、野菜を切って炒め、調味料を加えるのを個別に行うのではなく、これらをま とめて「野菜炒めを作る」という一連の流れとして捉える。 実際の応用例 scikit-learnにおけるPipelineは、データ前処理とモデル訓練を一貫して行うためによく 利用される。これにより、データセットの分割やクロスバリデーションといった操作 を簡潔に実装できる。

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.svm import SVC

from sklearn.model_selection import train_test_split

from sklearn.datasets import load_iris

# データセットを読み込む

iris = load_iris()

X, y = iris.data, iris.target

# データを訓練用とテスト用に分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42

# パイプラインを定義

pipeline = Pipeline([

('scaler', StandardScaler()),

# データの標準化

('svc', SVC())

# サポートベクターマシンによる分類

])

# パイプラインを訓練データに適用

pipeline.fit(X_train, y_train)

# テストデータに対する予測

score = pipeline.score(X_test, y_test)

print(f"Test accuracy: {score}")

この例では、標準化とSVMによる分類を一つのPipelineオブジェクトにまとめること

で、データの前処理とモデルの訓練を一貫して実行している。これは特にデータの前

処理がモデル評価に直接影響する場合に便利。

FeatureUnion

定義や意味

FeatureUnion は、Scikit-learnにおけるクラスの一つで、複数の異なる特徴量変換器

(transformer)を並列に適用し、その結果を結合して一つの特徴量空間を構築するた

めのツール

特徴量の変換は、機械学習モデルのパフォーマンスを向上させるために重要であり、

異なる変換手法を組み合わせることで多様な特徴量を生成可能

形式的には、X を入力データとし、T1 , T2 , … , Tn を適用する変換器とする と、 FeatureUnion は以下のように表現される T (X) = [T1 (X), T2 (X), … , Tn (X)] 嚙み砕いた説明 FeatureUnion は、機械学習で使うデータの「特長」を引き出すための方法を複数組み 合わせて、それらを一つのまとまりにする技術 例えば、ある一つのデータセットに対して、異なる方法でデータを加工し、その結果 を合わせて一つの大きなデータセットを作る これにより、より多くの情報を持つデータセットを作ることができ、機械学習モデル の性能を向上させることが可能 実際の応用例 機械学習パイプラインにおいて、数値データとカテゴリデータの両方を含むデータセ ットを処理する際に使用 数値データに対しては標準化を行い、カテゴリデータに対してはワンホットエンコー ディングを行うなど、異なる処理を組み合わせて一つのデータセットにまとめる

from sklearn.pipeline import FeatureUnion from sklearn.preprocessing import StandardScaler, OneHotEncoder from sklearn.compose import ColumnTransformer from sklearn.impute import SimpleImputer from sklearn.datasets import fetch_openml import pandas as pd # サンプルデータセットの読み込み data = fetch_openml(name='titanic', version=1, as_frame=True) X = data.data y = data.target # 数値データとカテゴリデータのカラムを指定 numeric_features = ['age', 'fare'] categorical_features = ['embarked', 'sex', 'pclass'] # 数値データに対する変換 numeric_transformer = SimpleImputer(strategy='median') # カテゴリデータに対する変換 categorical_transformer = OneHotEncoder(handle_unknown='ignore') # ColumnTransformerを用いて特徴量ごとの変換を定義 preprocessor = ColumnTransformer( transformers=[ ('num', numeric_transformer, numeric_features), ('cat', categorical_transformer, categorical_features) ]) # FeatureUnionを用いて定義された変換を結合 combined_features = FeatureUnion(transformer_list=[ ('preprocess', preprocessor), ('scaler', StandardScaler()) ]) # 変換を適用してデータを変換 X_transformed = combined_features.fit_transform(X) # 変換後のデータを確認 print(X_transformed.shape) 上記のコードでは、数値データに対しては欠損値の補完と標準化を行い、カテゴリデ ータに対してはワンホットエンコーディングを行う

FeatureUnion を使うことで、これらの異なる変換を一つの統一されたステップとして 処理し、結果を結合した形で取得可能 線形回帰 定義や意味 線形回帰(Linear Regression)は、連続的な応答変数と一つまたは複数の説明変数と の間の関係をモデル化するための統計手法。最も基本的な回帰手法であり、予測やデ ータ分析に広く用いられる。 線形回帰モデルは、説明変数と応答変数の間の線形関係を仮定し、以下のように表現 される。 y = β 0 + β 1 x1 + β 2 x2 + ⋯ + β n xn + ϵ ここで、y は応答変数、x1 , x2 , … , xn は説明変数、β0 , β1 , … , βn は回帰係数、ϵ は誤差項を示す。 嚙み砕いた説明 線形回帰は、データセットにおける特定の変数(特徴量)が他の変数(ターゲット) にどのように影響を与えるかを理解するためのツール。具体的には、データポイント の集まりに対して最適な直線を引き、その直線を用いて将来のデータポイントを予測 する。 例えば、広告費(説明変数)と売上(応答変数)のデータがあるとき、線形回帰を用 いて広告費が売上に与える影響を調べられる。 実際の応用例 線形回帰は、ビジネスにおける売上予測、科学におけるデータ分析、ゲーム開発にお けるバランス調整に役立てられる。 Pythonの機械学習ライブラリであるscikit-learnを用いた線形回帰モデルの実装例を以 下に示す。

from sklearn.linear_model import LinearRegression import numpy as np # データセットの例 # Xは説明変数、yは応答変数 X = np.array([[1], [2], [3], [4], [5]]) y = np.array([2, 3, 5, 7, 11]) # 線形回帰モデルのインスタンスを作成 model = LinearRegression() # モデルをデータに適合させる model.fit(X, y) # 回帰係数(傾き)と切片を取得 slope = model.coef_ intercept = model.intercept_ print(f"回帰係数(傾き): {slope}") print(f"切片: {intercept}") # 新しいデータポイントで予測を行う X_new = np.array([[6]]) y_pred = model.predict(X_new) print(f"予測された値: {y_pred}") このコードスニペットでは、X と y のデータセットに対して線形回帰モデルを適合させ、新 しいデータポイント Xnew = 6 に基づいて応答変数の予測を行う。 決定木回帰 定義や意味 決定木回帰は、決定木アルゴリズムを用いて連続値を予測するための回帰モデルの一 種 決定木はデータを分割し、ツリー構造を形成することで予測を行う 回帰における決定木の目的は、入力空間を領域に分割し、それぞれの領域における出 力の平均または中央値を予測値として用いること

決定木回帰の数式は以下の通り 予測値 y ^ は、訓練データ (X, y) に基づいて構築された決定木によって計算さ れる 決定木は、特徴空間を R1 , R2 , … , Rm のように分割し、それぞれの領域 Rm における予測値は、その領域内のデータ点の目標値の平均 数式で表すと、y ^ = ∣R1 ∣ ∑xi ∈Rm yi となる m 嚙み砕いた説明 決定木回帰は、与えられたデータを基に「はい/いいえ」の質問を繰り返し、データを どんどん分割していくことで予測を行う手法 例えば、家の価格を予測する際に、「場所はどこか」「広さはどれくらいか」「築年 数は何年か」などの質問を基に価格を予測 木の各分岐点でデータを一度に一つの特徴に基づいて分割し、最終的に葉ノードで予 測値を出す 実際の応用例 決定木回帰は、ゲーム内のキャラクターの動きを予測するAIや、ゲーム内経済の価格 設定に利用される 例えば、プレイヤーの行動履歴に基づいて次の行動を予測する際にも使用可能 以下は、Pythonのscikit-learnライブラリを用いた決定木回帰の例

from sklearn.tree import DecisionTreeRegressor import numpy as np # サンプルデータの作成 # 特徴量 X = np.array([[1], [2], [3], [4], [5]]) # 目標値 y = np.array([1.5, 2.5, 3.0, 3.5, 4.5]) # 決定木回帰モデルの作成 regressor = DecisionTreeRegressor() # モデルの訓練 regressor.fit(X, y) # 新しいデータに対する予測 X_test = np.array([[1.5], [2.5], [3.5]]) predictions = regressor.predict(X_test) # 予測結果の表示 print(predictions) # 予測結果: [1.5 2.5 3.5] このコードは、簡単なデータセットを用いて決定木回帰を行う例 特徴量と目標値を訓練データとしてモデルに提供し、訓練後のモデルに対して新しい データの予測を行う scikit-learnの DecisionTreeRegressor を用いることで、簡単に決定木回帰モデルを実装 可能 ロジスティック回帰 定義や意味 ロジスティック回帰は統計モデルの一つで、主に二項または多項分類問題に用いられ る。線形回帰とは異なり、出力が離散的なカテゴリカルデータであるため、出力が0 から1の範囲に収まるようにシグモイド関数を用いる。 ロジスティック回帰のモデルは次のように表される: 1 確率 P (Y = 1∣X) = 1+e−(β0 +β1 X1 +β2 X2 +⋯+βn Xn )

ここで、Y は目的変数、X1 , X2 , … , Xn は説明変数、β0 , β1 , … , βn は回帰 係数 嚙み砕いた説明 ロジスティック回帰は、特定の事象が発生する確率を予測するための方法。例えば、 メールがスパムか否かを判断する際に使われる。線形回帰と異なり、結果を0か1の二 値で表すためにシグモイド関数を用いる。 シグモイド関数は、S字型の曲線で、入力された値を0から1の範囲に変換する。この 特性により、確率として解釈可能な値を出力する。 実際の応用例 ロジスティック回帰は、スパムメールフィルタリング、信用リスクの評価、医療診断 での疾患の有無の予測など、多岐にわたる分類問題で利用される。 以下は、Pythonのscikit-learnを用いたロジスティック回帰の実装例。Irisデータセット を使用し、花の種を分類する。

# 必要なライブラリをインポート from sklearn.datasets import load_iris from sklearn.model_selection import train_test_split from sklearn.preprocessing import StandardScaler from sklearn.linear_model import LogisticRegression from sklearn.metrics import accuracy_score # Irisデータセットの読み込み iris = load_iris() X, y = iris.data, iris.target # データセットを訓練用とテスト用に分割 X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42 # データの標準化 scaler = StandardScaler() X_train = scaler.fit_transform(X_train) X_test = scaler.transform(X_test) # ロジスティック回帰モデルの作成 model = LogisticRegression(max_iter=200) model.fit(X_train, y_train) # テストデータに対する予測 y_pred = model.predict(X_test) # 精度の評価 accuracy = accuracy_score(y_test, y_pred) print(f"Accuracy: {accuracy * 100:.2f}%") 上記の例では、Irisデータセットを用いて、ロジスティック回帰モデルを訓練し、テス トデータに対する正確さを評価している。これにより、どの花の種に分類されるかを 予測することができる。 サポートベクターマシン (SVM) 定義や意味 サポートベクターマシン (Support Vector Machine, SVM) は、分類と回帰分析に用い られる教師あり学習モデルの一種

特に、二値分類問題において、データセットを異なるクラスに分類する超平面を見つ け出すことを目的とする SVMは、マージン(クラス間の境界の幅)を最大化する超平面を見つけることで、将 来的にデータポイントをより正確に分類する 数学的には、データポイント xi に対して、分類するための超平面は次のように表さ れる f (x) = w ⋅ x + b = 0 ここで、w は重みベクトル、b はバイアス項 嚙み砕いた説明 サポートベクターマシンは、データの中から「サポートベクター」と呼ばれるデータ ポイントを選び、これらを基に最適な境界線(超平面)を引く手法 マージンを最大化することで、データの変動に対しても頑健な分類境界を提供 データが線形分離可能でない場合には、カーネルトリックを利用して非線形な境界を 作成可能 例えば、犬と猫の画像を分類する場合、SVMは犬と猫を最も広く安全に分けられる線 (面)を見つけ出す 実際の応用例 SVMは、画像認識、テキスト分類、バイオインフォマティクスなど多くの分野で使用 される ゲーム開発においては、プレイヤーの行動データをもとにチートの検出やプレイヤー の好みのパターンを分類するために利用されることもある 以下はPythonのscikit-learnを用いたSVMの実装例:

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# データセットの読み込み

iris = datasets.load_iris()

X = iris.data

y = iris.target

# 訓練データとテストデータの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42

# SVMモデルの作成

model = SVC(kernel='linear')

# 線形カーネルを使用

# モデルの訓練

model.fit(X_train, y_train)

# テストデータの予測

y_pred = model.predict(X_test)

# 精度の評価

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy: {accuracy:.2f}")

# このコードは、Irisデータセットを用いて線形カーネルを持つSVMで分類を行い、精度を評価する例

このコードは、scikit-learnのSVMを用いてIrisデータセットを分類する基本的な例を示してい

る。

K-Means

定義や意味

K-Meansは、データをk 個のクラスタに分割するための非階層型クラスタリング手法

の一つ。各データポイントは、クラスタの重心(センター)に最も近いクラスタに割

り当てられる。

クラスタの重心は繰り返し計算され、各データポイントの割り当てが変更される。プ

ロセスは収束するまで続けられる。

具体的には、次の手順を繰り返す: i. 初期クラスタの重心をランダムに選ぶ。 ii. 各データポイントを最も近い重心に基づいてクラスタに割り当てる。 iii. 各クラスタの新しい重心を計算する。 iv. 重心が変わらなくなるまでまたは指定された回数まで手順2と3を繰り返す。 数式による具体例: クラスタリングの目的関数は以下で表現される: k J = ∑ ∑ ∥xj − μi ∥2 i=1 xj ∈Ci ここで、Ci はクラスタi、xj はデータポイント、μi はクラスタiの重心、∥ ⋅ ∥はユーク リッド距離。 嚙み砕いた説明 K-Meansは、データを似た特徴を持つグループ(クラスタ)に分ける手法。まず、デ ータをk 個のグループに分けることを試みる。各グループには、一つの「中心」があ り、データポイントは最も近い中心に属する。 例えば、さまざまな色のボール(データポイント)をk 個のバケツ(クラスタ)に分 けることを考える。それぞれのバケツには色の平均が求められ、その平均に最も近い ボールがそのバケツに入れられる。 実際の応用例 画像の圧縮:画像のピクセルをk 個のクラスタに分け、各クラスタの平均色を用いる ことで画像の色を減らすことができる。 市場セグメンテーション:顧客の購買行動をクラスタリングし、類似した購買パター ンを持つグループを見つける。 scikit-learnを用いたK-Meansの実装例:

from sklearn.cluster import KMeans import numpy as np # サンプルデータ X = np.array([[1, 2], [1, 4], [1, 0], [10, 2], [10, 4], [10, 0]]) # K-Meansクラスタリング kmeans = KMeans(n_clusters=2, random_state=0).fit(X) # クラスタの重心 print("Cluster centers:") print(kmeans.cluster_centers_) # 各ポイントが属するクラスタ print("Labels:") print(kmeans.labels_) 上記のコードでは、データポイントを2つのクラスタに分ける。各クラスタの中心と データポイントのクラスタラベルが出力される。 階層型クラスタリング 定義や意味 階層型クラスタリングは、観測データを階層的に分割および統合する手法を指す。デ ータポイント間の類似度に基づいて、データを階層構造で表現することができる。主 に凝集型と分割型の2つの手法が存在する。 凝集型(Agglomerative)クラスタリングは、各データポイントを個別のクラスタと して開始し、段階的に最も類似したクラスタペアを統合していく。統合が進むにつれ て、クラスタ数は減少し、最終的にすべてのデータポイントが単一のクラスタにまと められる。 分割型(Divisive)クラスタリングは、逆に、すべてのデータポイントを含む単一の クラスタから開始し、段階的にクラスタを分割していく手法である。 クラスター間の距離を測定するための方法として、以下のようなものがある: 単一リンク法:最も近い点間の距離 完全リンク法:最も遠い点間の距離

平均リンク法:すべての点間の平均距離

ウォード法:クラスター内部の分散の増加を最小限に抑える

数式によって、単一リンク法の距離を定義することができる:

dsingle (Ci , Cj ) = min{d(xa , xb ) ∣ xa ∈ Ci , xb ∈ Cj }

嚙み砕いた説明

階層型クラスタリングは、データをグループに分ける方法の一つで、どのデータがど

のグループに属するかを階層構造で示す。例えば、家族の系図のように、データの類

似度に基づき、データを小さいグループから大きなグループへとまとめていく。

凝集型クラスタリングでは、まずすべてのデータを個別のグループとして扱い、似て

いるもの同士を少しずつくっつけていく。一方、分割型クラスタリングは、大きなグ

ループを徐々に分割していく。

実際の応用例

階層型クラスタリングは、特にデンドログラム(木構造)を用いてデータの階層的な

関係を視覚化するのに役立つ。これは、遺伝子データや顧客セグメンテーション、ド

キュメントの分類などでよく利用される。

Pythonのライブラリであるscikit-learnを用いて、階層型クラスタリングを実装する例

を以下に示す。

from sklearn.cluster import AgglomerativeClustering

import numpy as np

# サンプルデータ

X = np.array([[1, 2], [2, 3], [3, 4], [5, 5], [8, 8]])

# 階層型クラスタリングのモデルを作成

model = AgglomerativeClustering(n_clusters=2, linkage='ward')

# モデルの適用

labels = model.fit_predict(X)

print("Cluster labels:", labels)

# 結果としてデータポイントがどのクラスタに属するかを示すラベルが得られる

このコードでは、 AgglomerativeClustering クラスを用いて、与えられたデータに対して凝集

型クラスタリングを適用している。 linkage パラメータはクラスタ間の距離計算方法を指定

し、ここではウォード法を使用している。 主成分分析 定義や意味 主成分分析(Principal Component Analysis, PCA)は、多次元データを低次元に変換 するための線形変換手法である。主にデータの次元削減や特徴抽出に利用される。 PCAは、データの分散が最大となる方向を見つけ、その方向にデータを射影すること で次元を削減する手法である。 数学的には、データ行列 X ∈ Rn×p (nはサンプル数、pは特徴数)を用意し、共分 1 散行列 C = n−1 X T X を計算し、その固有ベクトルと固有値を求める。固有値が大 きい順に固有ベクトルを選び、主成分として使用する。 PCAの数学的手順は以下の通り: i. データの平均を計算し、データから平均を引いて中心化する。 ii. 共分散行列を計算する。 iii. 共分散行列の固有値と固有ベクトルを計算する。 iv. 固有値が大きい順に固有ベクトルを選び、それを基にデータを新たな空間に射影 する。 嚙み砕いた説明 主成分分析はデータのパターンを見つけ、重要な情報を保ちながらデータの次元を減 らす手法である。例えば、高次元のデータを視覚的に理解したい場合、2次元または3 次元に縮約するためにPCAを使用する。 データがたくさんの変数を持つとき、その全てを一度に理解するのは難しい。PCAを 使うことで、情報を失わずにデータを少数の新しい変数にまとめることができる。例 として、多くの異なるセンサーからのデータを、少数の重要なセンサー情報に集約す ることが挙げられる。 実際の応用例 主成分分析は、顔認識、画像圧縮、ノイズ除去、データの可視化など、多くの領域で 使用される。例えば、顔認識では、顔画像の高次元データを低次元に圧縮することで 計算量を削減し、効率的に識別を行う。 以下のコードスニペットは、Pythonのscikit-learnライブラリを用いてPCAを行う例で ある。

from sklearn.decomposition import PCA from sklearn.datasets import load_iris import matplotlib.pyplot as plt # Irisデータセットのロード iris = load_iris() X = iris.data # PCAの適用、2次元に削減 pca = PCA(n_components=2) X_pca = pca.fit_transform(X) # 結果のプロット plt.scatter(X_pca[:, 0], X_pca[:, 1], c=iris.target) plt.xlabel('First principal component') plt.ylabel('Second principal component') plt.title('PCA on Iris Dataset') plt.show() 上記のコードは、Irisデータセットに対してPCAを適用し、もとの4次元データを2次 元に削減して可視化する例である。プロットされたグラフを見ることで、データの分 布やクラスの分離度を視覚的に確認することができる。 特異値分解 定義や意味 特異値分解(SVD: Singular Value Decomposition)は、線形代数における行列分解の 一種である 任意のm × n行列Aは以下のように分解できる: A = U ΣV T ここで: U はm × mの直交行列 Σはm × nの対角行列で、その対角成分が特異値と呼ばれる V T はn × nの直交行列の転置 特異値は非負の実数であり、行列の固有値の一般化である

嚙み砕いた説明 特異値分解は行列を3つの異なる行列の積に分解し、行列の構造に関する重要な情報 を抽出する手法 直交行列U とV は回転または反転を表し、Σはスケーリング(拡大縮小)を表す 特異値は行列がどの程度の情報を持っているか、またはどの程度の次元が独立してい るかを示す 実際の応用例 特異値分解は画像圧縮、データの次元削減、ノイズ除去、推薦システムなどで応用さ れる scikit-learnを用いてデータの次元削減を行う例を示す from sklearn.decomposition import TruncatedSVD from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.pipeline import make_pipeline from sklearn.preprocessing import Normalizer import numpy as np # サンプルデータ documents = [ "This is the first document.", "This document is the second document.", "And this is the third one.", "Is this the first document?" ] # TF-IDFでテキストをベクトル化 vectorizer = TfidfVectorizer(stop_words='english') X = vectorizer.fit_transform(documents) # 特異値分解による次元削減 svd = TruncatedSVD(n_components=2) normalizer = Normalizer(copy=False) lsa = make_pipeline(svd, normalizer) X_reduced = lsa.fit_transform(X) print("Reduced Data:") print(X_reduced) # 次元数を指定

このコードではscikit-learnの TruncatedSVD を用いて、TF-IDFでベクトル化したテキス トデータを2次元に削減している 特異値分解により、元の高次元データを低次元に圧縮しつつ、データの本質的な情報 を保持することが可能