【論文サーベイ】Survey on Class-Incremental Learning (CIL)

332 Views

January 13, 25

スライド概要

Web Developer / Research on generative models and continual learning

関連スライド

各ページのテキスト

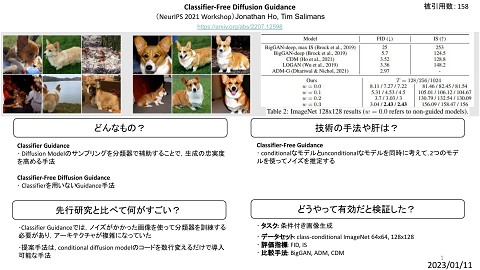

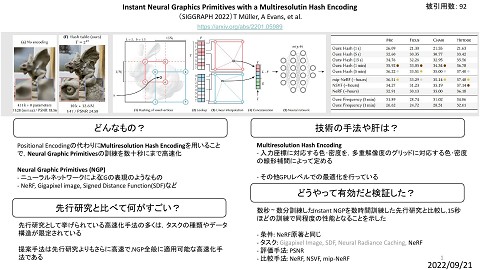

Survey on Class-Incremental Learning Deep Class-Incremental Learning: A Survey Da-Wei Zhou, Qi-Wei Wang, Zhi-Hong Qi, Han-Jia Ye, De-Chuan Zhan, Ziwei Liu [arxiv’23] 1

Background Continual Learning 段階的に新しいタスクを学習するタスク 学習はタスクごとに行い それ以前のタスクのデータは使わない? 2

Background Class-Incremental Learning (CIL) 鳥 or 犬 トラ or 金魚 猿 or 羊 2クラス分類 4クラス分類 6クラス分類 段階的に新しいタスク を学習するタスク 段階的に未知のクラスが現 学習はタスクごとに行い れるタスク それ以前のタスクのデータは使わない? テストには観測された全てのデータを使う 3

Background Catastrophic Forgetting CILを含めて Continual Learning では Catastrophic Forgetting が最大の課題となる - 新しいタスクを学習すると,それ以前に学習したタスクを忘れてしまう現象 クラスを増やして学習すると 著しく精度が下がる 4

CILの研究分野 https://github.com/zhoudw-zdw/CIL_Survey/blob/main/resources/taxonomy_fig.png?raw=true 5

[Data-Centric CIL – Data Replay] GR - 過去のタスクの学習データをGeneratorで再現することで忘却を防ぐ - 学習データとGeneratorの生成データを合わせてGeneratorを学習,これを繰り返す Continual Learning with Deep Generative Replay [H. Shin et al. NIPS2017] 6

[Data-Centric CIL – Data Regularization] GEM - 各タスクごとにデータセットから episode memory というサブセットを保持する - 過去のタスクの episode memory から損失の勾配を計算する - 全てのタスクの勾配と現在のタスクの損失の勾配との内積が正になるように 制約をかける - (最近はあまり研究されていない) Gradient Episodic Memory for Continual Learning [D. Lopez-Pazet al. NIPS2017] 7

[Data-Centric CIL] 課題 Data Replay 分類精度がGeneratorの生成品質の影響を受ける - - Generatorの生成品質を上げると学習コストが大きくなるので扱いにくい GeneratorにもCatastrophic Forgettingが起こるため不安定 - Data Regularization - episode memoryの選び方によって精度に差が出る - プライバシーの問題から過去のデータを保持できないことがある 8

[Model-Centric CIL – Dynamic Networks] DEN - - DNNはタスク固有の特徴を捉える傾向にある - クラスcarがタスクに含まれればタイヤや窓の特徴を捉える - クラスcatが追加されると髭や模様の特徴を捉えるように上書きされてしまう ネットワークの構造を変えて表現力を上げたほうが良い - 損失が閾値を超えたらネットワークの構造を変える LIFELONG LEARNING WITH DYNAMICALLY EXPANDABLE NETWORKS [J. Yoon et al. ICLR2018] 9

[Model-Centric CIL – Parameter Regularization] EWC - モデルの各パラメータの重要度を表すimportance matrix を定義する - 重要なパラメータが変化しづらくなるような正則化項 を加える パラメータkの重要度 タスクをまたいだ パラメータの変化 Overcoming catastrophic forgetting in neural networks [J. Kirkpatrick et al. PNAS2017] 10

[Model-Centric CIL] 課題 Dynamic Networks - タスク向けにどのようにネットワークを変えればよいか決まっていない - メモリ使用量が大きくなる Parameter Regularization - importance matrix はパラメータ数の分だけ大きくなるので,メモリ使用量が大きい - 正規化項のせいで最適化がうまくいかなかったりする - あまり精度が出ない 11

[Algorithm-Centric CIL – Knowledge Distillation] LwF - k - 1番目のタスクを学習したモデルをold modelとして保持しておく - old modelの重みを凍結し,損失関数に制約項を加える - 過去に登場したクラスについての予測がold / new modelで同じになるようにする old model softmax new model Learning without Forgetting [L. Li et al. ECCV2016] 12

[Algorithm-Centric CIL] 課題 Knowledge Distillation - dynamic networkに比べてcatastrophic forgettingに陥りやすい - メモリ使用量は小さめ 13

0クラスから5ずつ増やす 0クラスから10ずつ増やす 実験 CIFAR-100 parameter regulation data-centric data regulation data replay knowledge distillation algorithm-centric model rectify model-centric dynamic networks パラメータ数 全タスクの 最終的な 平均精度 精度 14

実験 dynamic network系の手法は 精度劣化が小さい 15

CILの既存研究 16