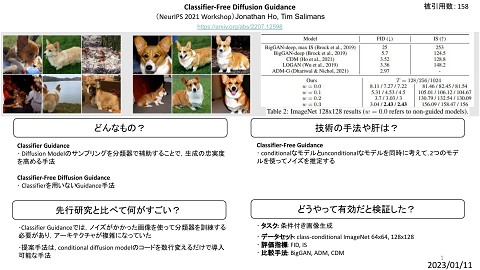

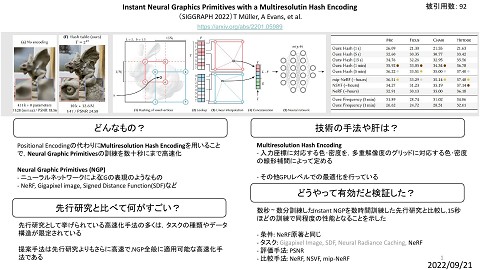

【論文サーベイ】Survey on Adapter Networks for Diffusion Models

2.6K Views

January 25, 24

スライド概要

Web Developer / Research on generative models and continual learning

関連スライド

各ページのテキスト

Survey on Adapter Networks for Diffusion Models LoRA: Low-Rank Adaptation of Large Language Models E. Hu, Y. Shen, P. Wallis, Z. Allen-Zhu, Y. Li, S. Wang, L. Wang, W. Chen [ICLR’22] Adding Conditional Control to Text-to-Image Diffusion Models L. Zhang, A. Rao, M. Agrawala [ICCV’23] T2I-Adapter: Learning Adapters to Dig out More Controllable Ability for Text-to-Image Diffusion Models C. Mou, X. Wang, L. Xie, Y. Wu, J. Zhang, Z. Qi, Y. Shan, X. Qie [AAAI’24] 1

Background (1 / 2) Stable Diffusionの応用 Stable Diffusionを下流タスク向けに再学習するにはコストが大きすぎる 現状,再学習を回避したアプローチは3つある - SDEdit ベースのアプローチ - Inversionベースのアプローチ (Textual Inversionなど) - Adapterベースのアプローチ 2

Background (2 / 2) Adapter Network - 大規模言語モデルの世界では Adapter Network と呼ばれる系統の手法が提 案されてきた - Adapter Network は大規模モデルに小さいネットワーク (Adapter) を 挿入し Adapter のみを再学習する手法 - 近年 Stable Diffusion 向けの Adapter Network も提案されてきた 3

LoRA: Low-Rank Adaptation of Large Language Models E. Hu, Y. Shen, P. Wallis, Z. Allen-Zhu, Y. Li, S. Wang, L. Wang, W. Chen [ICLR’22] 大規模モデルを高速にチューニングする手法 精度はFine-Tuningに匹敵する 4

Methods: Low-Rank Adaptation 大規模モデルの再学習はコストが膨大なので 小さいサブネットワーク (LoRA層) を挿入し, LoRA層のみチューニングする 5

Methods: LoRA層 学習済みの重み (固定) 重みの更新を低ランク分解する ( ) とすれば は よりもパラメータ数が少なくなる だけ更新してみる 6

Methods: 備考 重みの初期値 は0, は乱数で初期化する は0で初期化される (最近0で初期化するレイヤーをよく見かける) LoRA層の積み重ね LoRAは行列 を足すだけで実現できるため,容易に連結できる 7

Results パラメータ数が1/355でありながらFine Tuningに匹敵する精度 8

Theory のいくつかの特徴量は,既に に含まれていることがわかった LoRA層は下流タスクのために基盤モデルの重要な特徴を増幅させるように働くこ とを示唆 最適な の値,LoRA層を挿入する場所についても言及 9

Adding Conditional Control to Text-to-Image Diffusion Models L. Zhang, A. Rao, M. Agrawala [ICCV’23] (ControlNet) 拡散モデルをCanny edgeやhuman poseで指定して生成できるようにする手法 10

Methods: ControlNet 1. 基盤モデルの重みを凍結 2. Diffusion Modelのエンコーダをコピー (ControlNet) 3. conditionをつけてControlNetを学習 4. Diffusion Modelのデコーダに注入 11

Methods: zero-convolution [Nichol+, PMLR’21] 0で初期化した1x1 convolution layer connection layerの初期重みがランダムだと 学習初期時の勾配計算に悪影響が出る 0で初期化 ControlNetの学習はzero-convolutionのせいで 突然生成画像が変わるタイミングが出来る 12

Results (without prompt) 13

Ablation Study zero-convolution layerの効果 zero-conv not zero-conv 14

Comparison 比較手法 PITI 様々なタスクの条件付き生成を 同じDiffusion Modelで学習したもの - Sketch-Guided Diffusion - Taming Transformer 15

Discussion データセットのサイズが小さくても構図制御は出来る 16

T2I-Adapter: Learning Adapters to Dig out More Controllable Ability for Text-to-Image Diffusion Models C. Mou, X. Wang, L. Xie, Y. Wu, J. Zhang, Z. Qi, Y. Shan, X. Qie [AAAI’24] ControlNetと同時期に発表された ControlNetとほぼ同じ手法 17

Methods 全体像 T2I-Adapterをエンコーダ部分に挿入 18

Methods T2I-Adapter 1. 入力は512x512のcondition map 2. Pixel Unshuffleという手法で64x64にダウンサンプリング 3. ConvとRB (Residual Block) で4段階にダウンサンプリング ControlNetよりも遥かに小さいAdapter (ControlNetと比較実験していないので性能はなんともいえない) 19

Experiment 実験に使用した condition - semantic segmentation map - color - keypoints - depth maps 20

Result 21

ControlNetとの違い - 複数のcondition mapを同時に使えるように学習されている - MMPoseを使用している (ControlNetではOpenPose) 22